Доброго времени суток, друзья. Сегодня я хочу рассказать вам о настройке Screaming Frog (он же SF, он же краулер, он же паук, он же парсер — сразу определимся со всеми синонимами, ок?).

SF — очень полезная программа для анализа внутрянки сайтов. С помощью этой утилиты можно быстро выцепить технические косяки сайта, чтобы составить грамотное ТЗ на доработку. Но чтобы увидеть проблему, надо правильно настроить краулера, верно? Об этом мы сегодня с вами и поговорим.

- Примечание автора: сразу скажу — программа имеет много вкладок и настроек, которые по сути не нужны рядовому пользователю, потому я подробно опишу только наиболее важные моменты, а второстепенные пройдем вскользь… хотя кого я обманываю, когда это у меня были статьи меньше 30 к символов? *Зануда mode on*

- Примечание автора 2: при написании статьи я пользовался дополнительными материалами в виде официального мануала от разработчиков. Если что, почитать его можно тут https://www.screamingfrog.co.uk/seo-spider/user-guide/. Не пугайтесь английского, Google-переводчик в помощь — вполне себе сносная адаптация получается.

- Примечание автора 3: я люблю оставлять примечания…

- File

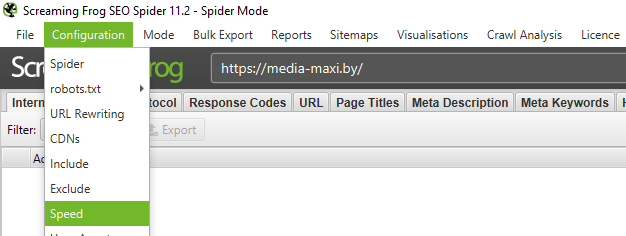

- Configuration

- Spider — настройки парсинга сайта

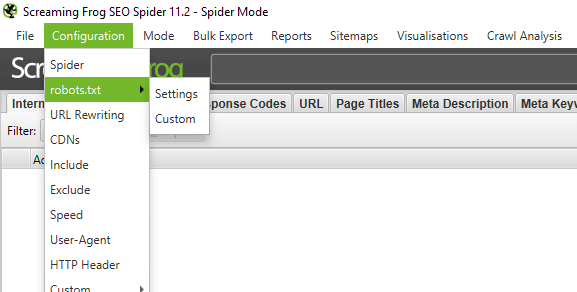

- Robots.txt — определяем каким правилам следовать при парсинге

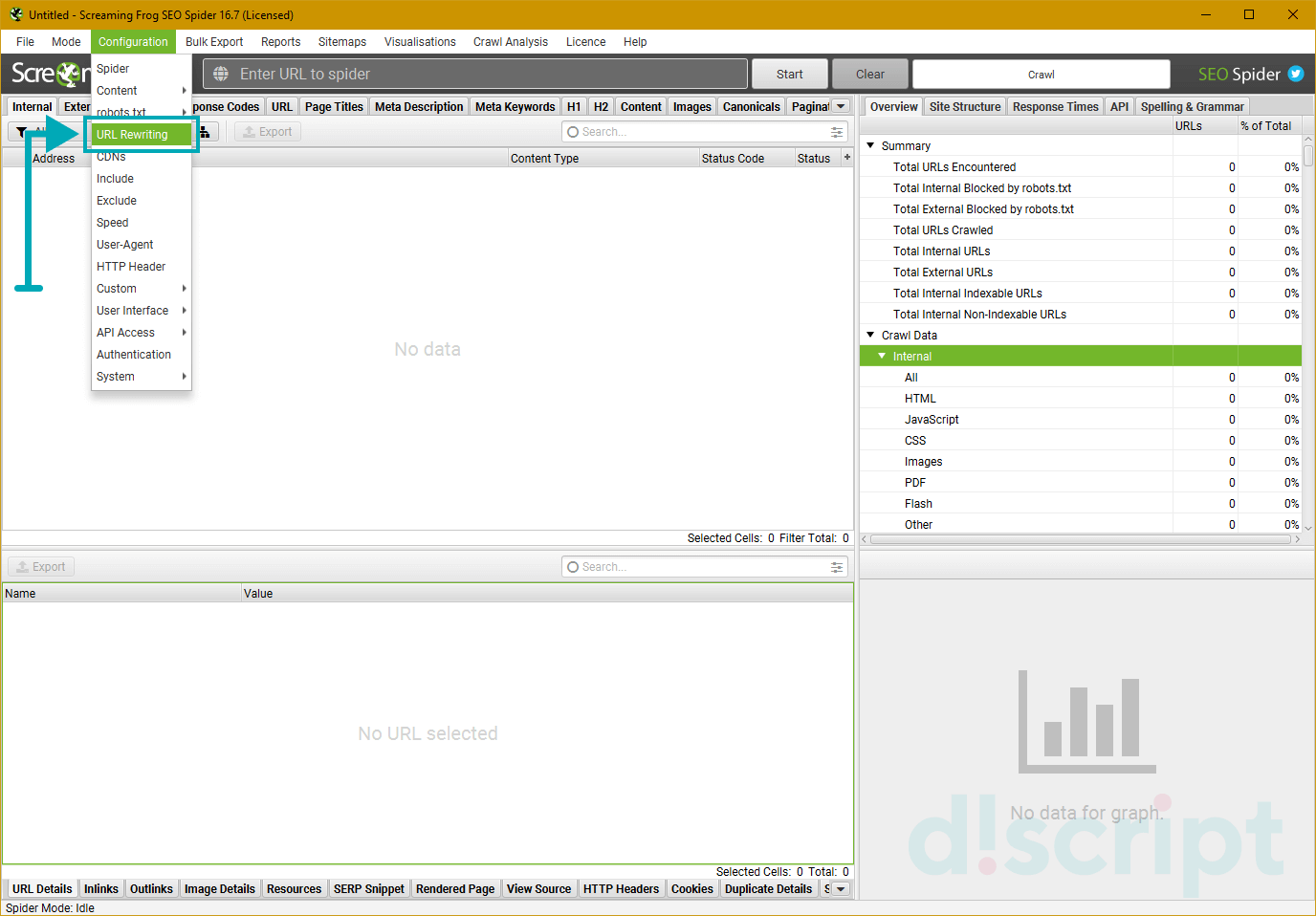

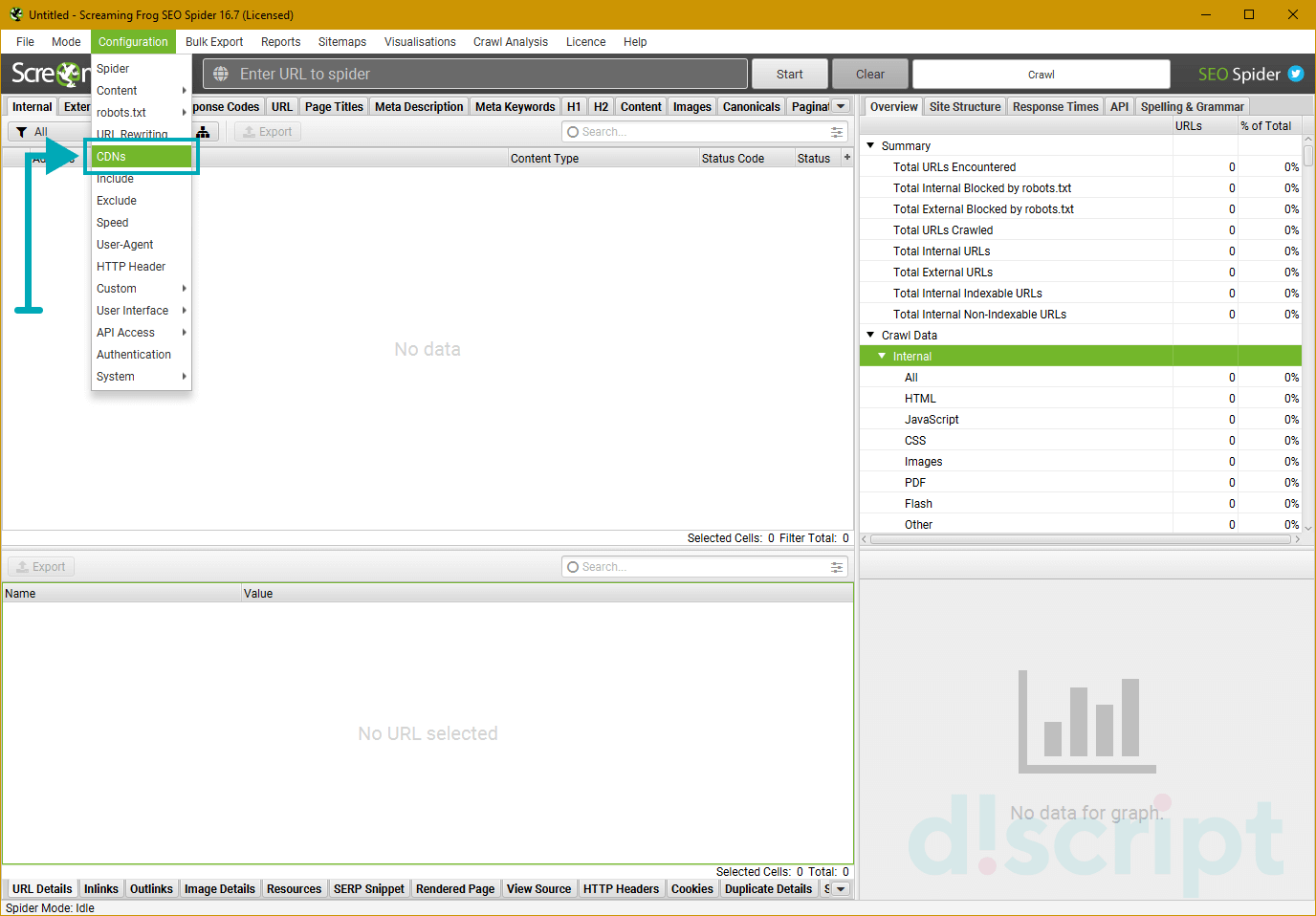

- URL Rewriting — функция перезаписи URL

- CDNs — парсим поддомены

- Include/Exclude — сканирование/удаление определенных папок

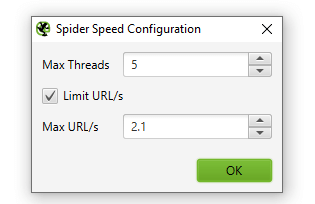

- Speed — регулируем скорость парсинга сайта

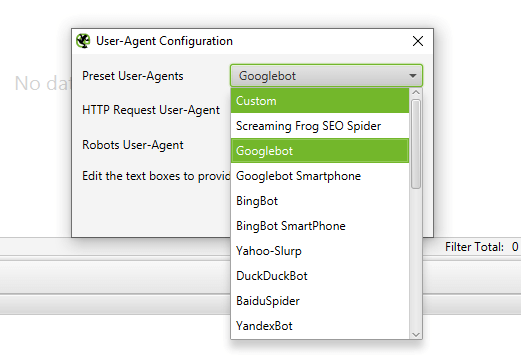

- User-Agent — выбираем под кого маскируемся

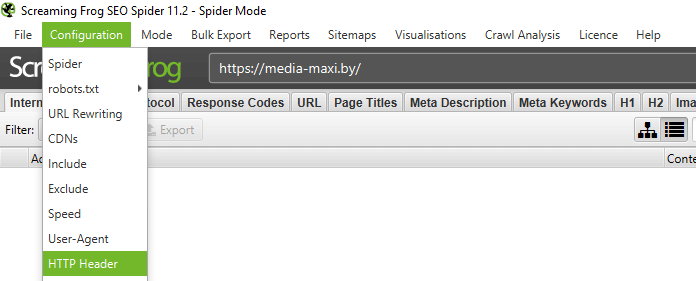

- HTTP Header — настройка реагирования на разные http-заголовки

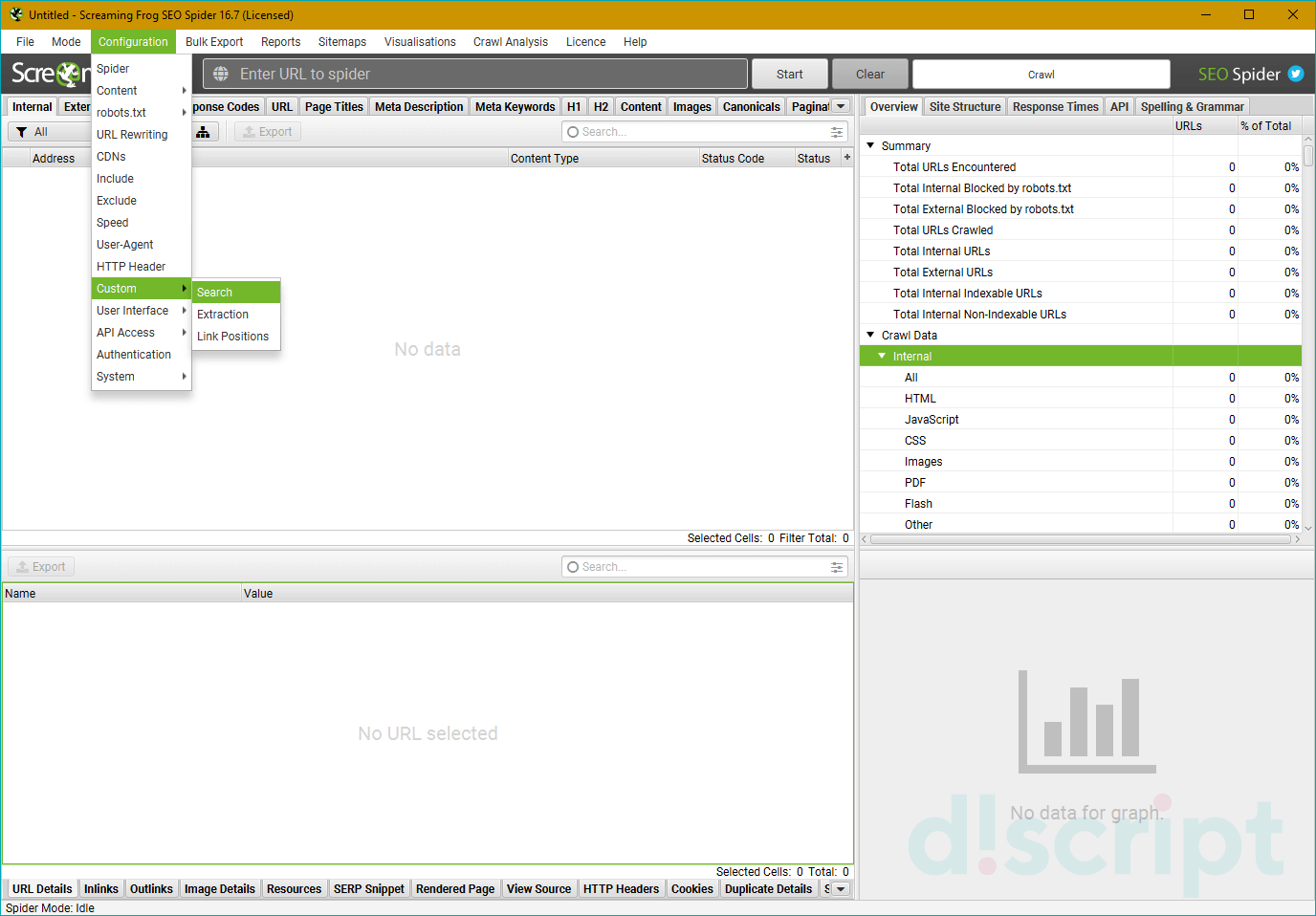

- Custom — дополнительные настройки поиска

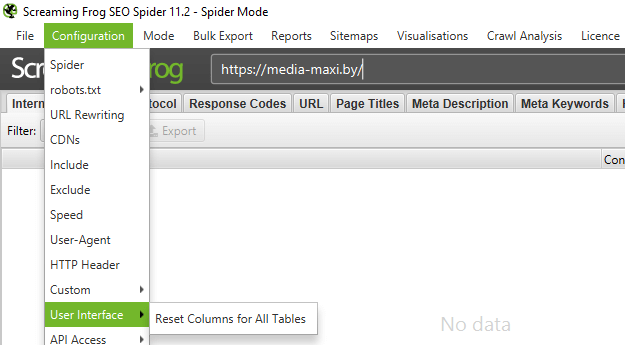

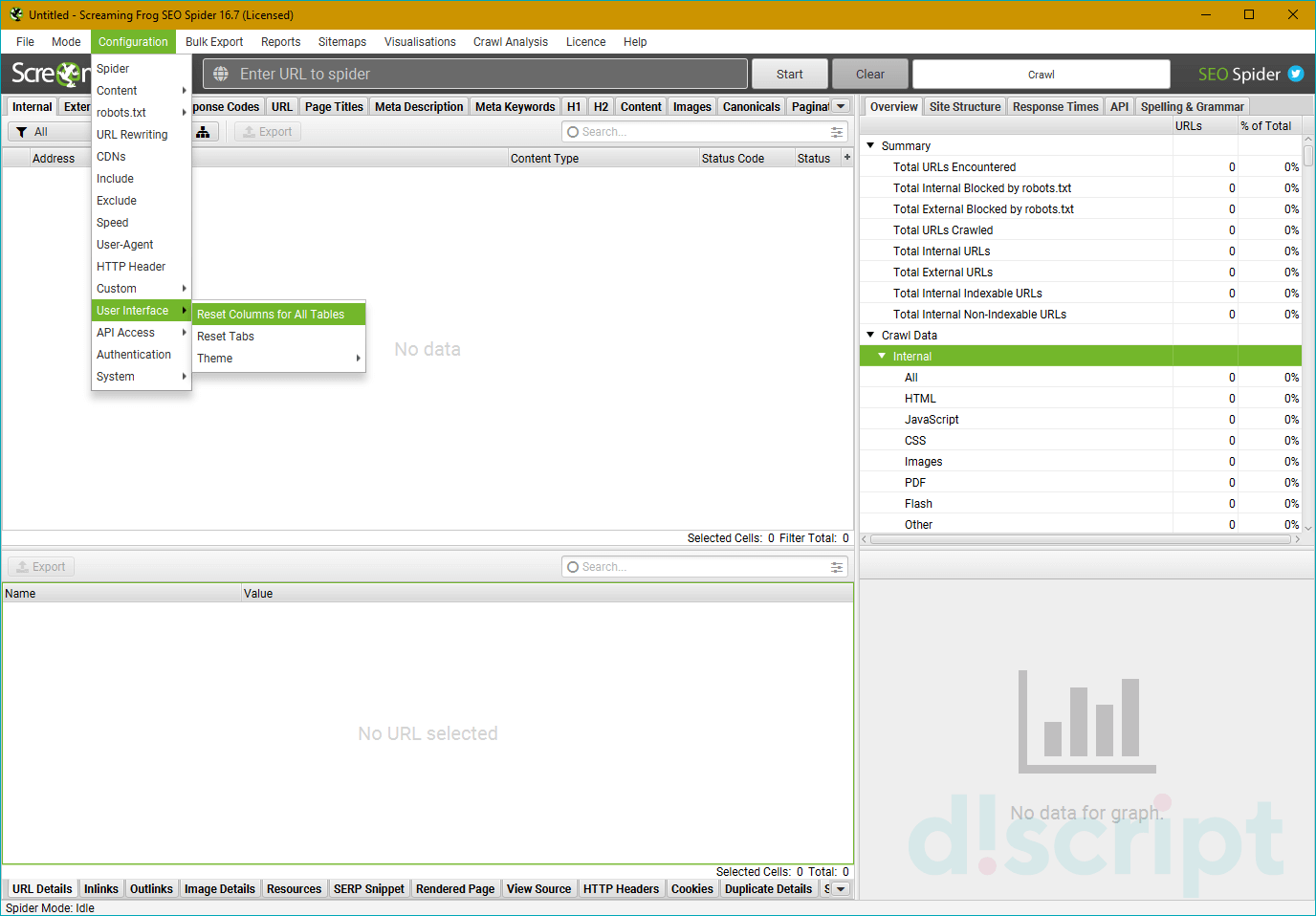

- User Interface — обнуление настроек для колонок таблицы

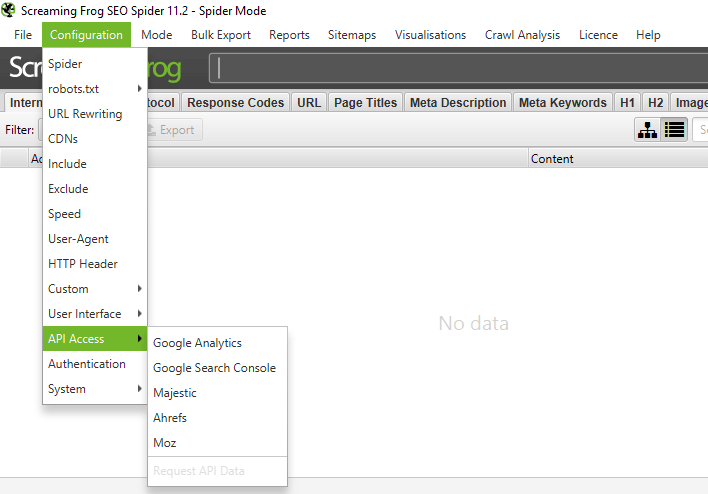

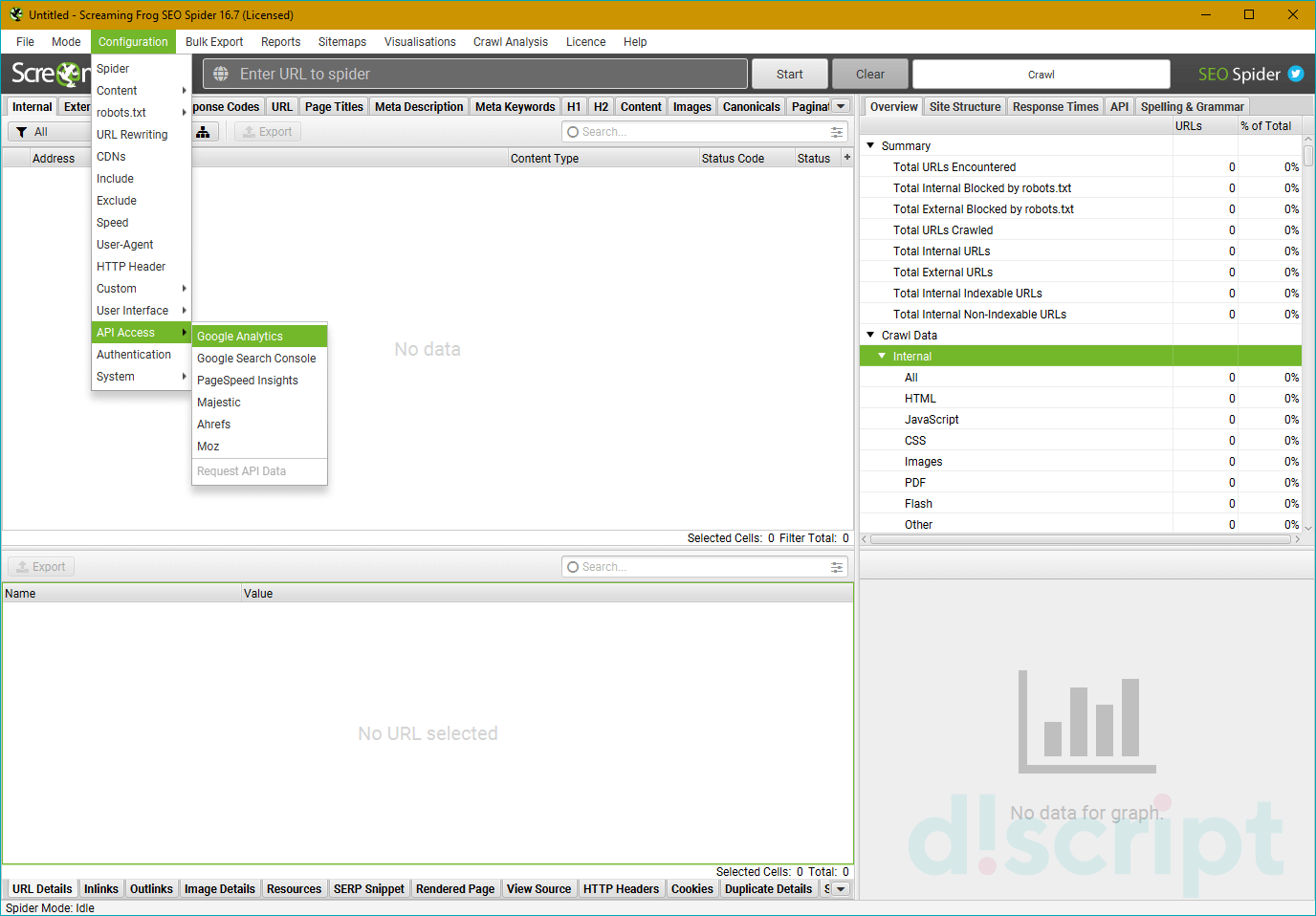

- API Access — интеграция с разными сервисами

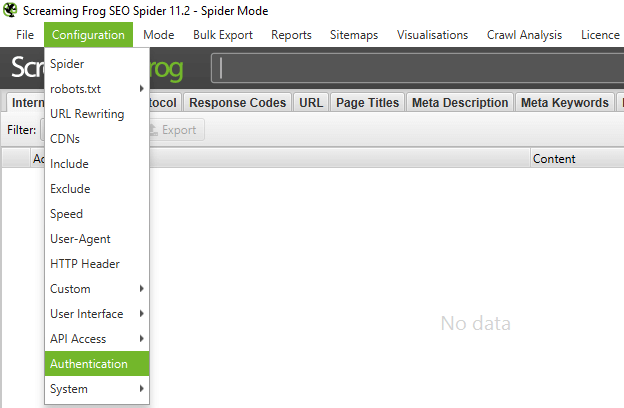

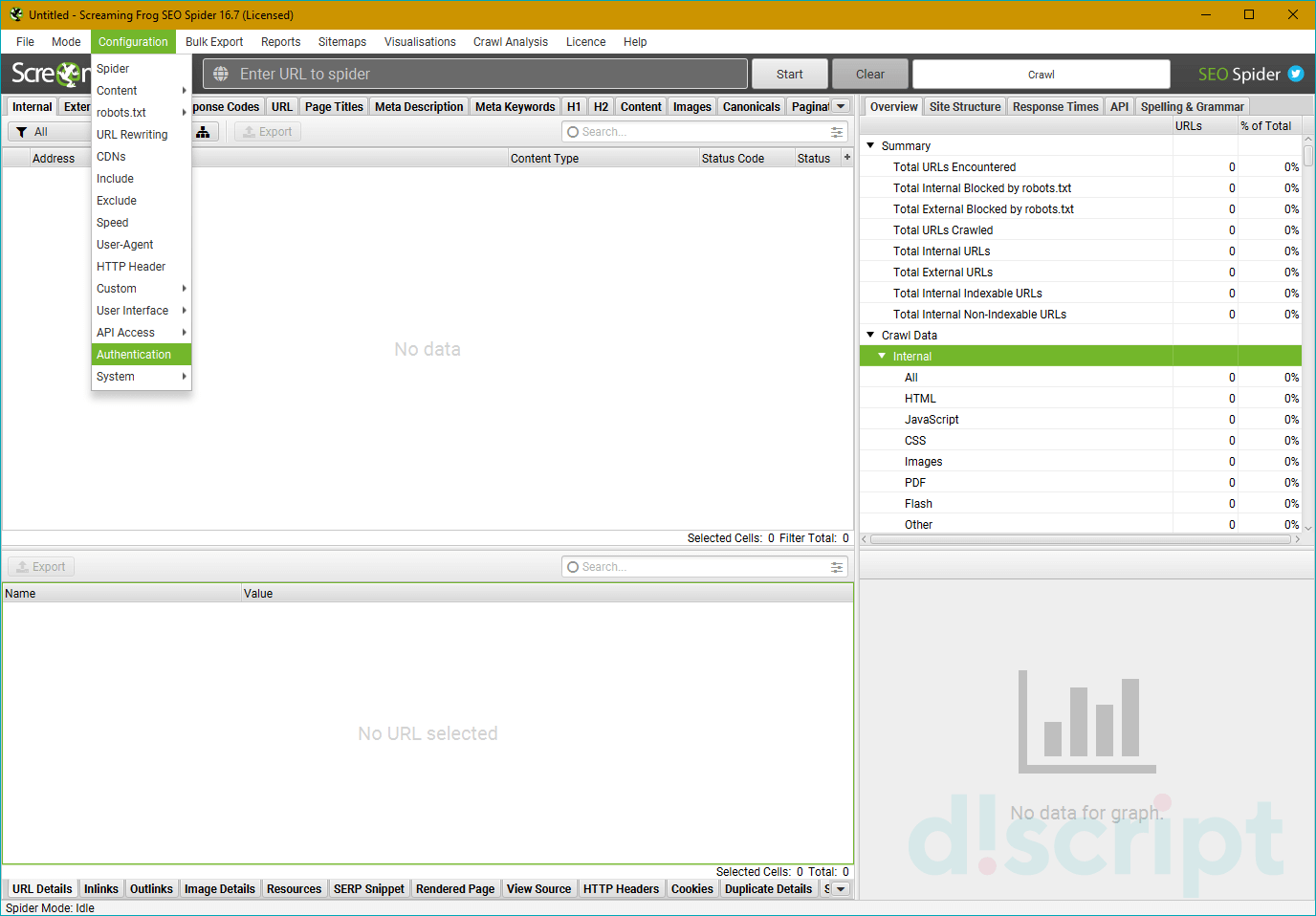

- Authentification — настройки аутентификации

- System — внутренние настройки самой программы

- Mode

- Bulk export

- Reports

- Sitemaps

- Visualisations

- Crawl Analysis

- License

- Help

Настройка Screaming Frog по шагам

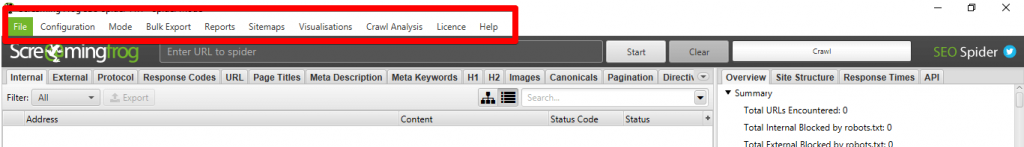

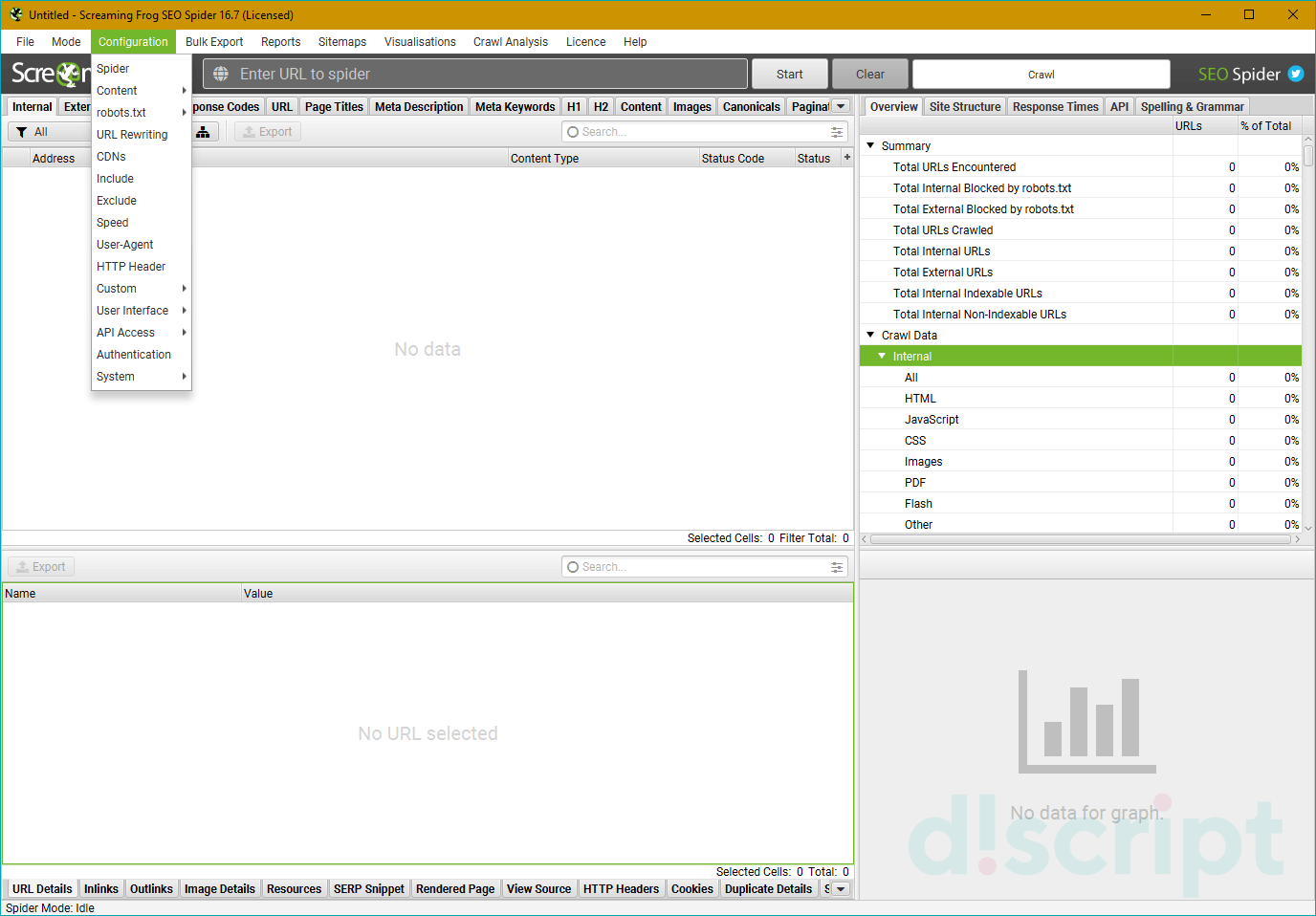

Рассмотрим основное меню программы, для того чтобы понимать что где лежит и что за что отвечает (тавтология… Вова может в копирайт!).

Верхнее меню — управление парсингом, выгрузкой и многое другое

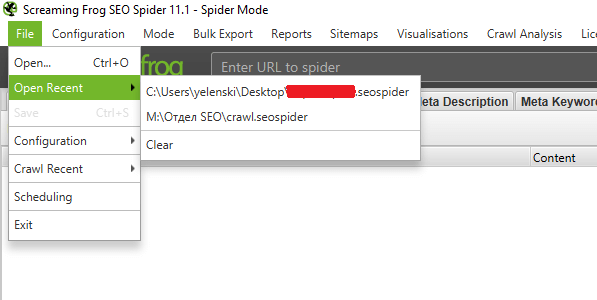

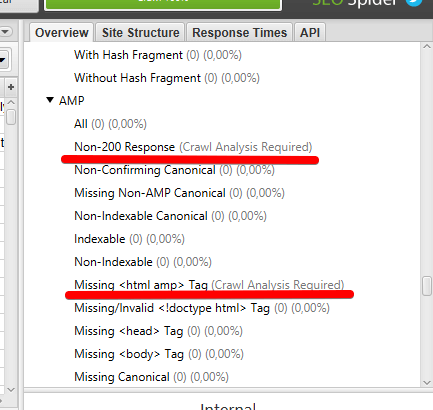

File

Из названия понятно, что это работа с файлами программы (загрузка проектов, конфиги, планирование задач — что-то вроде того).

- Open — открыть файл с уже проведенным парсингом.

- Open Recent — открыть последний парсинг (если вы его сохраняли отдельным файлом).

- Save — собственно, сохранить парсинг.

- Configuration — загрузка/сохранение специальных настроек парсинга вроде выведения дополнительных параметров проверки и т.д. (про то, как задавать эти настройки, я далее расскажу подробнее).

- Crawl Recent — повторно парсить один из последних сайтов, который уже проверялся в этой программе.

- Scheduling — отложенное планирование задач для программы… ни разу не пользовался этой опцией…стыдно.

- Exit — призвать к ответу Друзя… нет, ну серьезно,тут все очевидно.

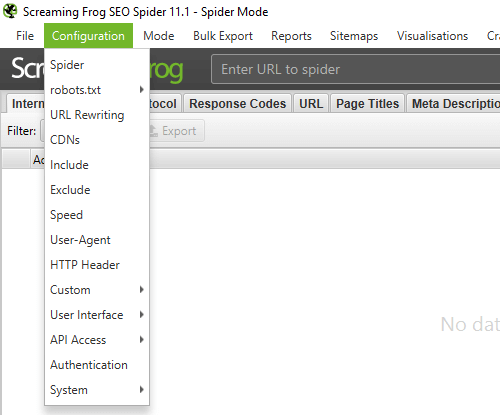

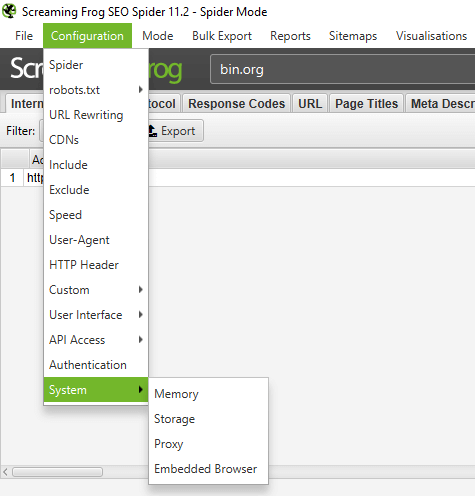

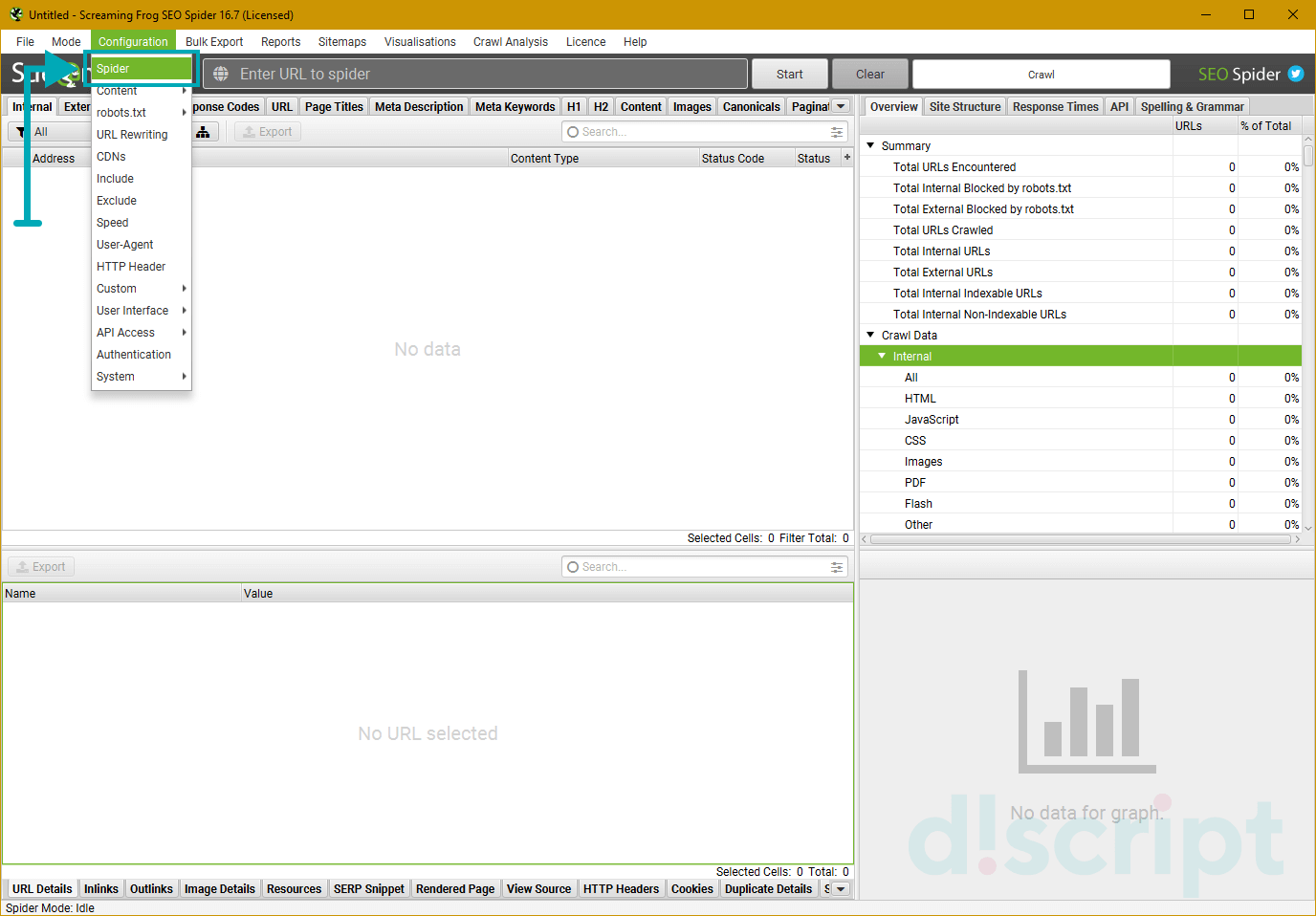

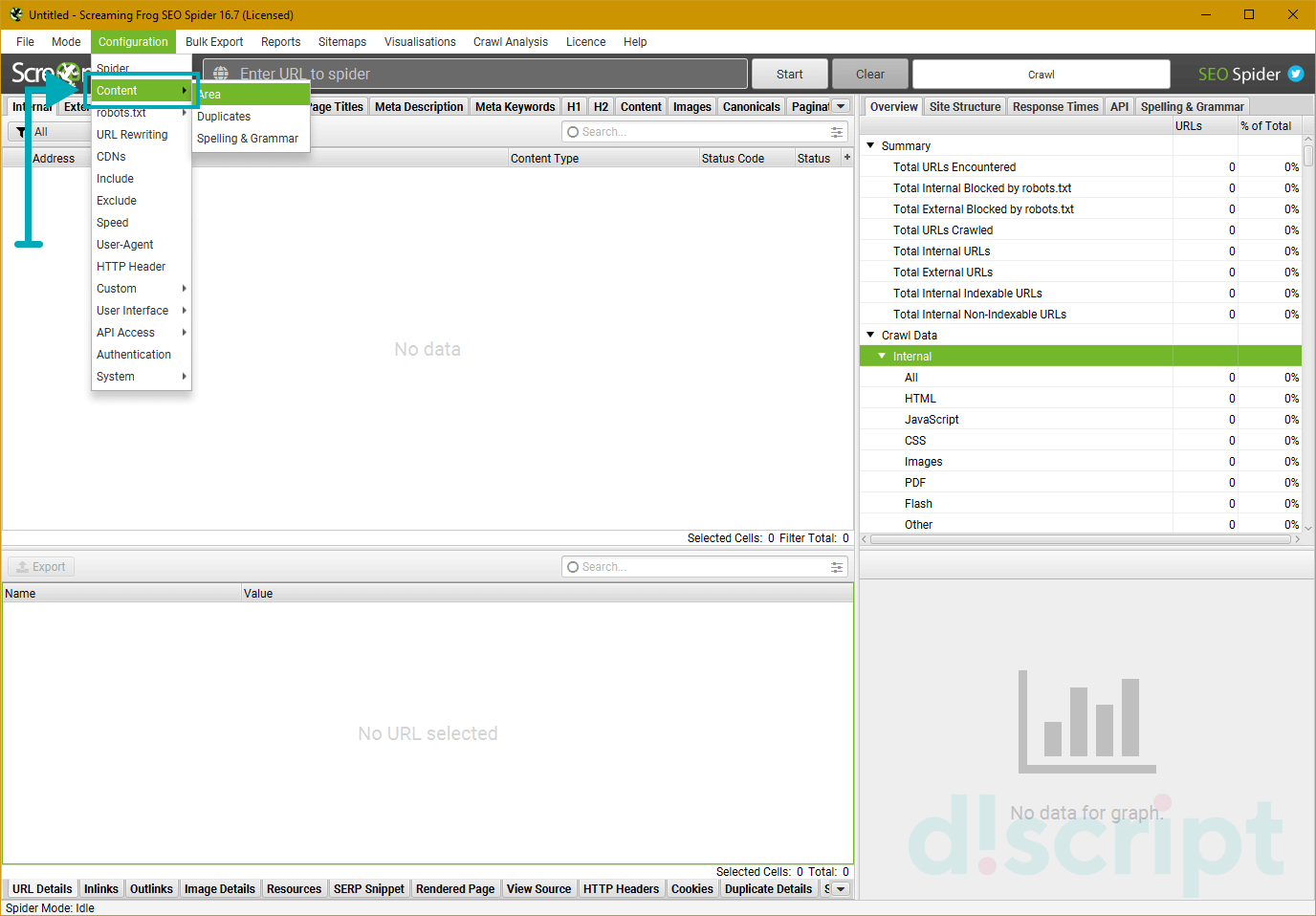

Configuration

Один из самых интересных и важных пунктов меню, тут мы задаем настройки парсинга.

Ох, сейчас будет сложно — у многих пунктов есть подпункты, у этих подпунктов всплывающие окна с вкладками и кучей настроек…в общем крепитесь, ребята, будет много инфы.

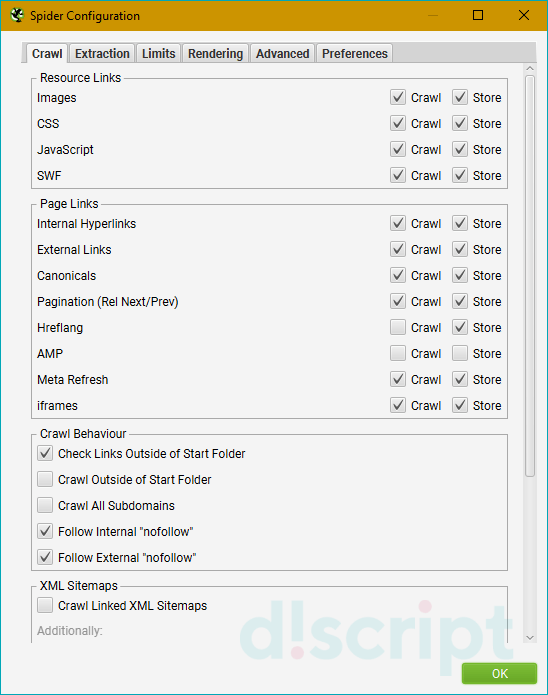

Spider — собственно, настройки парсинга сайта

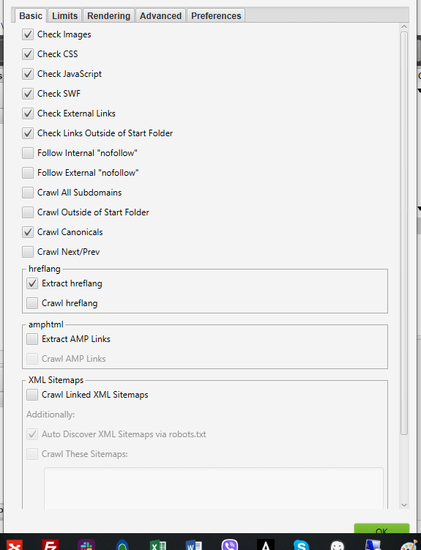

Вкладка Basic — выбираем что парсить

- Check Images — в отчет включаем анализ картинок.

- Check CSS — в отчет включаем анализ css-файлов (скрипты).

- Check JavaScript — в отчет включаем анализ JS-файлов (скрипты).

- Check SWF — в отчет включаем анализ Flash-анимации.

- Check External Link — в отчет включаем анализ ссылок с сайта на другие ресурсы.

- Check Links Outside of Start Folder — проверка ссылок вне стартовой папки. Т.е. отчет будет только по стартовой папке, но с учетом ссылок всего сайта.

- Follow internal “nofollow” — сканировать внутренние ссылки, закрытые в тег “nofollow”.

- Follow external “nofollow” — сканировать ссылки на другие сайты, закрытые в тег “nofollow”.

- Crawl All Subdomains — парсить все поддомены сайта, если ссылки на них встречаются на сканируемом домене.

- Crawl Outside of Start Folder — позволяет сканировать весь сайт, однако проверка начинается с указанной папки.

- Crawl Canonicals — выведение в отчете атрибута rel=”canonical” при сканировании страниц.

- Crawl Next/Prev — выведение в отчете атрибутов rel=”next”/”prev” при сканировании страниц пагинации.

- Extract hreflang/Crawl hreflang — при сканировании учитываются языковой атрибут hreflang и отображаются коды языка и региона страницы + формирование отчета по таким страницам.

- Extract AMP Links/Crawl AMP Links — извлечение в отчет ссылок с атрибутом AMP (определение версии контента на странице).

- Crawl Linked XML Sitemap — сканирование карты сайта. Тут краулер либо берет sitemap из robots.txt (Auto Discover XML Sitemap via robots.txt), либо берет карту по указанному пользователем пути (Crawl These Sitemaps).

Ну что, сложно? На самом деле просто нужна привычка и немного практики, чтобы освоить основные настройки SF и понять что нужно использовать в конкретных случаях, а от чего можно отказаться. Все, передохнули, теперь дальше… будет проще (нет).

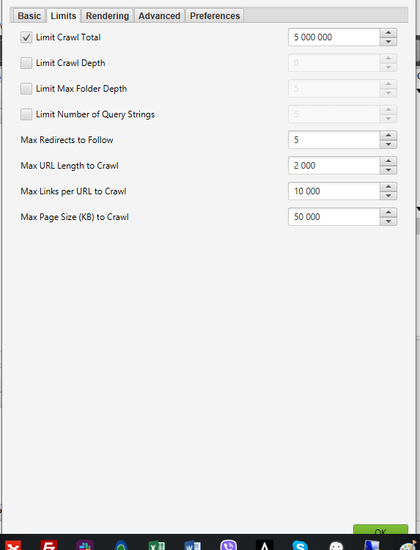

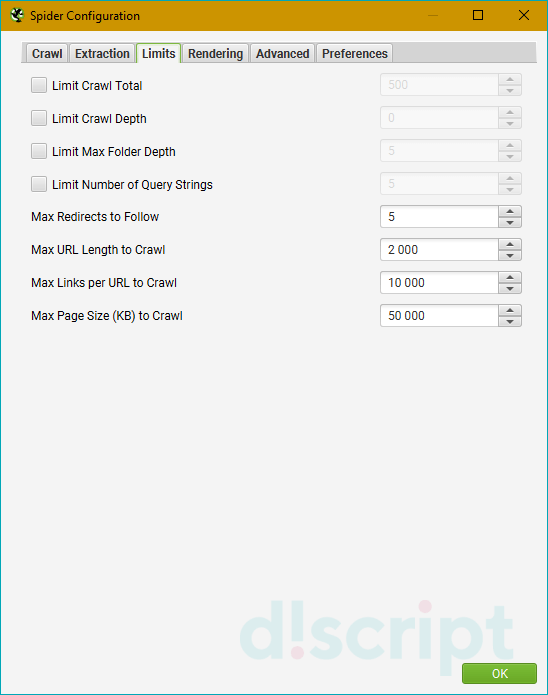

Вкладка Limits — определяем лимиты парсинга

- Limit Crawl Total — задаем лимиты страниц для сканирования. Сколько всего страниц выгружаем для одного проекта.

- Limit Crawl Depth — задаем глубину парсинга. До какого уровня может дойти краулер при сканировании проекта.

- Limit Max Folder Depth — можно контролировать глубину парсинга вплоть до уровня вложенности папки.

- Limit Number of Query Strings — тут, если честно, сам не до конца разобрался, потому объясню так, как понял — мы ограничиваем лимит страниц с параметрами. Другими словами, если на одной статической странице есть несколько фильтров, то их комбинация может породить огромное количество динамических страниц. Вот чтобы такие “полезные” страницы не парсились (увеличивает время анализа в разы, а толковой информации по сути ноль), мы и выводим лимиты по Query Strings. Пример динамики — site.ru/?query1&query2&query3&queryN+1.

- Max Redirects to Follow — задаем максимальное количество редиректов, по которым паук может переходить с одного адреса.

- Max URL Length to Crawl — максимальная длина URL для обхода (указываем в символах, я так понимаю).

- Max Links per URL to Crawl — максимальное количество ссылок на URL для обхода (указываем в штуках).

- Max Page Size (KB) to Crawl — максимальный размер страницы для обхода (указываем в килобайтах).

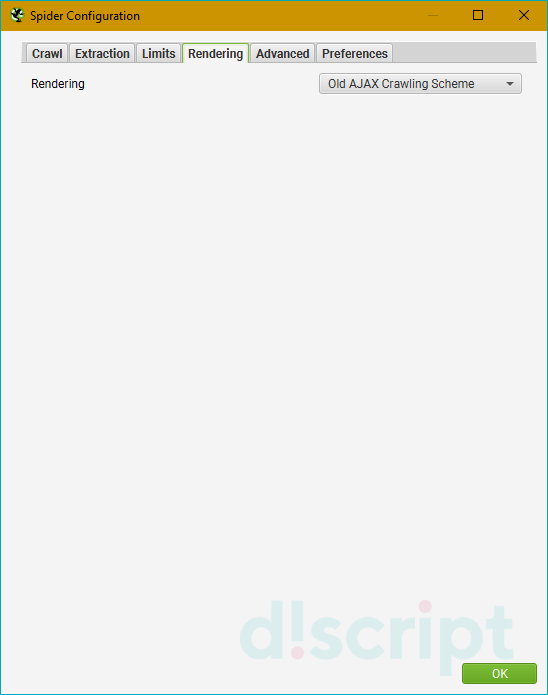

Вкладка Rendering — настраиваем параметры рендеринга (только для JS)

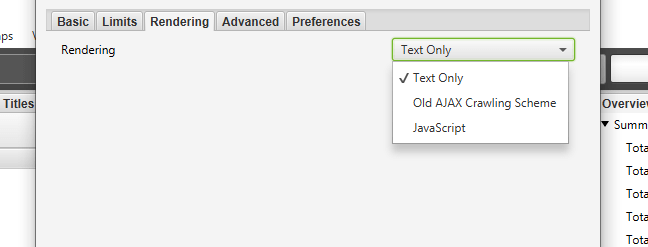

На выбор три опции — “Text Only” (паук анализирует только текст страницы, без учета Аякса и JS), “Old AJAX Crawling Scheme” (проверяет по устаревшей схеме сканирования Аякса) и “JavaScript” (учитывает скрипты при рендеринге). Детальные настройки есть только у последнего, их и рассмотрим.

- Enable Rendered Page Screen Shots — SF делает скриншоты анализируемых страниц и сохраняет их в папке на ПК.

- AJAX Timeout (secs) — лимиты таймаута. Как долго SEO Spider должен разрешать выполнение JavaScript, прежде чем проверять загруженную страницу.

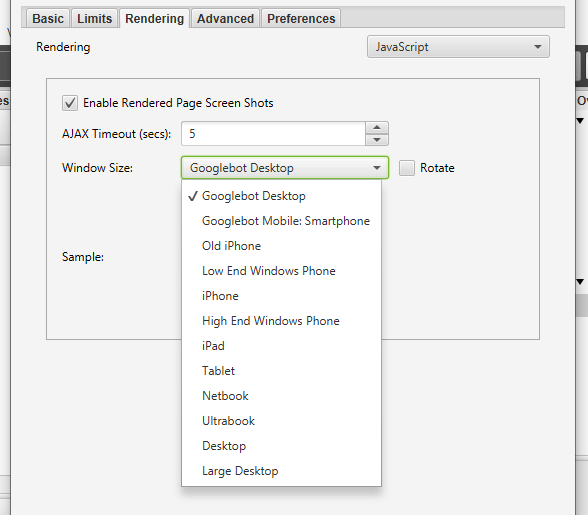

- Window Size — выбор размера окна (много их — смотрим скриншот).

- Sample — пример окна (зависит от выбранного Window Size).

- Чекбокс Rotate — повернуть окно в Sample.

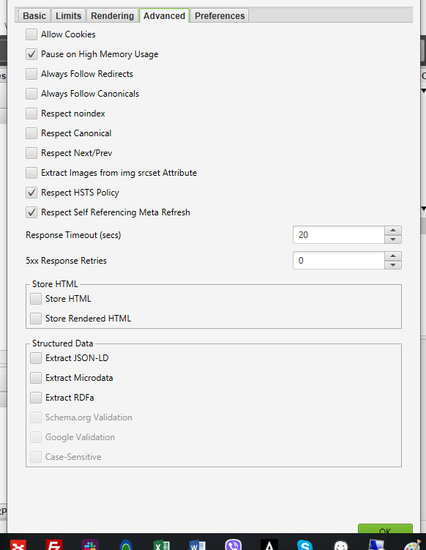

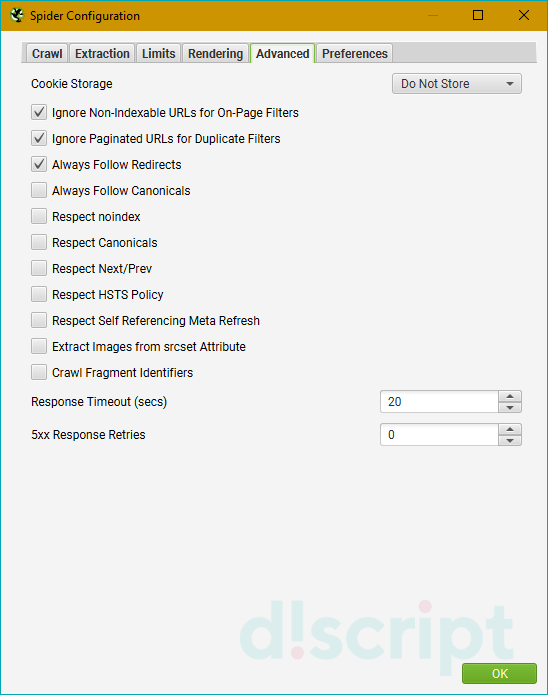

Вкладка Advanced — дополнительные опции парсинга

- Allow Cookies — учитывать Cookies, как это делает поисковый бот.

- Pause on High Memory Used — тормозит сканирование сайта, если процесс забирает слишком много оперативной памяти.

- Always Follows Redirect — разрешаем краулеру идти по редиректам вплоть до финальной страницы с кодом 200, 4хх, 5хх (по факту все ответы сервера, кроме 3хх).

- Always Follows Canonicals — разрешаем краулеру учитывать все атрибуты “canonical” вплоть до финальной страницы. Полезно, если на страницах сайта бардак с настройкой этого атрибута (например, после нескольких переездов).

- Respect Noindex — страницы с “noindex” не отображаются в отчете SF.

- Respect Canonical — учет атрибута “canonical” при формировании итогового отчета. Полезно, если у сайта много динамических страниц с настроенным rel=”canonical” — позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Respect Next/Prev — учет атрибутов rel=”next”/”prev” при формировании итогового отчета. Полезно, если у сайта есть страницы пагинации с настроенными “next”/”prev”- позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Extract Images from img srscet Attribute — изображения извлекаются из атрибута srscet тега <img>. SRSCET — атрибут, который позволяет вам указывать разные типы изображений для разных размеров экрана/ориентации/типов отображения.

- Respect HSTS Policy — если чекбокс активен, SF будет выполнять все будущие запросы через HTTPS, даже если перейдет по ссылке на URL-адрес HTTP (в этом случае код ответа будет 307). Если же чекбокс неактивен, краулер покажет «истинный» код состояния за перенаправлением (например, постоянный редирект 301).

- Respect Self Referencing Meta Refresh — учитывать принудительную переадресацию на себя же (!) по метатегу Refresh.

- Response Timeout — время ожидания ответа страницы, перед тем как парсер перейдет к анализу следующего урла. Можно сделать больше (для медленных сайтов), можно меньше.

- 5хх Response Retries — количество попыток “достучаться” до страниц с 5хх ответом сервера.

- Store HTML — можно сохранить статический HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть его до того, как JavaScript “вступит в игру”.

- Store Rendered HTML — позволяет сохранить отображенный HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть DOM после обработки JavaScript.

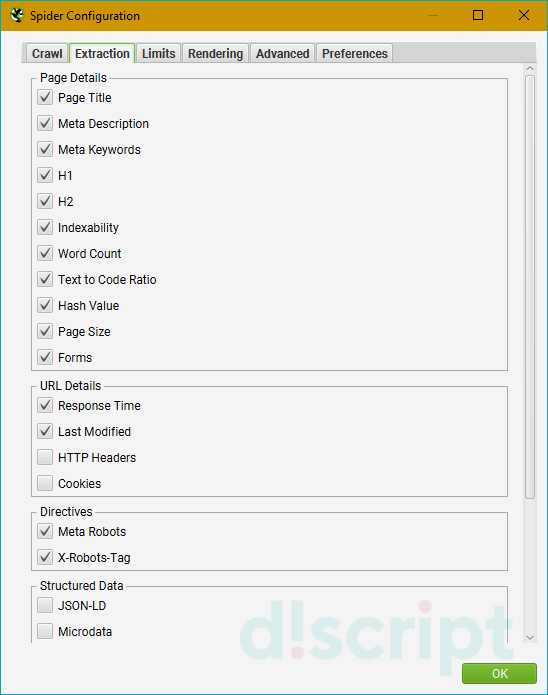

- Extract JSON-LD — извлекаем микроразметку сайта JSON-LD. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract Microdata — извлекаем микроразметку сайта Microdata. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract RDFa — извлекаем микроразметку сайта RDFa. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

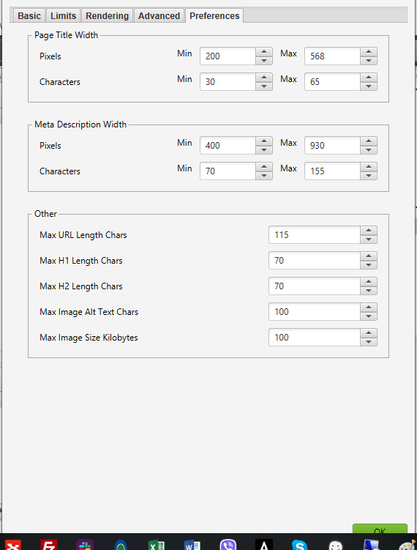

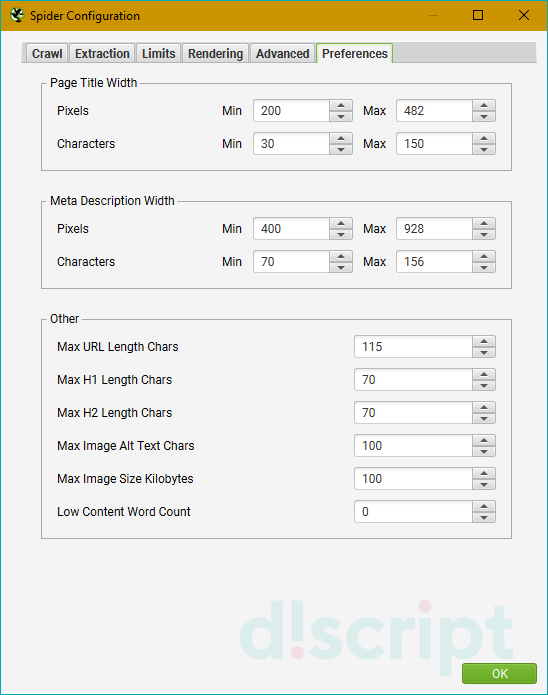

Вкладка Preferences — так называемые “предпочтения”

Здесь задаем желаемые параметры для некоторых сканируемых элементов (title, description, url, H1, H2, alt картинок, размер картинок). Соответственно, если сканируемые элементы сайта не будут соответствовать нашим предпочтениям, программа нам об этом сообщит в научно-популярной форме. Совершенно необязательные настройки — каждый прописывает для себя свой идеал… или вообще их не трогает, от греха подальше (как делаю я).

- Page Title Width — оптимальная ширина заголовка страницы. Указываем желаемые размеры от и до в пикселях и в символах.

- Meta Description Width — оптимальная ширина описания страницы. Аналогично, как и с тайтлом, указываем желаемые размеры.

- Other — сюда входит максимальная желаемая длина урл-адреса в символах (Max URL Length Chars), максимальная длина H1 в символах (Max H1 Length Chars), максимальная длина H2 в символах (Max H2 Length Chars), максимальная длина ALT картинок в символах (Max Image Length Chars) и максимальный вес картинок в КБ (Max Image Size Kilobytes).

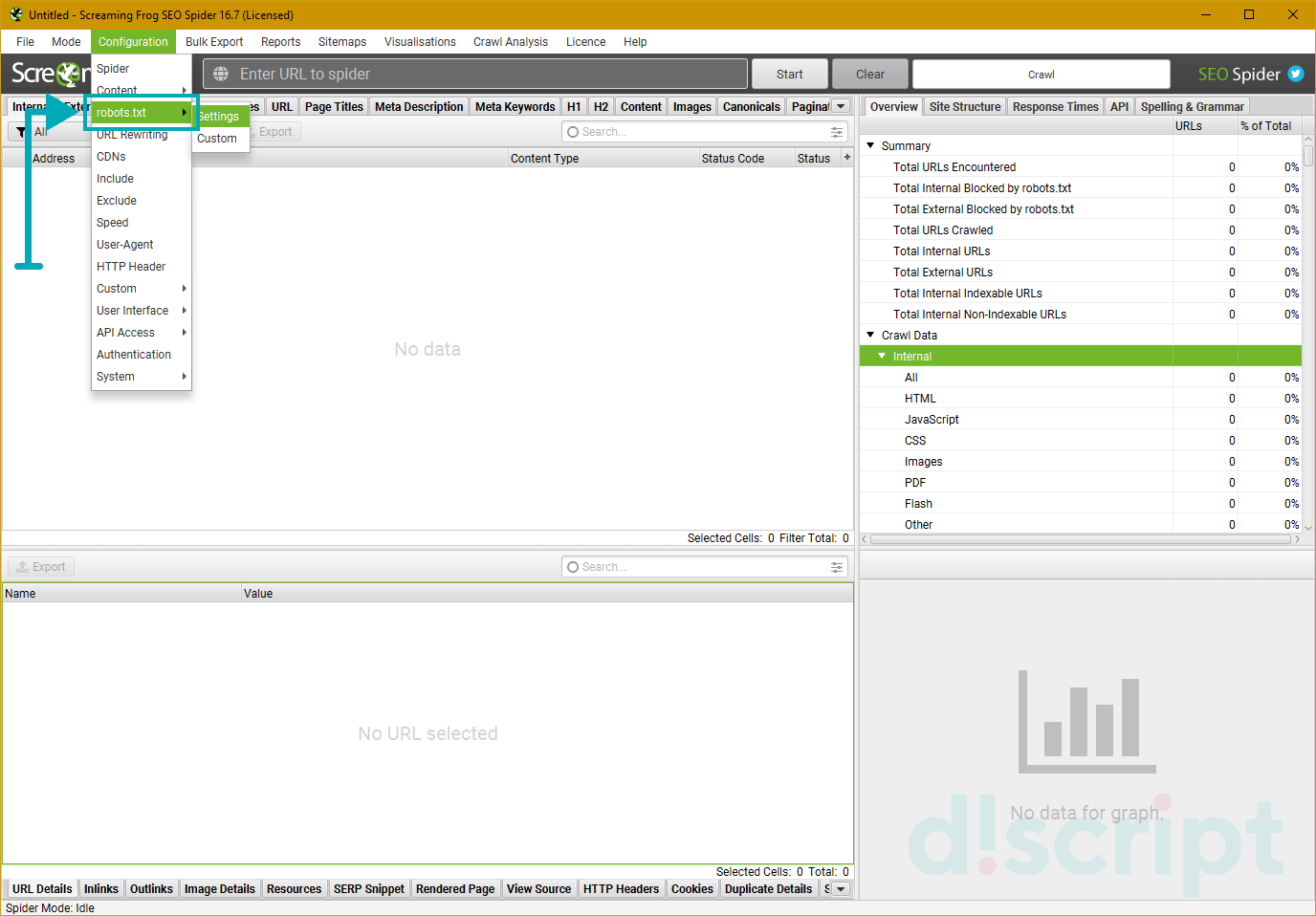

Robots.txt — определяем каким правилам следовать при парсинге

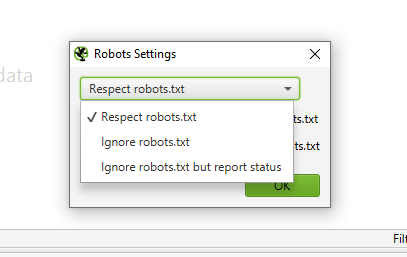

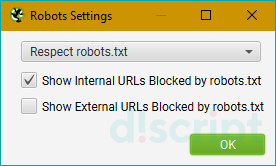

Вкладка Settings — настраиваем парсинг относительно правил robots.txt

- Respect robots.txt — следуем всем правилам, прописанным в robots.txt. Т.е. учитываем в анализе те папки и файлы, которые открыты для робота.

- Ignore robots.txt — не учитываем robots.txt сайта при парсинге. В отчет попадают все папки и файлы, относящиеся к домену.

- Ignore robots.txt but report status — не учитываем robots.txt сайта при парсинге, однако в дополнительном меню выводится статус страницы (индексируемая или не индексируемая).

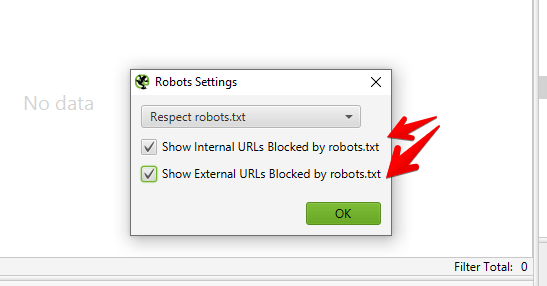

- Show internal/external URLs blocked by robots.txt — отмечаем в чекбоксах хотим ли мы видеть в итоговом отчете внутренние и внешние ссылки, закрытые от индексации в robots.txt. Данная опция работает только при условии выбора “Respect robots.txt”.

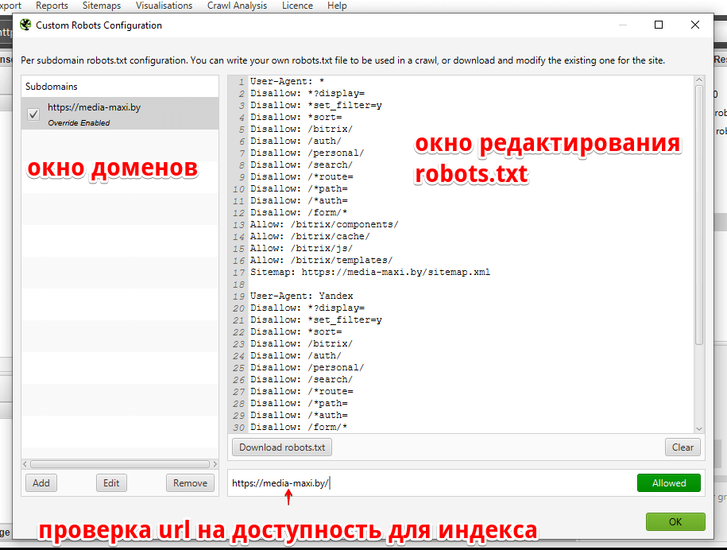

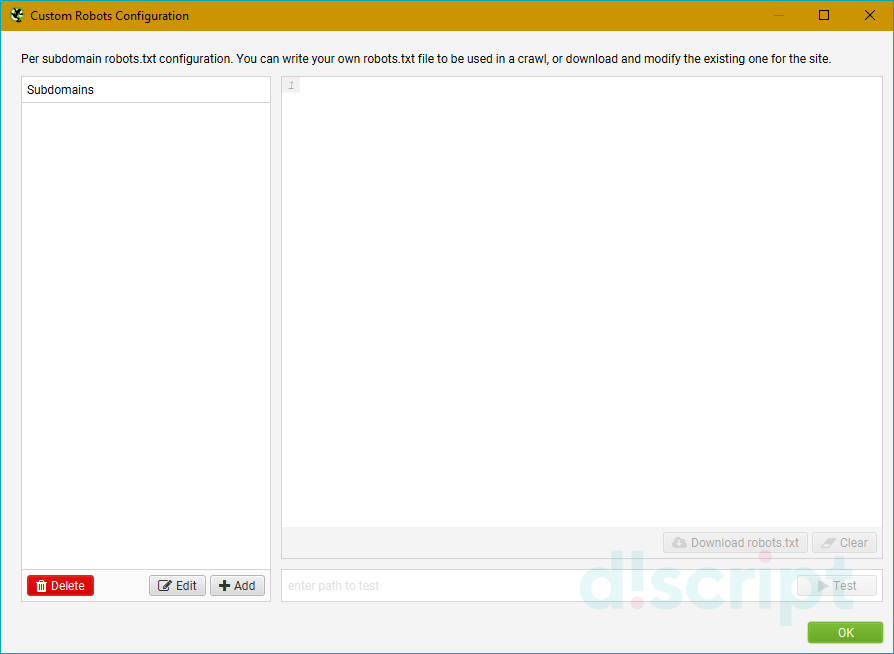

Вкладка Custom — ручное редактирование robots.txt в пределах текущего парсинга

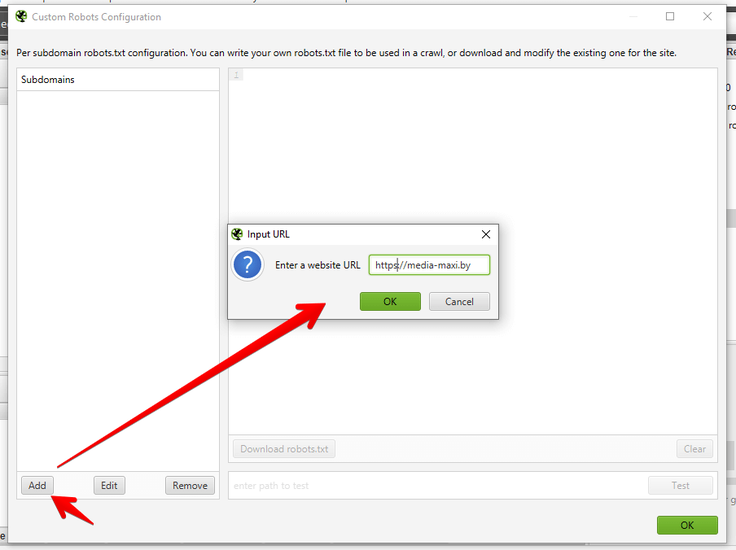

Удобно, если вам нужно при парсинге сайта учитывать (или исключить) только определенные папки, либо же добавить правила для поддоменов. Кроме того, можно быстро сформировать и проверить свой рабочий robots, чтобы потом залить его на сайт.

Шаг 1. Прописать анализируемый домен в основной строке

Шаг 2. Кликнуть на Add, чтобы добавить robots.txt домена

Тут на самом деле все очень просто, поэтому я по верхам пробегусь по основным опциям (а в конце будет видео, где я бездумно прокликиваю все кнопки).

- Блок Subdomains — сюда, собственно, можно добавлять домены/поддомены, robots.txt которых мы хотим учитывать при парсинге сайта.

- Окно справа — для редактирования выгруженного robots.txt. Итоговый вариант будет считаться каноничным для парсера.

- Окошко снизу — проверка индексации url в зависимости от настроенного robots.txt. Справа выводится статус страницы (Allowed или Disallowed).

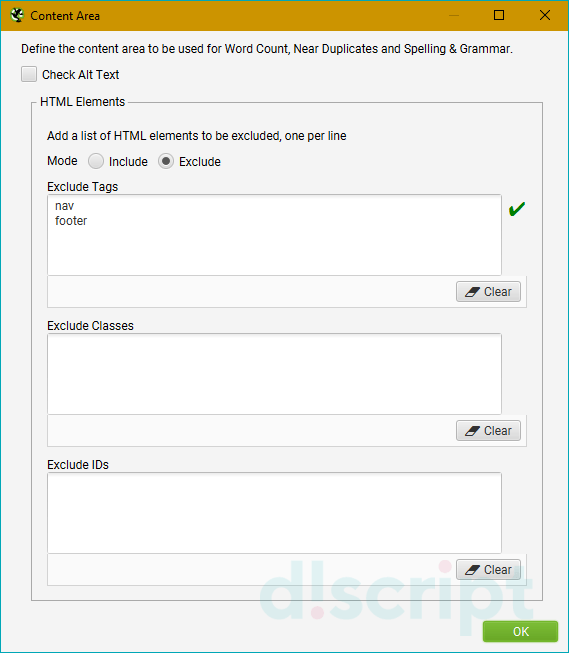

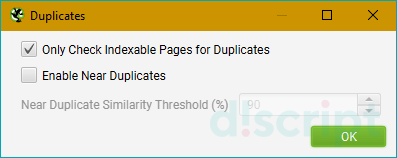

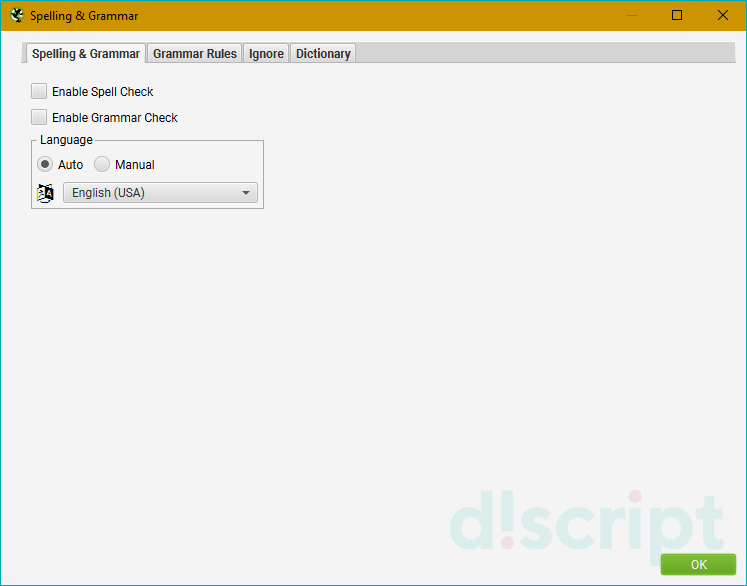

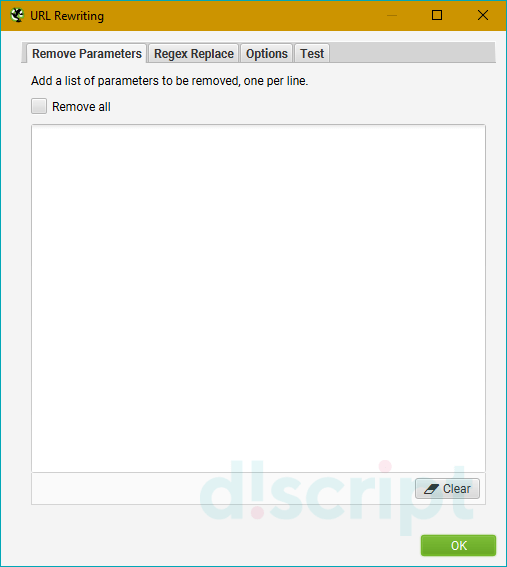

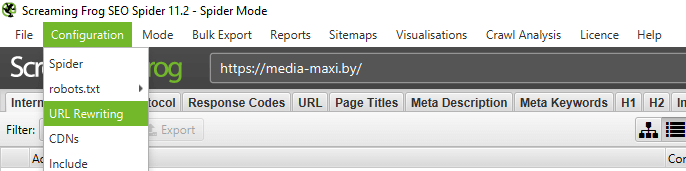

URL Rewriting — функция перезаписи URL «на лету»

Тут мы можем настроить перезапись урл-адресов домена прямо в ходе парсинга. Полезно, когда нужно заменить определенные регулярные выражения, которые засоряют итоговый отчет по парсингу.

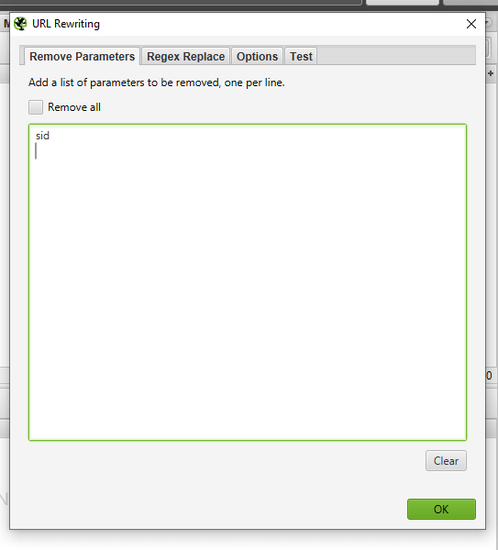

Вкладка Remove Parameters

Вручную вводим параметры, которые нужно удалять из url при анализе сайта, либо исключить вообще все возможные параметры (чекбокс “Remove all”). Полезно, если у страниц сайта есть идентификаторы сеансов, отслеживание контекста (utm_source, utm_medium, utm_campaign) или другие фишки.

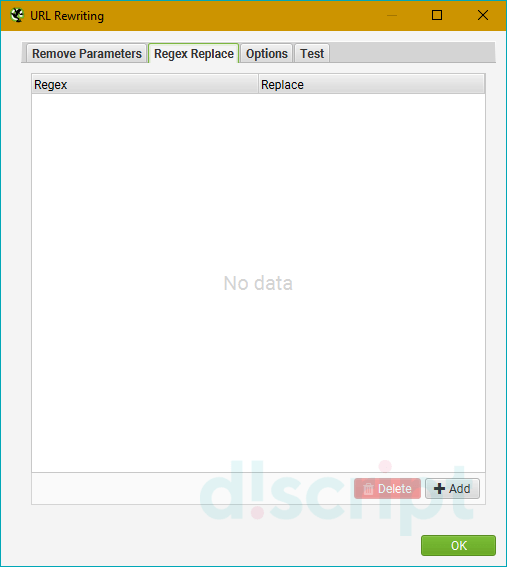

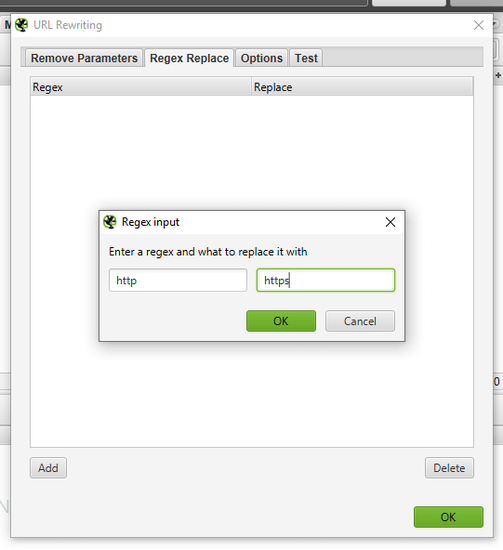

Вкладка Regex Replace

Изменяет все сканируемые урлы с использованием регулярных выражений. Применений данной настройки масса, я приведу только несколько самых распространенных примеров:

- Изменение всех ссылок с http на https (Регулярное выражение: http Заменить: https).

- Изменение всех ссылок на site.by на site.ru (Регулярное выражение: .by Заменить: .ru).

- Удаление всех параметров (Регулярное выражение: \?. * Заменить: ).

- Добавление параметров в URL (Регулярное выражение: $ Заменить: ?ПАРАМЕТР).

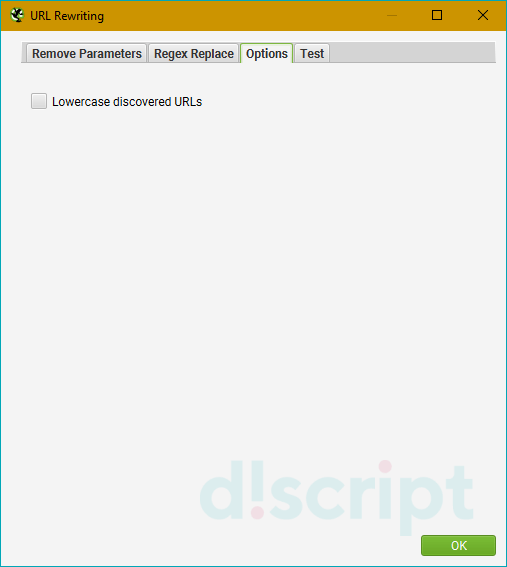

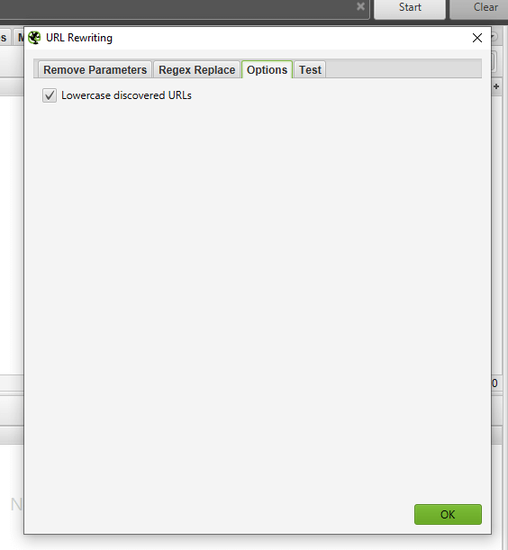

Вкладка Options

Вы рассчитывали увидеть здесь еще 100500 дополнительных опций для суперточной настройки URL Rewriting, я прав? Как бы странно это ни звучало, но здесь мы всего лишь определяем перезаписывать все прописные url-адреса в строчные или нет… вот как-то так, не спрашивайте, я сам не знаю почему для этой опции сделали целую отдельную вкладку.

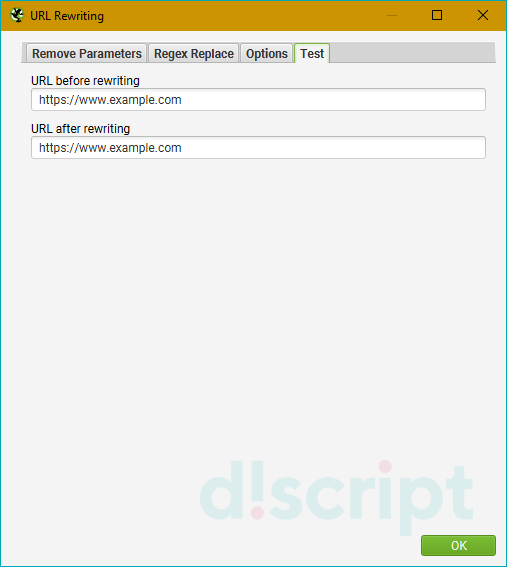

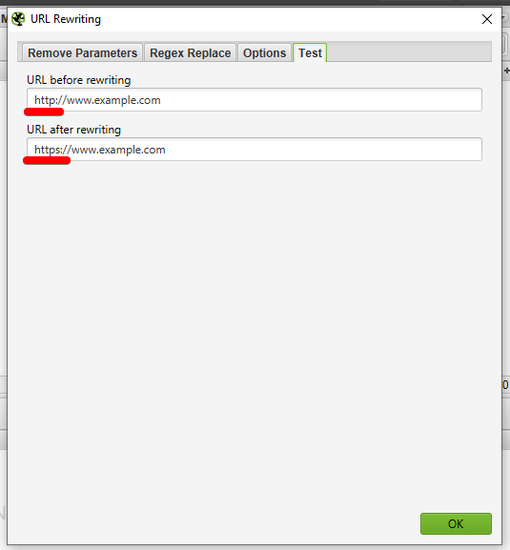

Вкладка Test

Тут мы можем предварительно протестировать видоизменение url перед началом парсинга и, соответственно, подправить регулярные выражения, чтобы на выходе не получилось какой-нибудь ерунды.

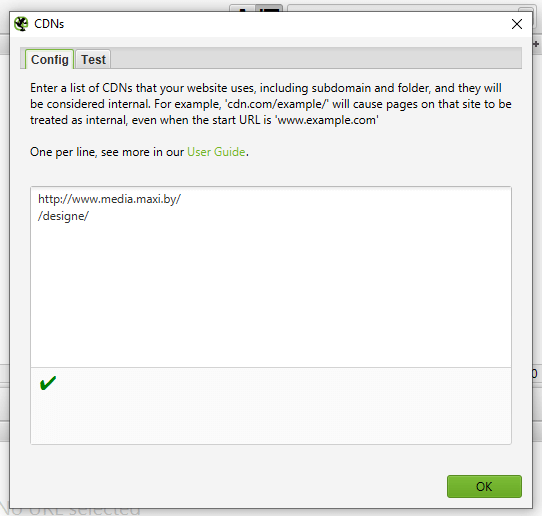

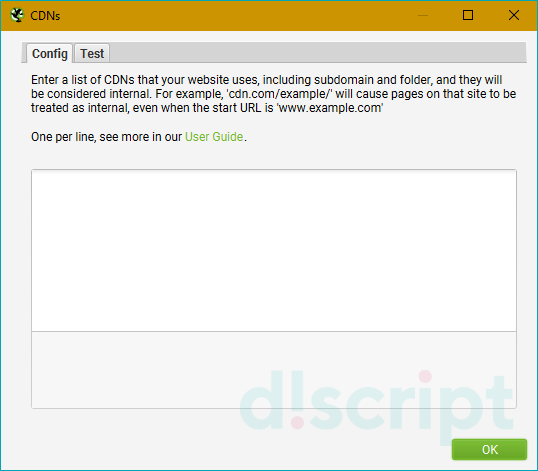

CDNs — парсим поддомены, не отходя от кассы

Использование настройки CDNs позволяет включать в парсинг дополнительные домены/поддомены/папки, которые будут обходиться пауком и при этом считаться внутренними ссылками. Полезно, если нужно проанализировать массив сайтов, принадлежащих одному владельцу (например, крупный интернет-магазин с сетью сайтов под регионы). Также можно прописывать регулярные выражения на конкретные пути сканирования — т.е. парсить только определенные папки.

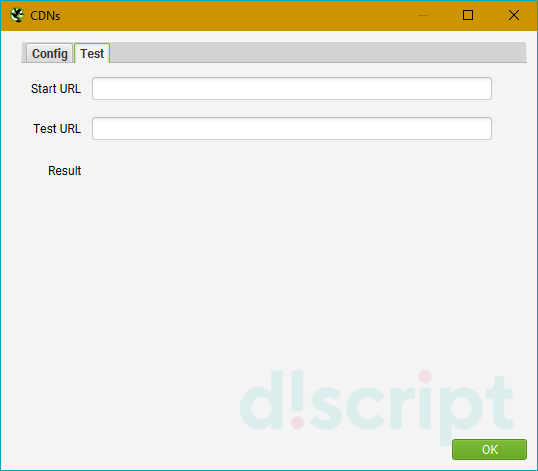

Во вкладке Test можно посмотреть как будут определяться урлы в зависимости от используемых параметров (Internal или External).

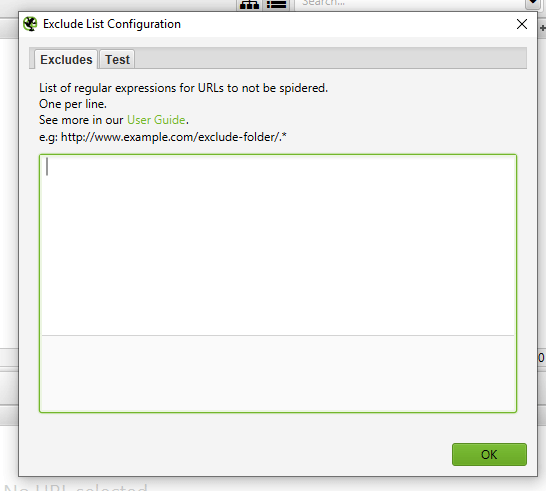

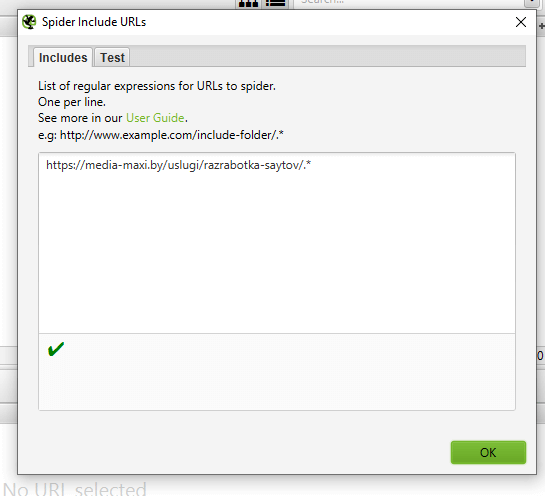

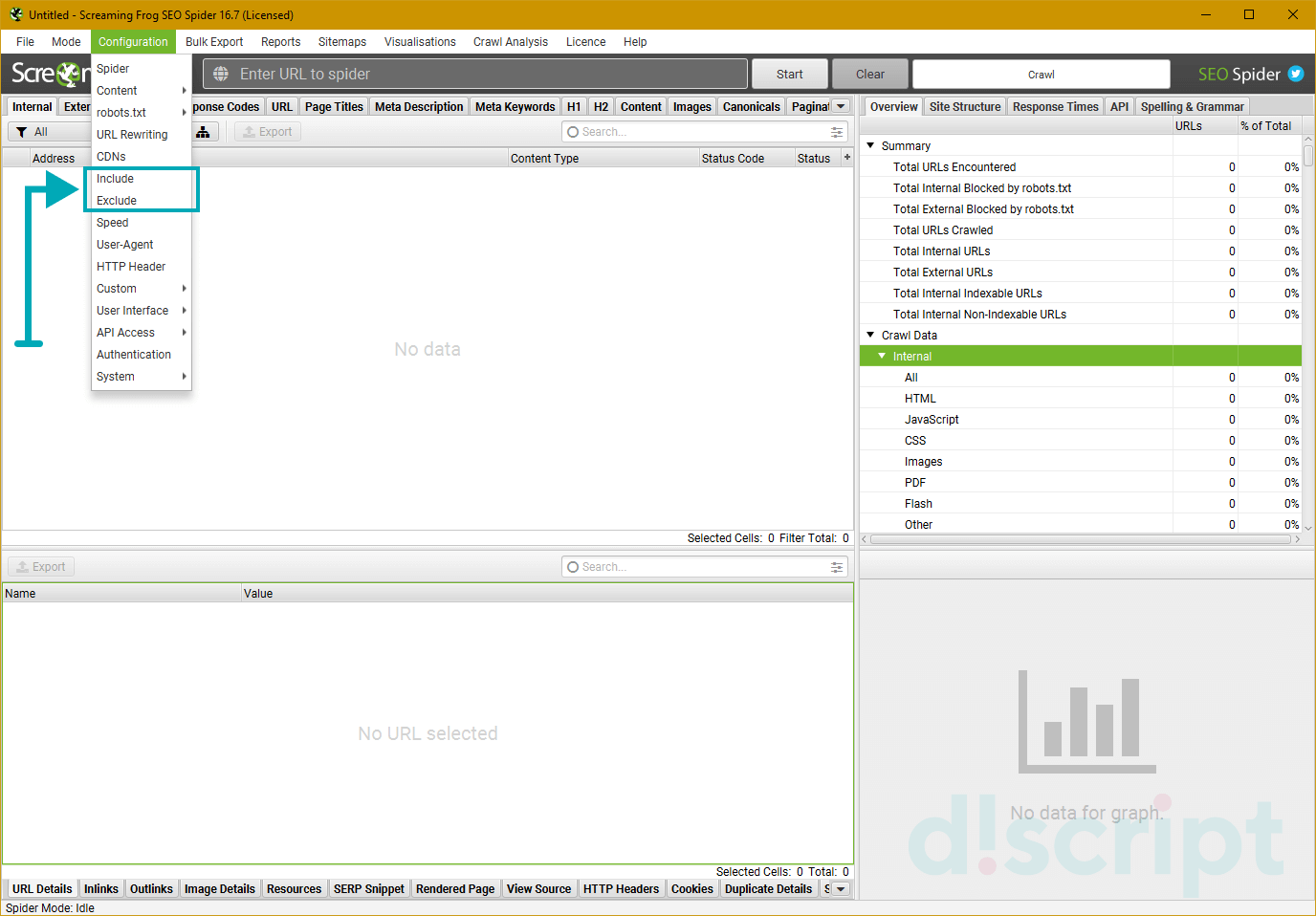

Include/Exclude — сканирование/удаление определенных папок

Можно регулярными выражениями задать пути, которые будут сканироваться внутри домена. Также можно запретить парсинг определенных папок. Единственный нюанс в настройках — при использовании Include будут парситься только УКАЗАННЫЕ папки, если же мы добавляем урлы в Exclude, сканироваться будут все папки, КРОМЕ УКАЗАННЫХ.

Выбираем папки для парсинга

Удаляем папки из парсинга

Примеры регулярных выражений для Exclude:

- http://site.by/obidnye-shutki-pro-seo.html (исключение конкретной страницы).

- http://site.by/obidnye-shutki-pro-seo/.* (исключение целой папки).

- http://site.by/.*/obidnye-shutki-pro-seo/.* (исключение всех страниц, после указанной).

- .*\?price.* (исключение страниц с определенным параметром).

- .*jpg$ (исключение файлов с определенным расширением).

- .*seo.* (исключение страниц с вхождением в url указанного слова).

- .*https.* (исключение страниц с https).

- http://site.by/.* (исключение всех страниц домена/поддомена).

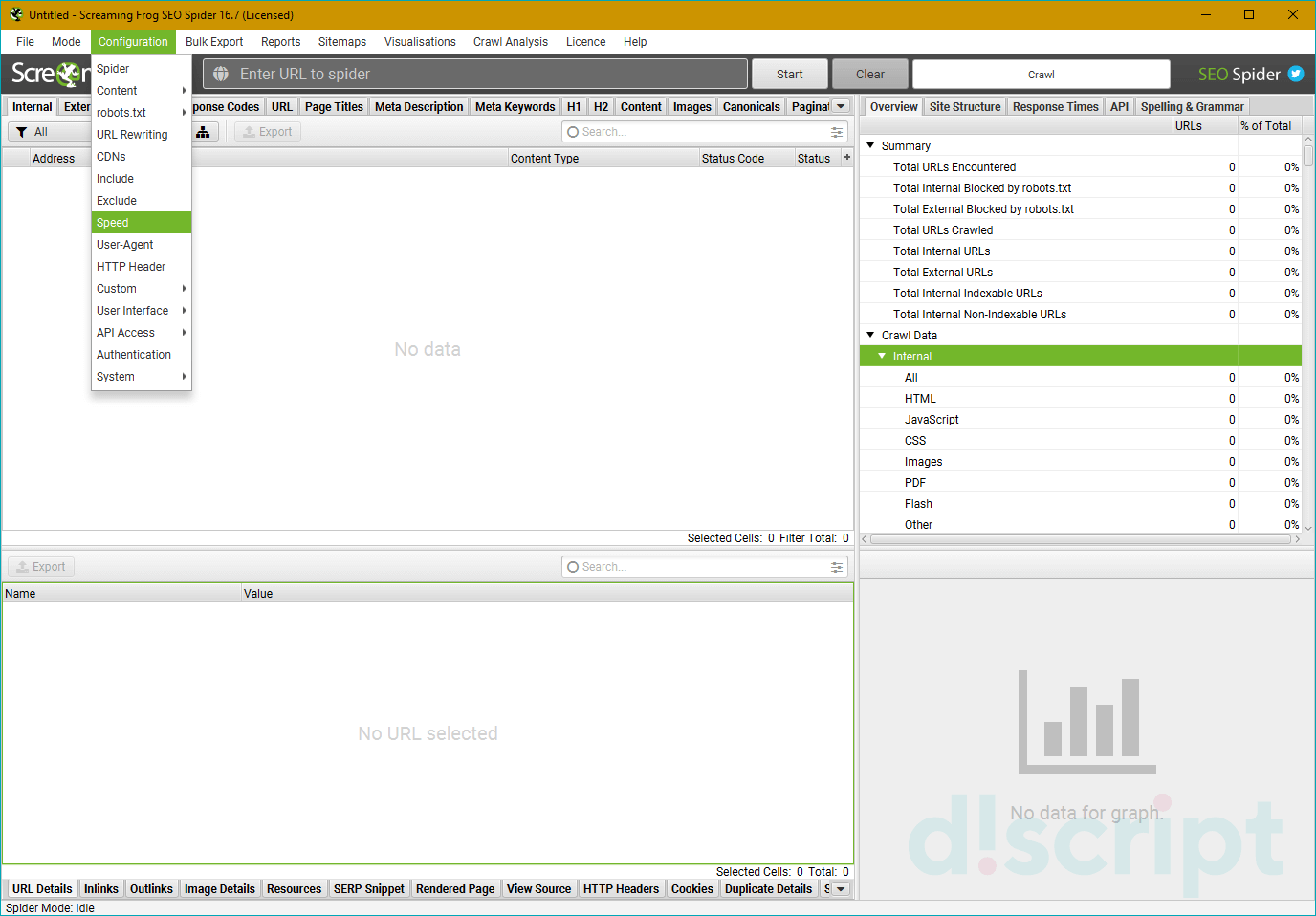

Speed — регулируем скорость парсинга сайта

Можно выставить как количество потоков (по умолчанию 5), так и число одновременно сканируемых адресов. Влияет на скорость парсинга и вероятность бана бота, так что тут лучше не усердствовать.

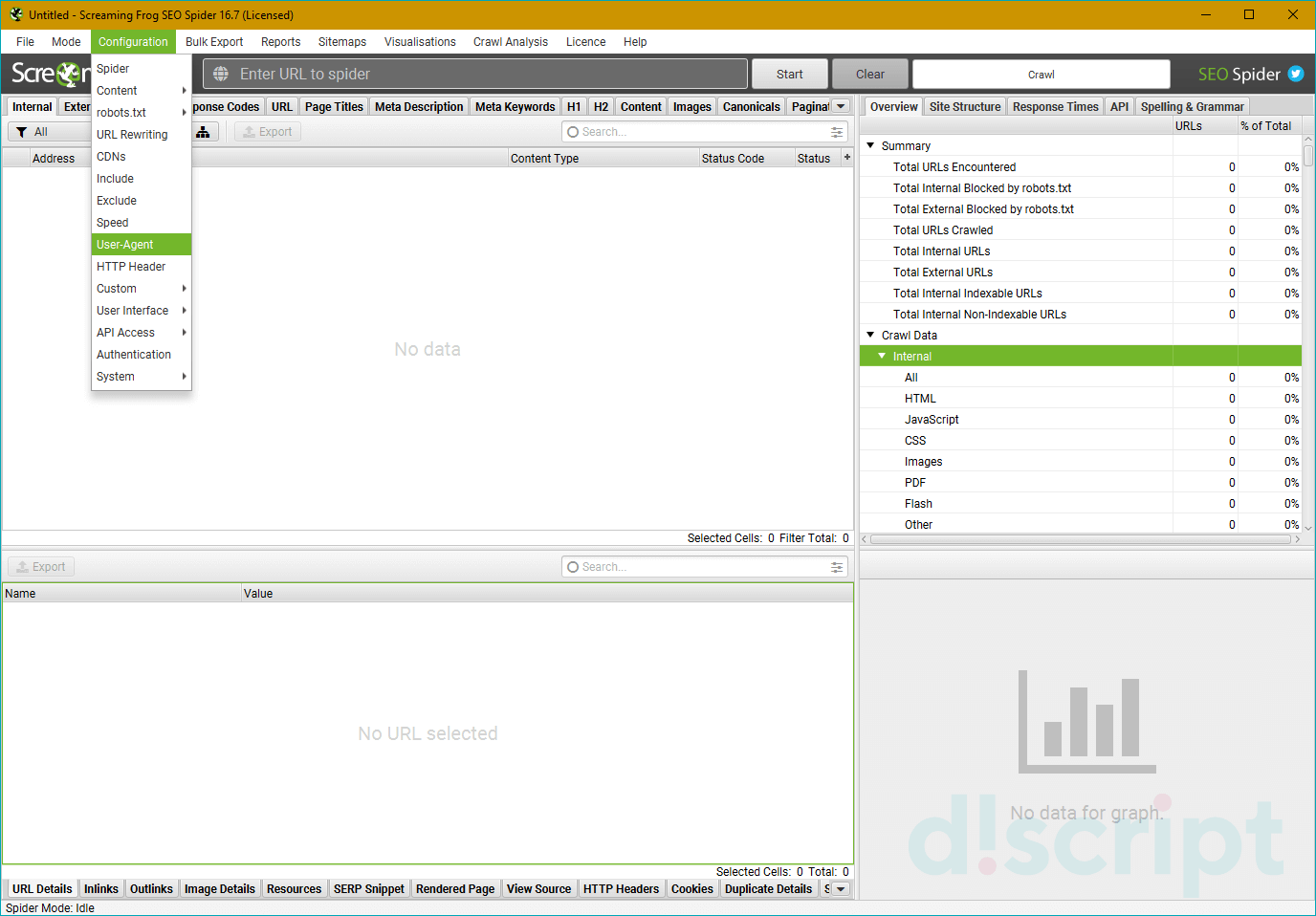

User-Agent — выбираем под кого маскируемся

В списке user-agent можно выбрать от лица какого бота будет происходить парсинг сайта. Удобно, если в настройках сайта есть директивы, блокирующие того или иного бота (например, запрещен google-bot). Также полезно иногда прокраулить сайт гугл-ботом для смартфона, чтобы проверить косяки адаптива или мобильной версии.

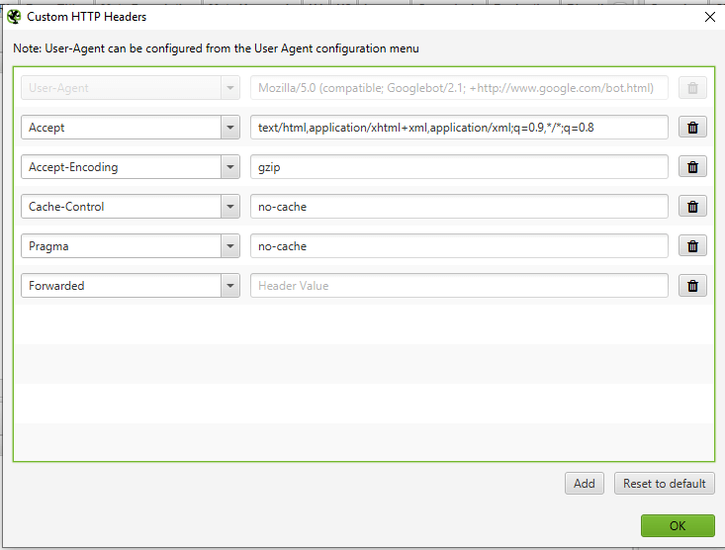

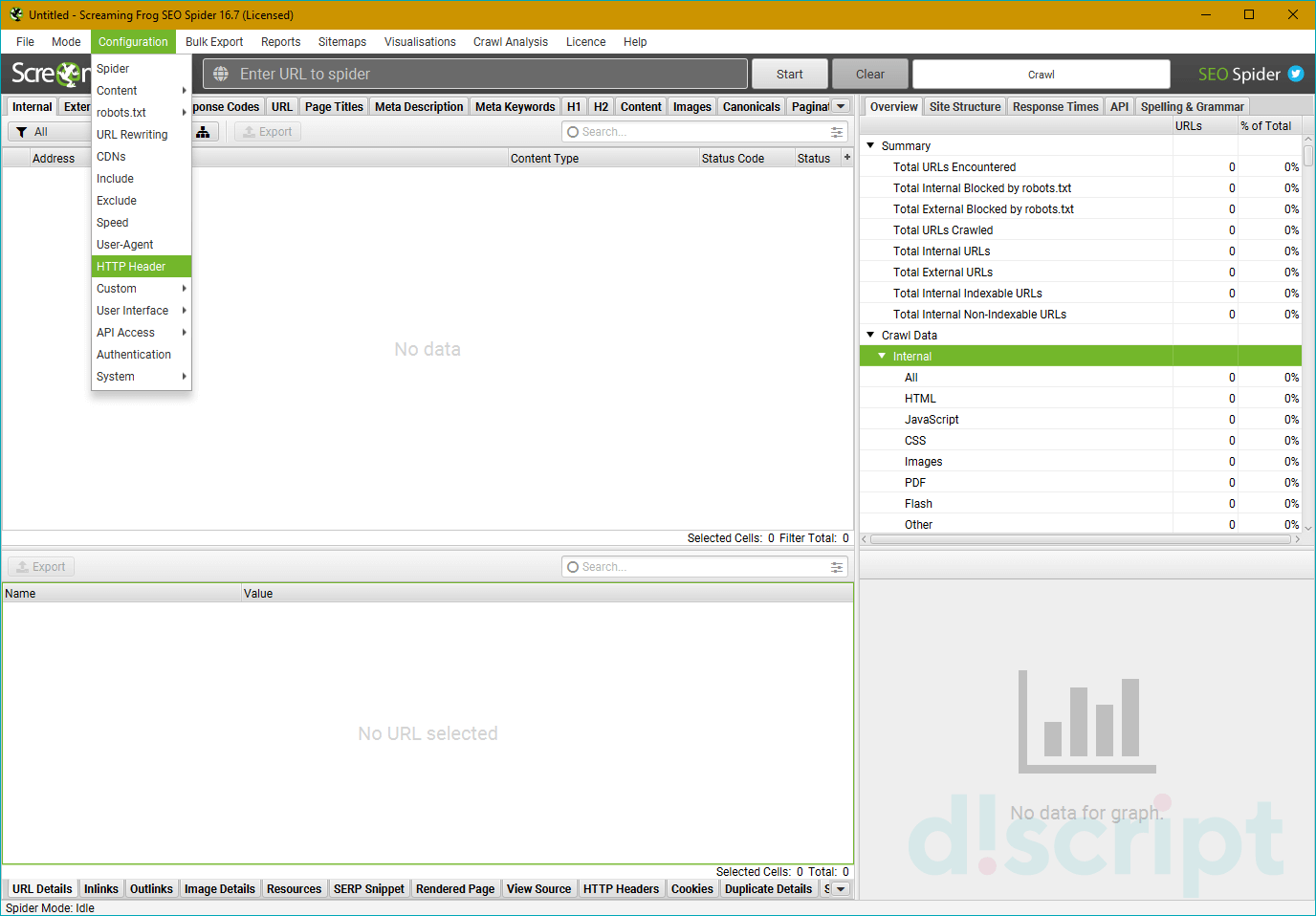

Скажу сразу — это опция очень индивидуальна, лично я ее не пользую, потому что чаще всего незачем. В любом случае, настройка реагирования на http-заголовки позволяет определить, как паук будет их обрабатывать (если указаны нюансы в настройках). По крайней мере я так это понял.

Т.е. можно индивидуально настроить, например, какого формата контент обрабатывать, учитывать ли cookie и т.д. Нюансов там довольно много.

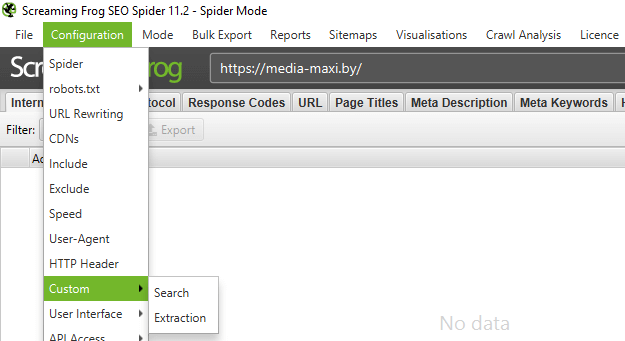

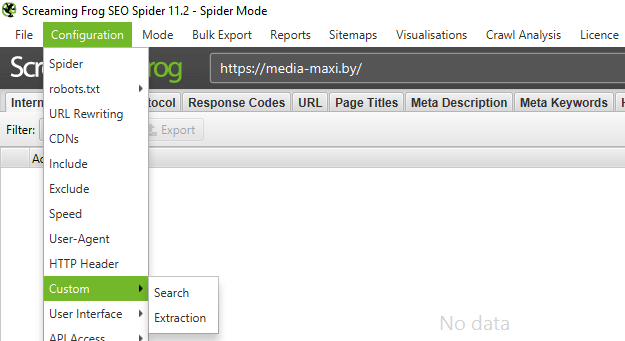

Custom — дополнительные настройки поиска по исходному коду

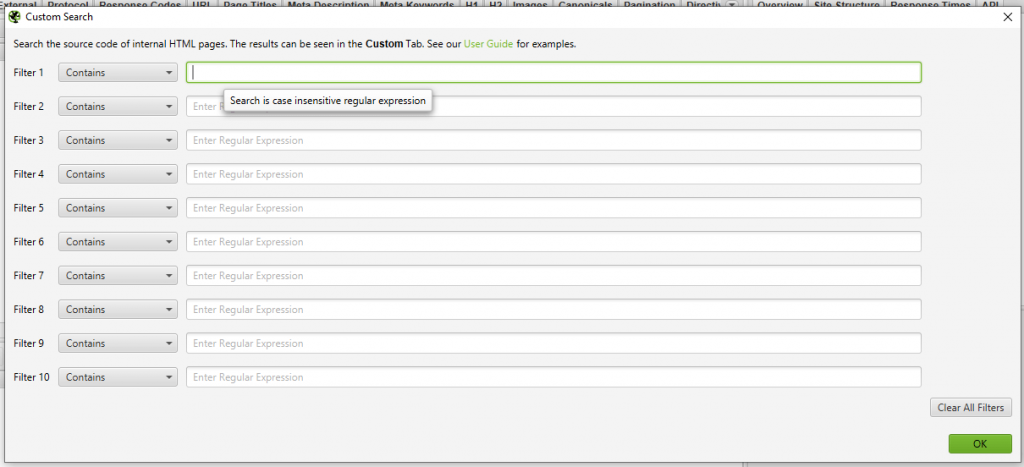

Custom Search

По сути обычный фильтр, с помощью которого можно вытягивать дополнительные данные, например, страницы, в которых вместо тега <strong> используется <bold> или еще лучше — страницы, которые НЕ содержат определенного контента (например, без кода счетчика метрики). Фактически в настройках можно задать все что угодно.

Custom Extraction

Это пользовательское извлечение любых данных из html (например, текстовое содержимое).

User Interface — обнуление настроек для колонок таблицы

Просто сбрасывает сортировку столбцов, ничего особенного, проходим дальше, граждане, не толпимся.

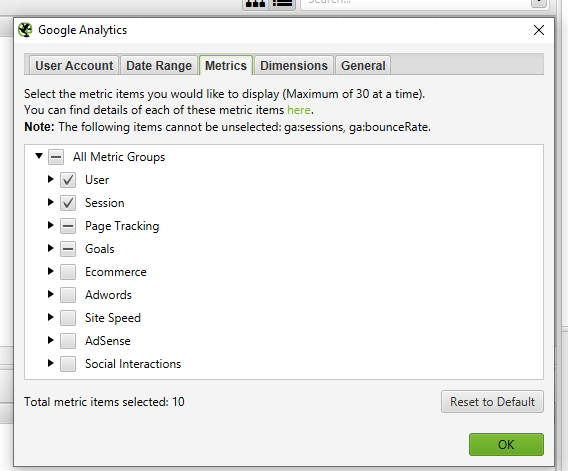

API Access — интеграция с разными сервисами

Для того чтобы получать больше данных по сайту, можно настроить интеграцию с разными сервисами статистики типа Google Analytics или Majestic, при условии того, что у вас есть аккаунт в этом сервисе.

При этом для каждого сервиса отдельные настройки выгрузки по типам данных.

На примере GA

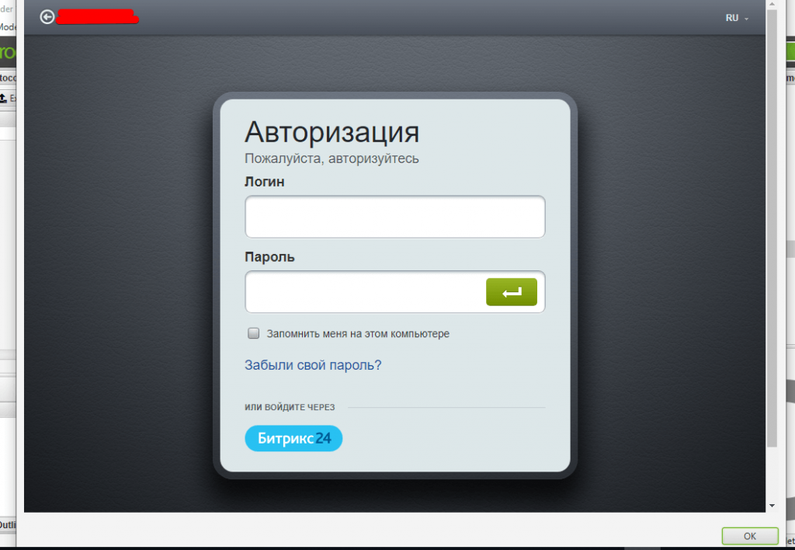

Authentification — настройки аутентификации (если есть запрос от сайта)

Есть два вида аутентификации — Standart Based и Form Based. По умолчанию используется Standart Base — если при парсинге от сайта приходит запрос на аутентификацию, в программе появляется соответствующее окно.

Form Based — использование для аутентификации встроенного в SF браузера (полезно, когда для подтверждения аутентификации нужно, например, пройти капчу). В данном случае необходимо вручную вводить урл сайта и в открывшемся окне браузера вводить логин/пароль, кликать recaptcha и т.д.

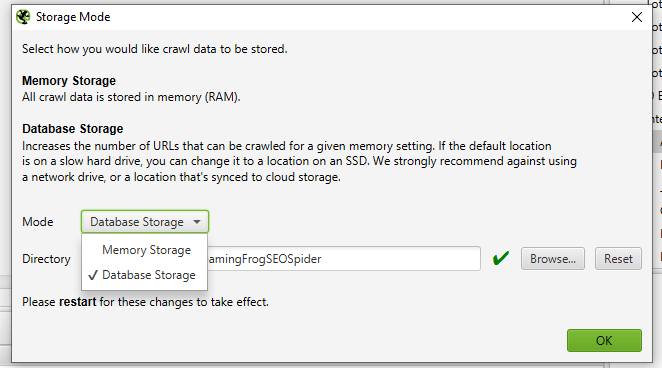

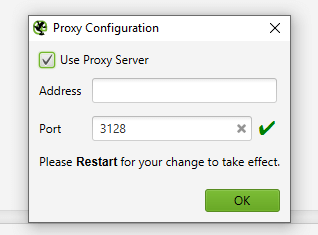

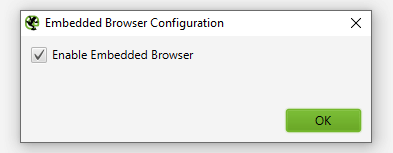

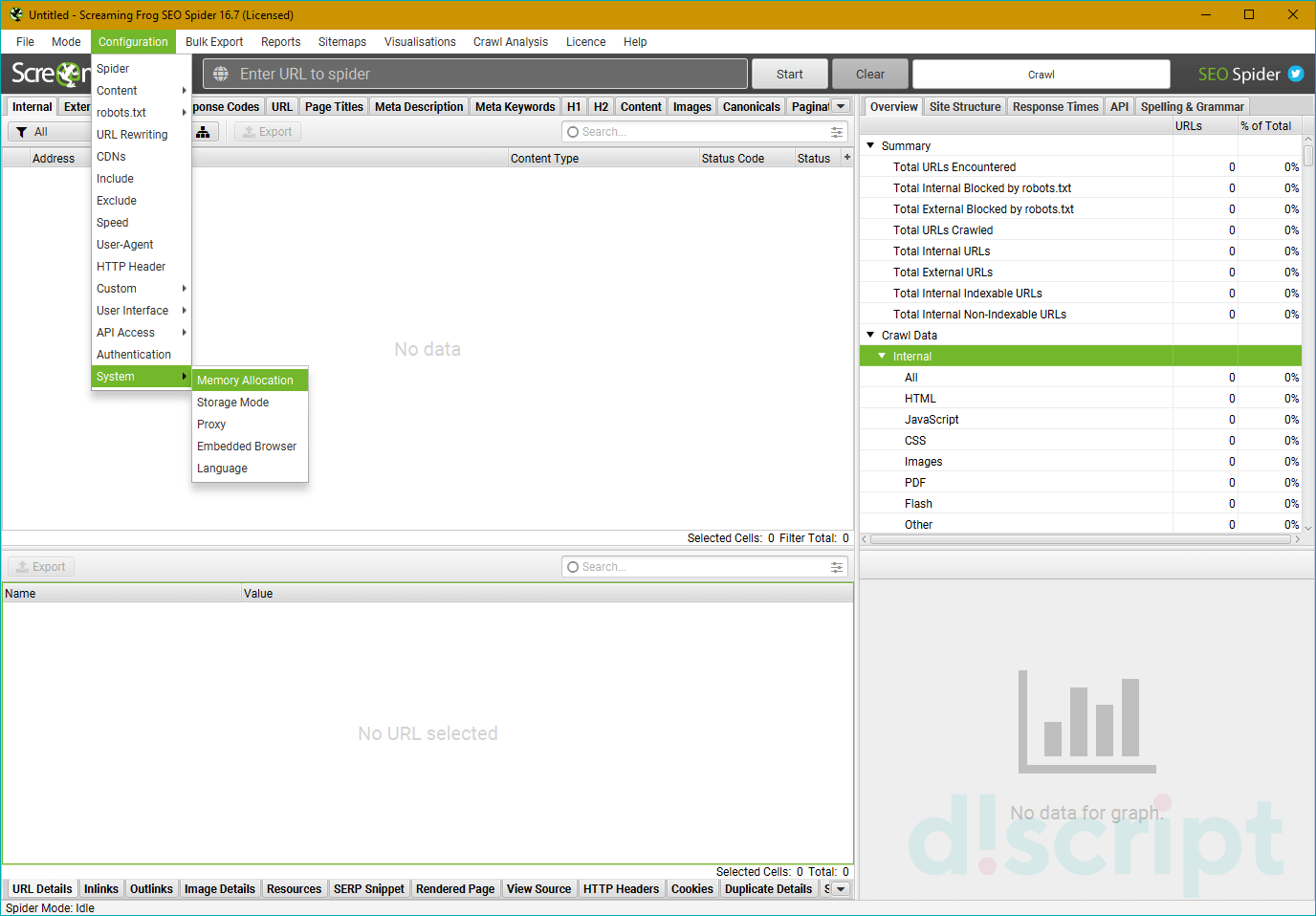

System — внутренние настройки самой программы

Настройки работы самой программы — сколько оперативной памяти выделять на процесс, куда сохранять экспорт и т.д.

Давайте как обычно — подробнее о каждом пункте.

- Memory — выделяем лимиты оперативной памяти для парсинга. По дефолту стоит 2GB, но можно выделить больше (если ПК позволяет).

- Storage — выбор базы для хранения данных. Либо сохранение в ОЗУ (для этого у SF есть свой движок), либо в указанной папке на ПК пользователя.

- Proxy — подключение прокси-сервера для парсинга.

- Embedded Browser — использование встроенного в программу браузера (вкл/выкл).

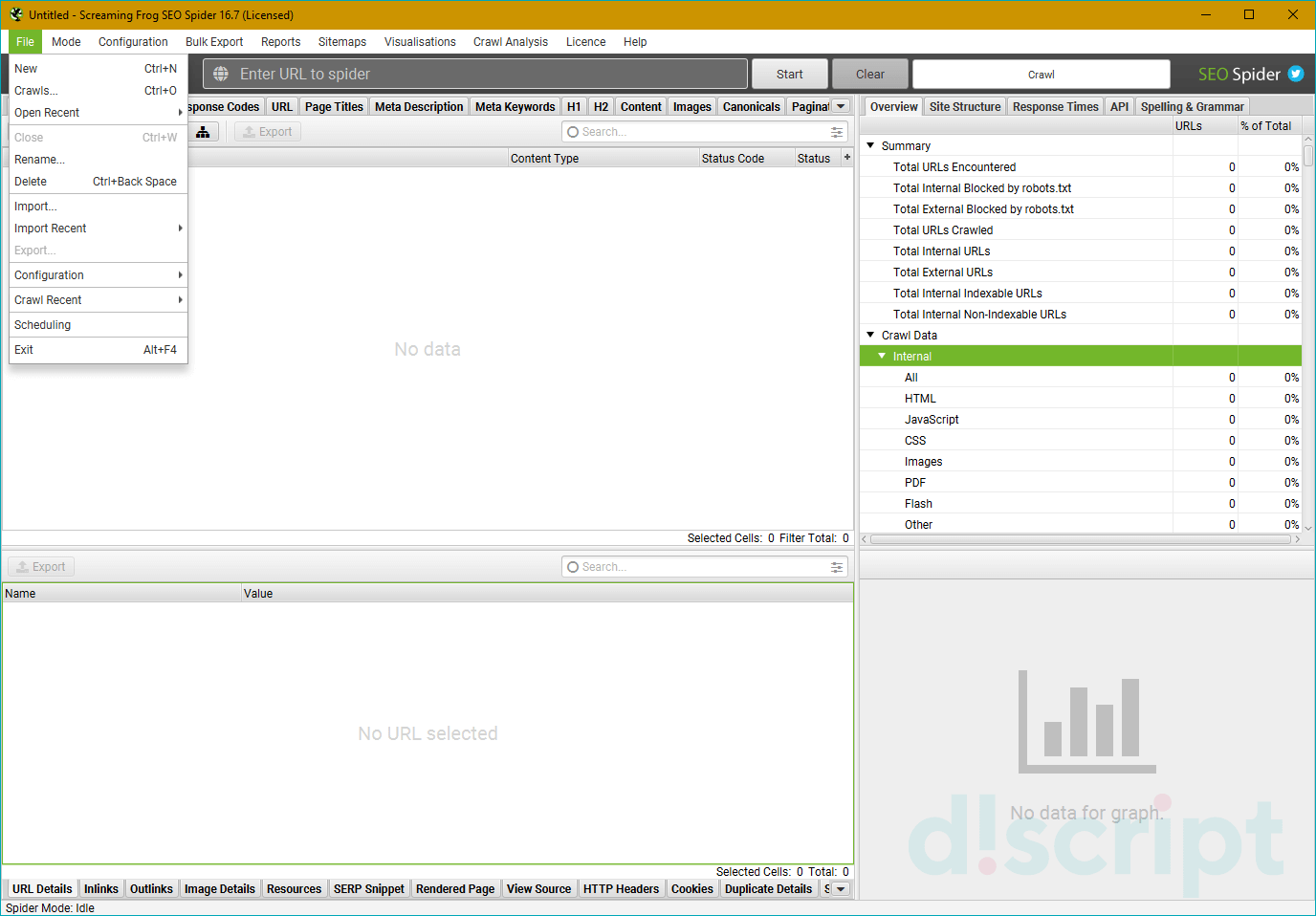

Mode

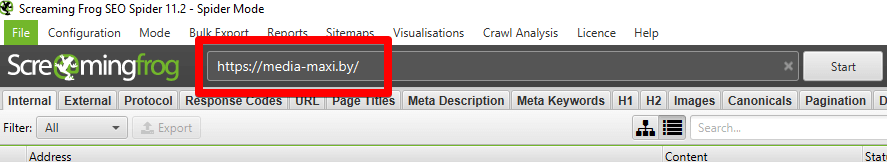

- Spider (Режим паука) — классический парсинг сайта по внутренним ссылкам. Просто вводим нужный домен в адресную строку программы и запускаем работу.

- List — парсим только предварительно собранный список урл-адресов! Адреса можно выгрузить из файла (From a file), вбить вручную (Enter Manually), подтянуть их из карты сайта (Download Sitemap) и т.д. Если честно, этих трех способов получения списка урлов должно быть более чем достаточно.

- SERP Mode — в этом режиме нет сканирования, зато здесь можно загружать мета-данные сайта, редактировать их и предварительно понимать как они будут отображаться в браузере. Делать все это можно пакетно, что вполне себе удобно.

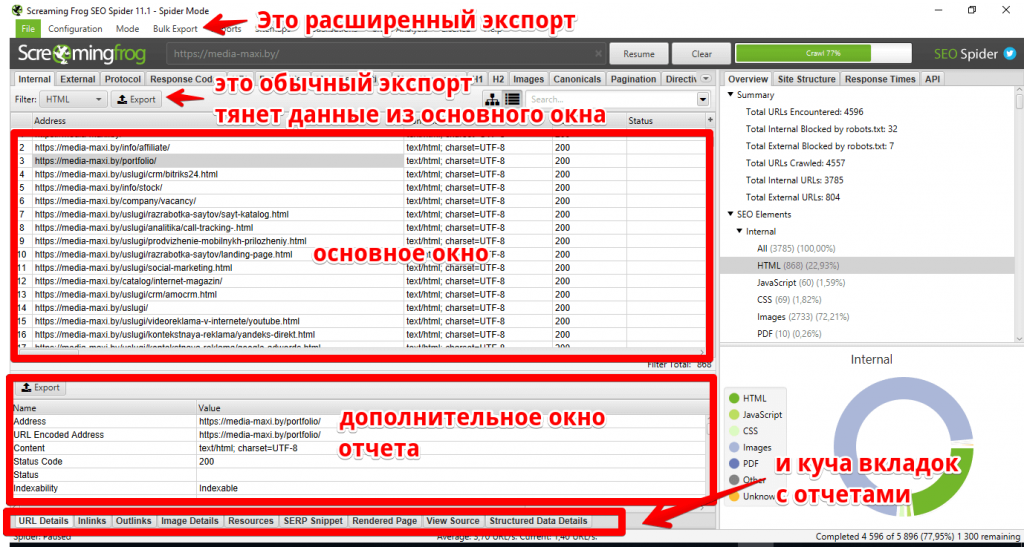

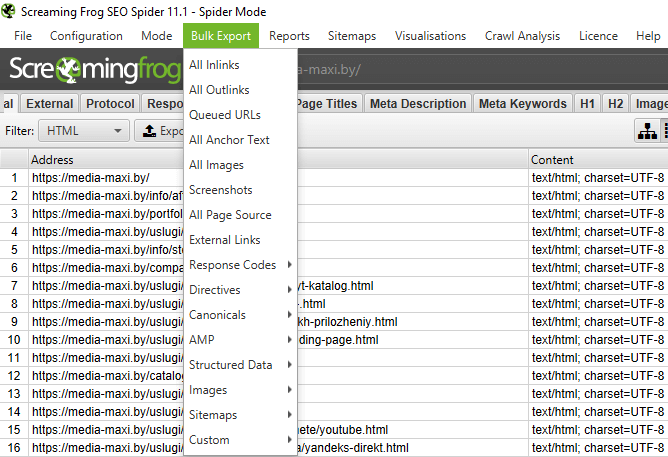

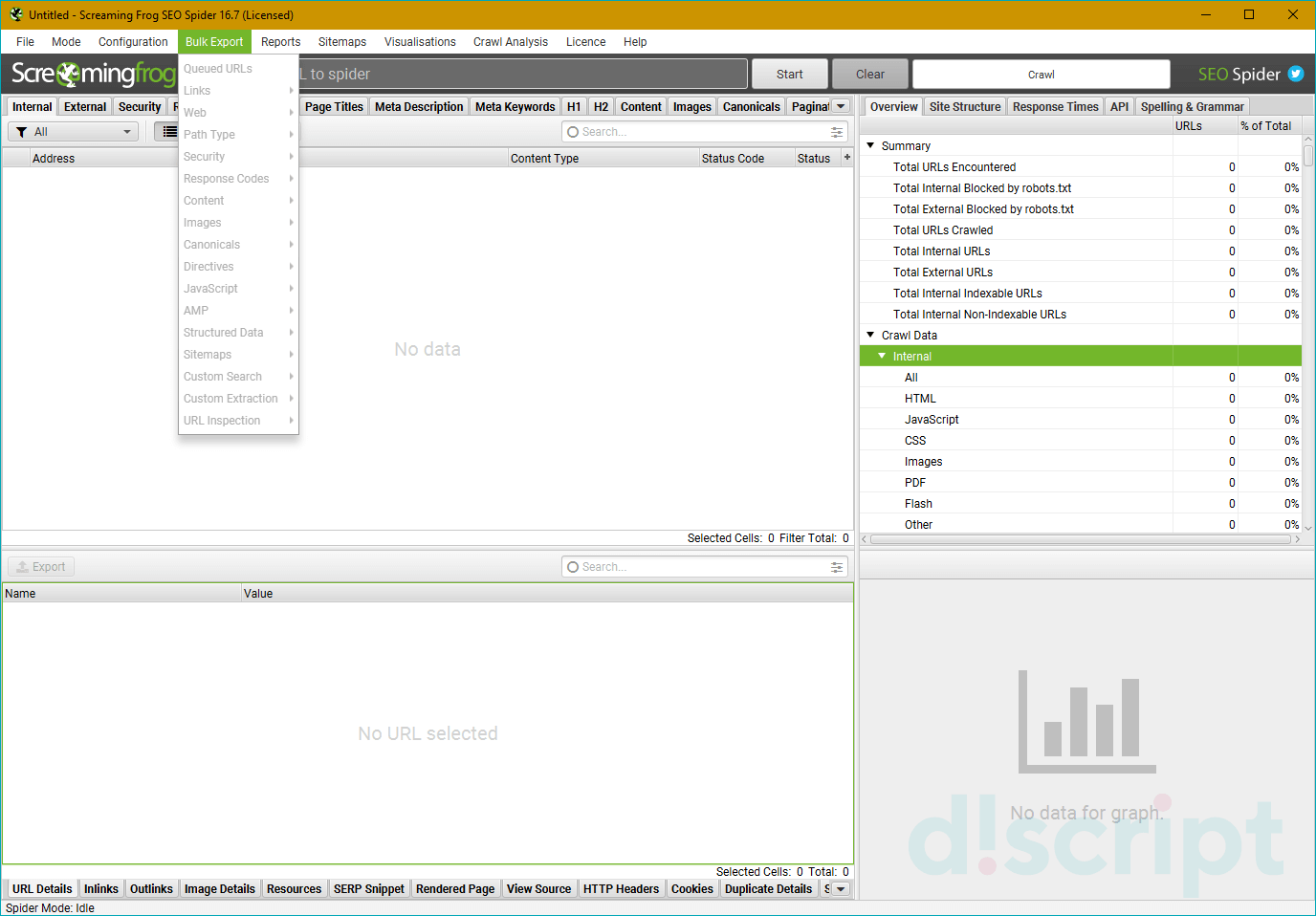

Bulk export

В этом пункте меню висят все опции SF, отвечающие за массовый экспорт данных из основного и дополнительного меню отчета…сейчас покажу на скриншоте.

В общем и целом с помощью bulk export можно вытянуть много разной полезной информации для последующей постановки ТЗ на доработки. Например, выгрузить в excel страницы, на которых найдены ссылки с 3хх ответом сервера + сами 3хх-ссылки, что позволяет сформировать задание для программиста или контент-менеджера (зависит от того, где зашиты 3хх-ссылки) на замену этих 3хх-ссылок на прямые с кодом 200. Теперь подробнее про то, что можно экспортировать при помощи Bulk Export.

- All Inlinks — получаем все входящие ссылки на каждый URI, с которым столкнулся краулер при сканировании сайта.

- All Outlinks — получаем все исходящие ссылки с каждого URI, с которым столкнулся краулер при сканировании сайта.

- All Anchor Text — выгрузка анкоров всех ссылок.

- All Images — выгрузка всех картинок (урл-адресами, естественно).

- Screenshots — экспорт снимков экрана.

- All Page Source — получаем статический HTML-код или обработанный HTML-код просканированных страниц (рендеринг HTML доступен только в режиме рендеринга JavaScript) .

- External Links — все внешние ссылки со всех просканированных страниц.

- Response Codes — все страницы в зависимости от выбранного кода ответа сервера (закрытые от индекса, с кодом 200, с кодом 3хх и т.д.).

- Directives — все страницы с директивами в зависимости от выбранной (Index Inlinks, Noindex Inlinks, Nofollow Inlinks и т.д.).

- Canonicals — страницы, содержащие канонические атрибуты, страницы без указания этих атрибутов, каноникализированные (*перекрестился*) страницы и т.д.

- AMP — страницы с AMP, ссылки с AMP (но код ответа не 200) и т.д.

- Structured Data — выгрузка страниц с микроразметкой.

- Images — выгрузка картинок без альт-текста, тяжелых картинок (в соответствии с указанным в настройках размером).

- Sitemaps — выгрузка всех страниц в карте сайта, неиндексируемых страниц в карте сайта и проч.

- Custom — выгрузка пользовательских фильтров.

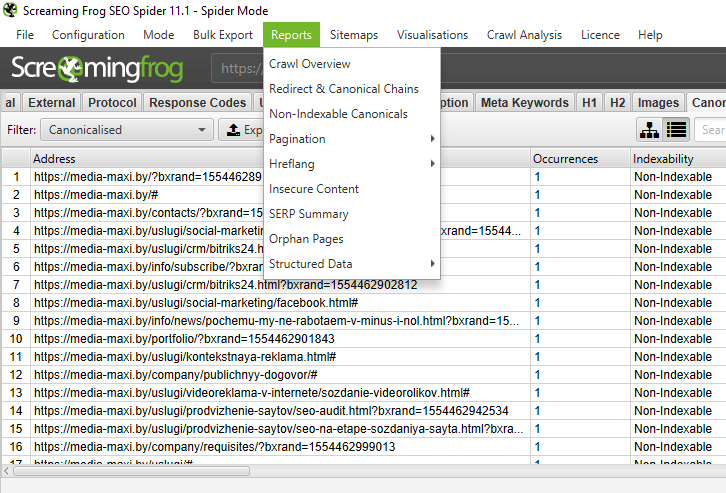

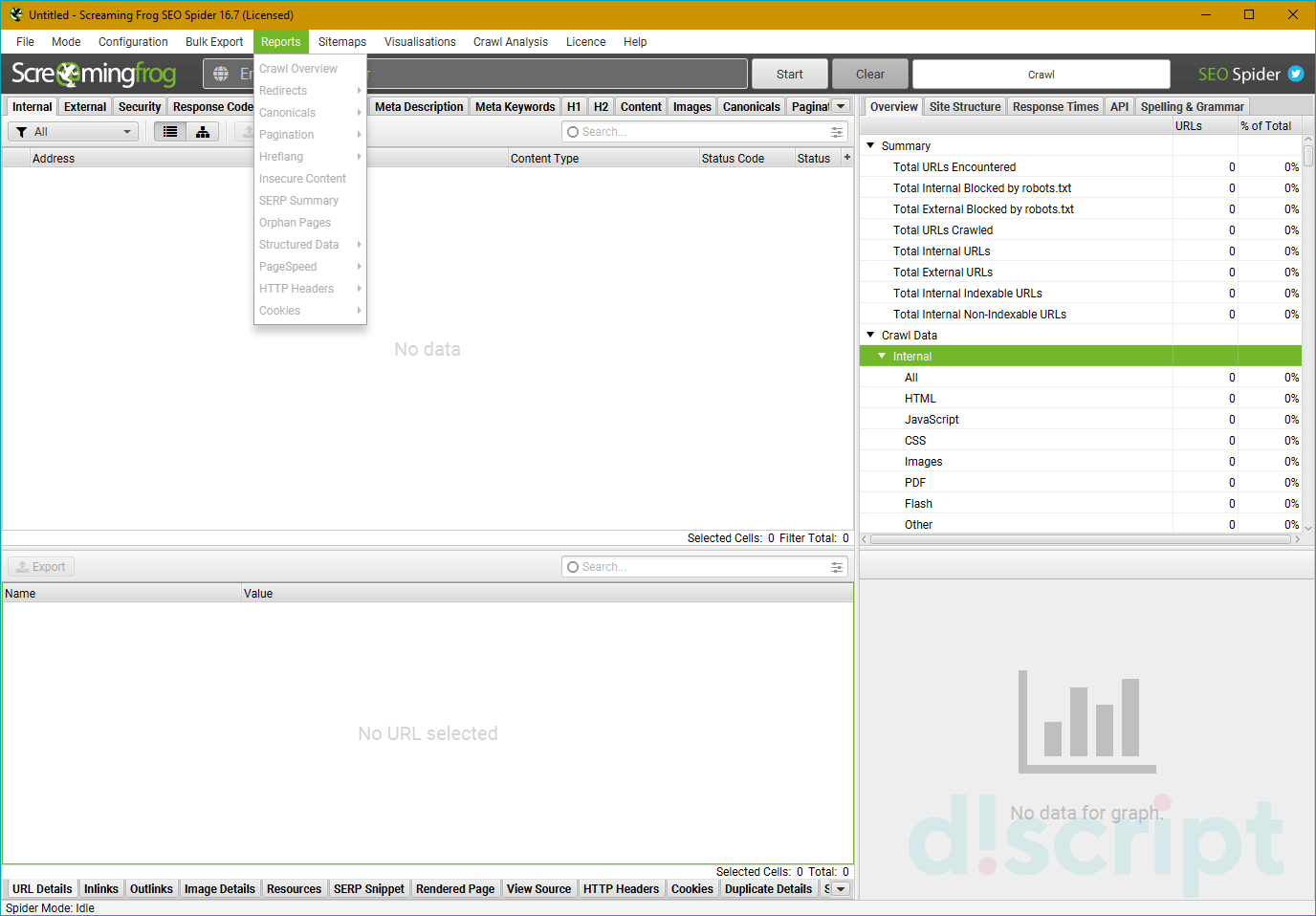

Reports

Здесь содержится множество различных отчетов, которые также можно выгрузить.

- Crawl Overview — в этом отчете содержится сводная информация о сканировании, включая такие данные, как количество найденных URL-адресов, заблокированных robots.txt, число сканированных, тип контента, коды ответов и т. д.

- Redirect & Canonical Chains — отчет о перенаправлении и канонических цепочках. Здесь отображаются цепочки перенаправлений и канонических символов, показывается количество переходов по пути и идентифицируется источник, а также цикличность (если есть).

- Non-Indexable Canonicals — здесь можно получить выгрузку, в которой освещаются ошибки и проблемы с canonical. В частности, этот отчет покажет любые канонические файлы, которые не отдают корректного ответа сервера — заблокированы файлом robots.txt, с перенаправлением 3хх, ошибкой 4хх или 5хх (вообще все что угодно, кроме ответа «ОК» 200).

- Pagination — ошибки и проблемы с атрибутами rel=”next” и rel=”prev”, которые используются для обозначения содержимого, разбитого на пагинацию.

- Hreflang — проблемы с атрибутами hreflang (некорректный ответ сервера, страницы, на которые нет гиперссылок, разные коды языка на одной странице и т.д.).

- Insecure Content — показаны любые защищенные (HTTPS) URL-адреса, на которых есть небезопасные элементы, такие как внутренние ссылки HTTP, изображения, JS, CSS, SWF или внешние изображения в CDN, профили социальных сетей и т. д.

- SERP Summary — этот отчет позволяет быстро экспортировать URL-адреса, заголовки страниц и мета-описания с соответствующими длинами символов и шириной в пикселях.

- Orphan Pages — список потерянных страниц, собранных из Google Analytics API, Google Search Console (Search Analytics API) и XML Sitemap, которые не были сопоставлены с URL-адресами, обнаруженными во время парсинга.

- Structured Data — отчет содержит данные об ошибках валидации микроразметки страниц.

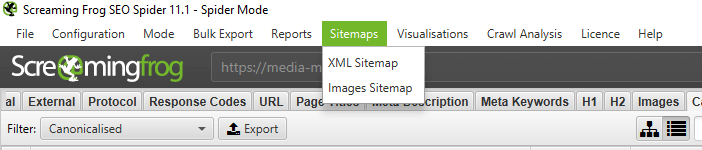

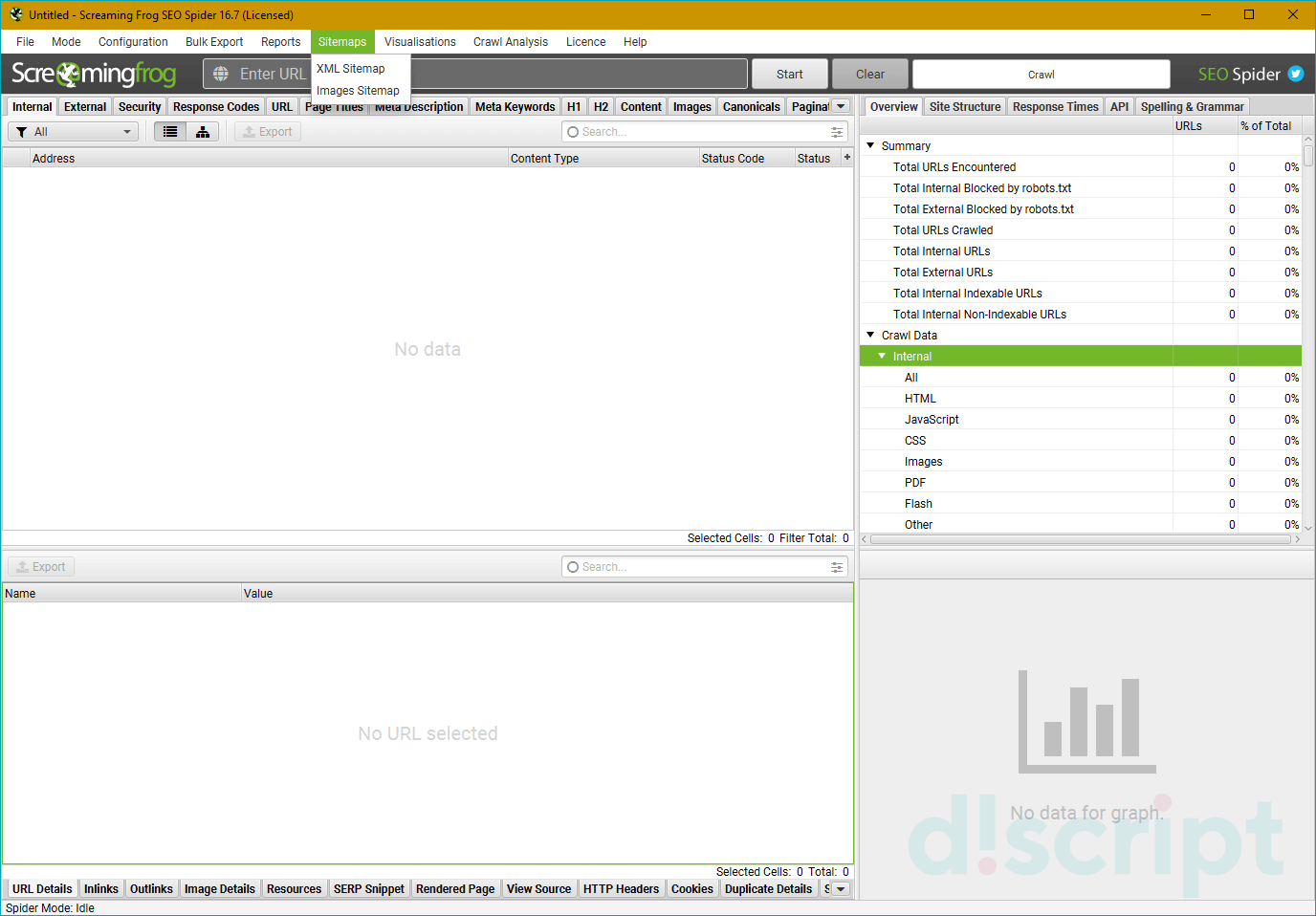

Sitemaps

С помощью этого пункта можно сгенерировать XML-карту сайта (страницы и картинки).

Все просто — выбираем что будем генерировать. В появившемся окне при необходимости выбираем нужные параметры и создаем карту сайта, которую потом заливаем в корневой каталог сайта.

Рассмотрим подробнее параметры, которые нам предлагают выбрать при генерации карты сайта.

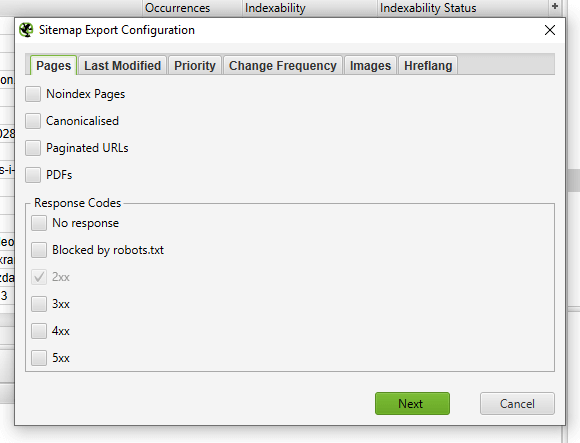

Вкладка Pages — выбираем какие типы страниц включить в карту сайта.

- Noindex Pages — страницы, закрытые от индексации.

- Canonicalised — каноникализированные (опять это страшное слово!) страницы . Другими словами, динамика, у которой есть rel=”canonical”.

- Paginated URLs — страница пагинации.

- PDFs — PDF-документы.

- No response — страницы с кодом ответа сервера 0 (не отвечает).

- Blocked by robots.txt — страницы закрытые от индекса в robots.txt.

- 2xx — страницы с кодом 2хх (они будут в карте в любом случае).

- 3хх — страницы с кодом ответа 3хх (редиректы).

- 4хх — страницы с кодом ответа 4хх (битые ссылки на несуществующие страницы).

- 5хх — страницы с кодом ответа 5хх (проблема сервера при загрузке).

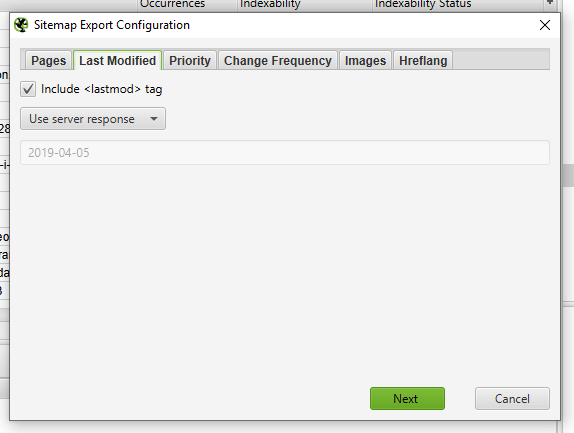

Вкладка Last Modified — выставляем дату последнего обновления карты.

- nclude <lastmod> tag — использовать в sitemap тег <lastmod> (дата последнего обновления карты).

- Use server report — использовать ответ сервера при создании карты, либо проставить дату вручную.

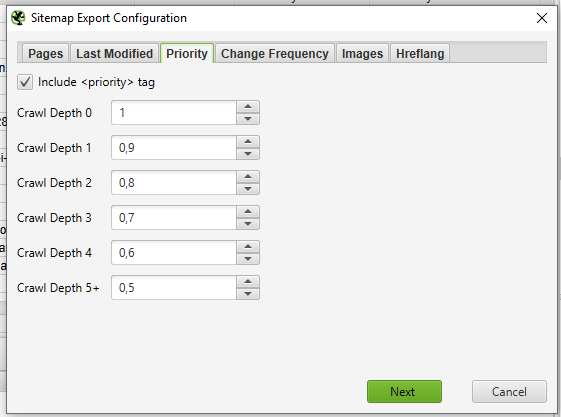

Вкладка Priority — выставляем приоритет ссылки в зависимости от глубины залегания страницы.

- Include <priority> tag — добавляет в карту сайта тег <priority>, показывающий приоритет страницы.

- Crawl Depth 0-5+ — в зависимости от глубины залегания страницы, можно проставить ее приоритет сканирования для поискового робота.

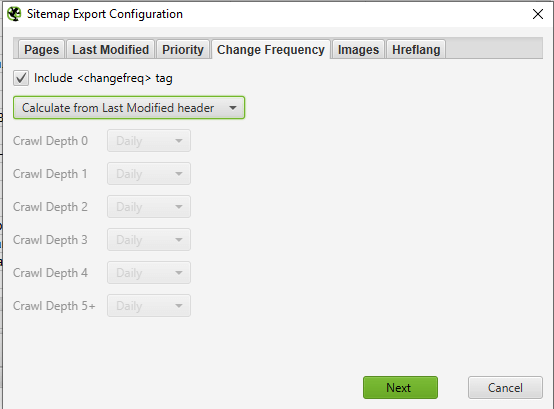

Вкладка Change Frequency — выставляем вероятную частоту обновления страниц.

- Include <changefreq> tag — использовать тег <changefreq> в карте сайта. Показывает частоту обновления страницы.

- Calculate from Last Modified header — рассчитать тег по последнему измененному заголовку.

- Use crawl depth settings — проставить тег в зависимости от глубины страницы.

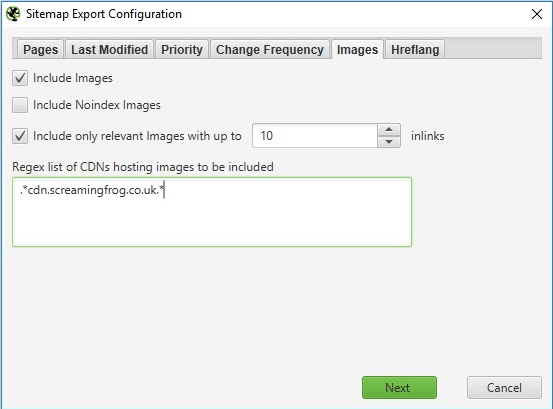

Вкладка Images — добавляем картинки в карту сайта.

- Include Images — выводить в общей карте сайта картинки.

- Include Noindex Images — добавить картинки, закрытые от индекса.

- Include only relevant Images with up to … inlinks — добавить только картинки с заданным числом входящих ссылок.

- Regex list of CDNs hosting images to be included — честно, так и не понял что это такое… возможно настройка выгрузки в карту сайта картинок из хостинга (т.е. можно вбить списком несколько хостов и оттуда подтянуть картинки), но это всего лишь мои предположения.

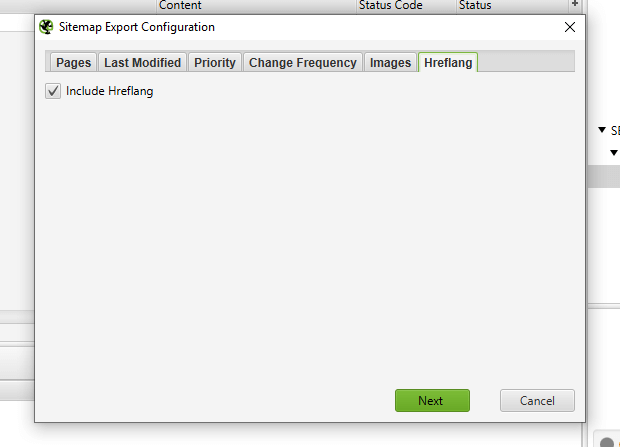

Вкладка Hreflang — использовать в sitemap атрибут <hreflang> (или не использовать).

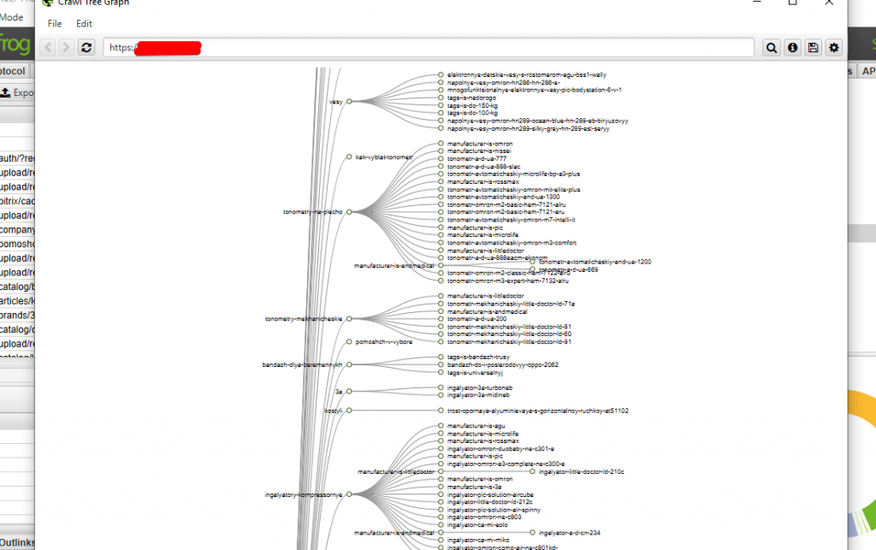

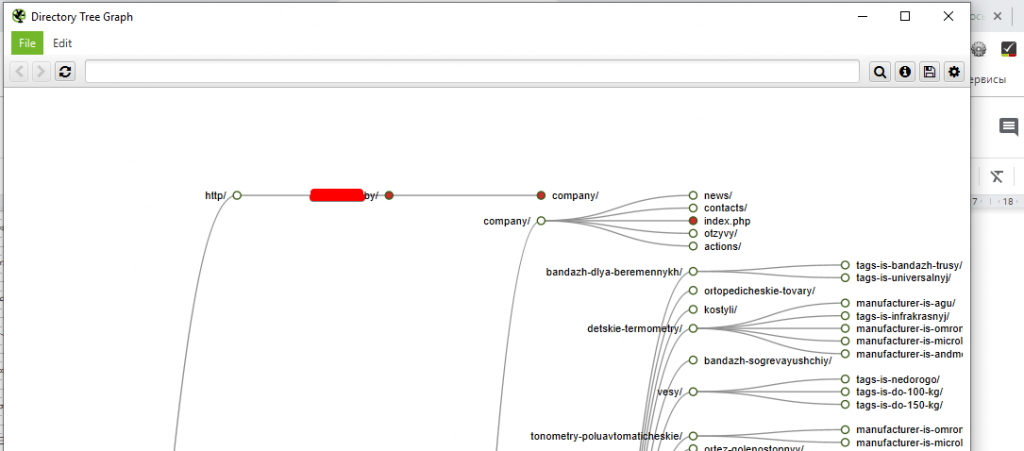

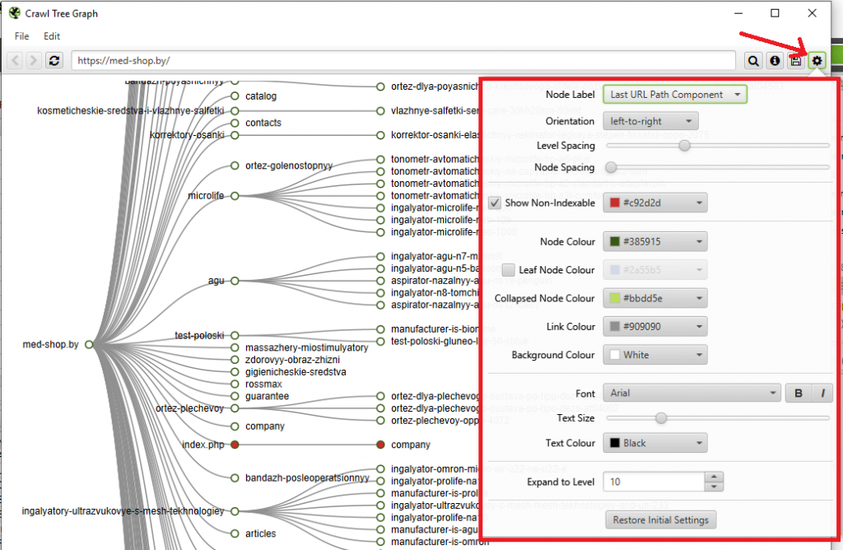

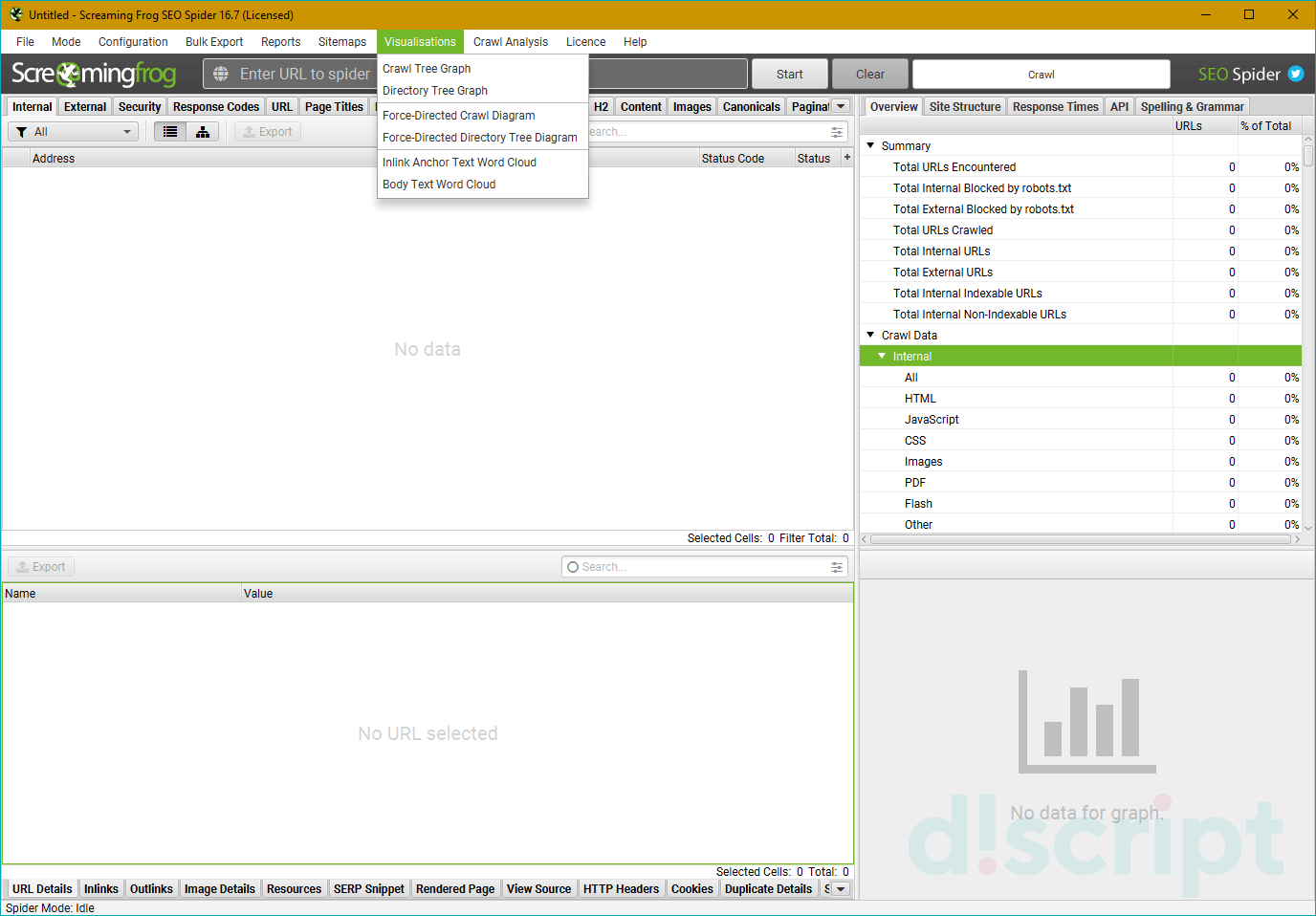

Visualisations

Это выбор интерактивной визуализации структуры сайта в программе. Можно получить отображение дерева сканирования и дерева каталогов. Основная фишка в том, что открываются эти карты и диаграммы во встроенном браузере программы, что позволяет эффективнее с ними работать (настраивать выведение, масштабировать, перескакивать к нужным урлам через поиск и т.д.).

Crawl Tree Graph — визуализация сканирования. По факту после завершения краулинга показывает текущую структуру сайта на основании анализа.

Directory Tree Graph — показывает ВСЕ каталоги после сканирования. Т.е. отличие от Crawl Tree Graph в том, что в этом отчете показываются, например, папки, закрытые от индекса.

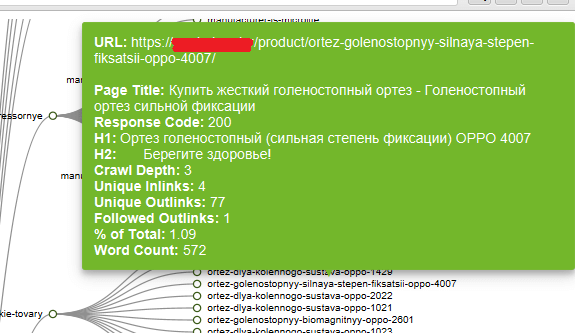

Назначение Crawl Tree Graph и Directory Tree Graph в основном заключается в упрощении анализа структуры текущего сайта, можно глазами пробежаться по всем папкам, зацепиться за косяки (т.к. они выделены цветом). При наведении на папку, показывается ее данные (url, title, h1, h2 и т.д.).

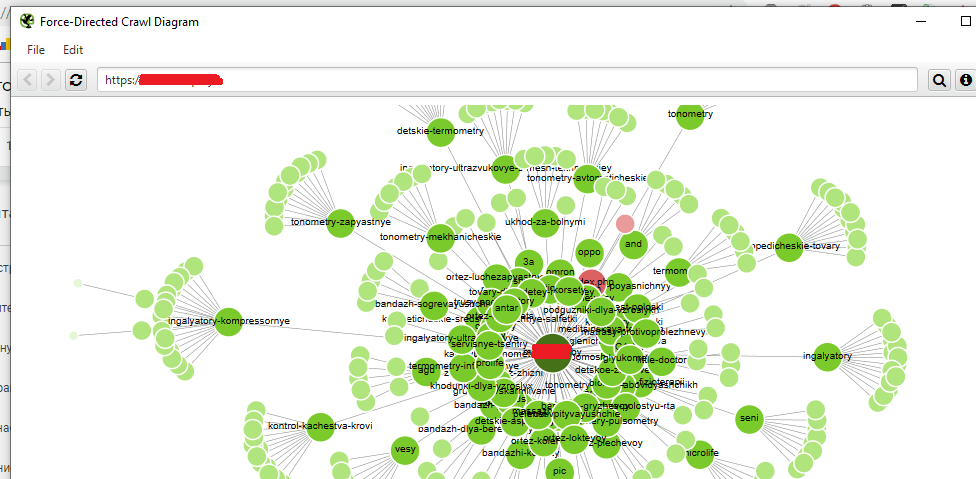

Force Directed Crawl-Diagram — по сути то же самое, что и Crawl Tree Graph, только оформленное по-другому + показывает сканирование сайта относительно главной страницы (ну или стартовой). Кому-то покажется нагляднее, хотя по мне, выглядит гораздо сложнее для восприятия.

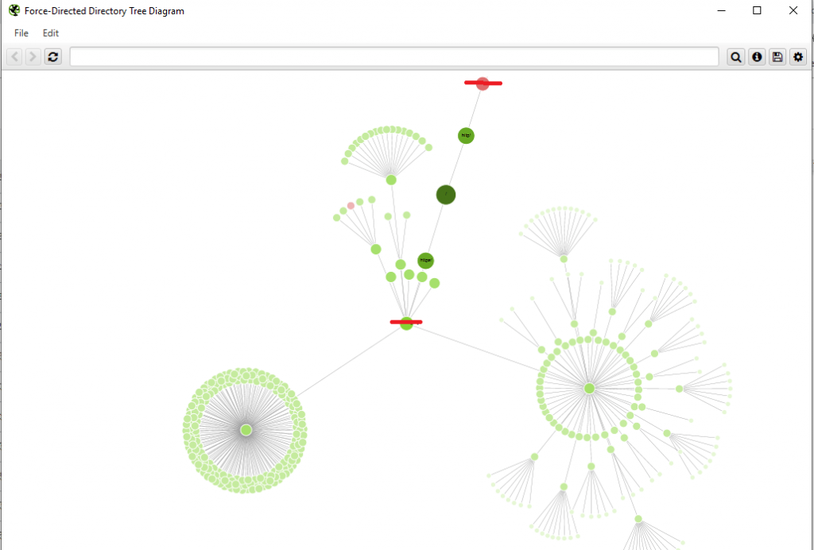

Force Directed Tree-Diagram — аналогично, другой тип визуализации дерева каталогов сайта.

Inlink Anchor Text Word Cloud — визуализация анкоров (ссылочного текста) внутренней ссылки. Анализирует каждую страницу по-отдельности. Помогает понять какими анкорами обозначена страница, как их много, насколько разнообразны и т.д.

Р- Разнообразие

Body Text Word Cloud — визуализация плотности отдельных слов на странице. По сути выглядит так же, как и Inlink Anchor Text Word Cloud, так что отдельный скрин делать смысла особого нет — обычное облако слов, по размеру можно определить какое слово встречается чаще, по общему числу посмотреть разнообразие слов на странице и т.д.

Каждая визуализация имеет массу настроек вывода данных, маркировки — про них я писать не буду, если станет интересно, сами поиграетесь, ок? Там ничего сложного.

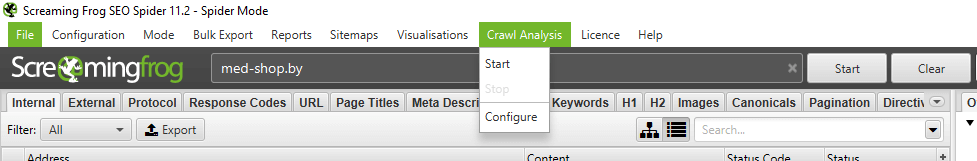

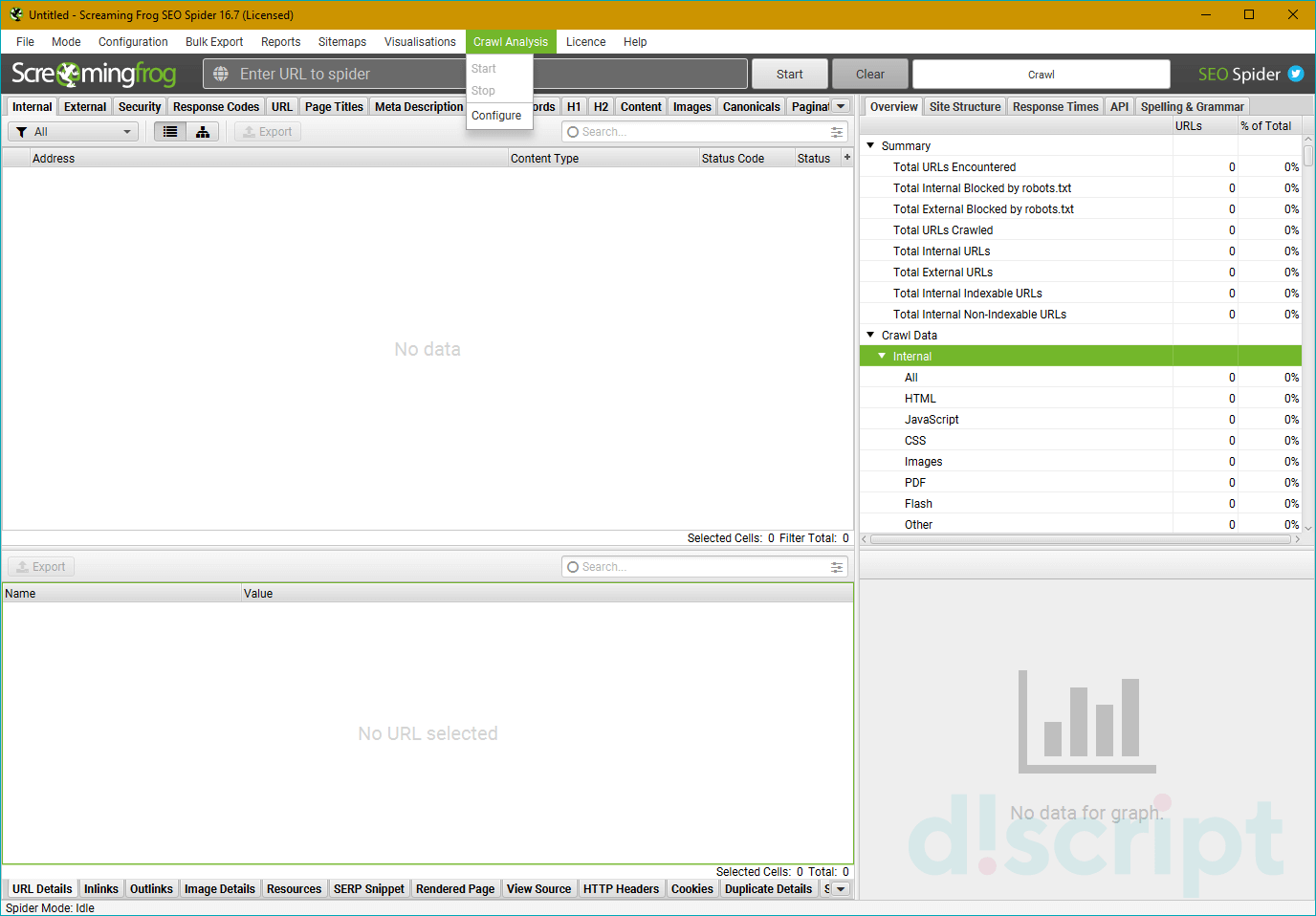

Crawl Analysis

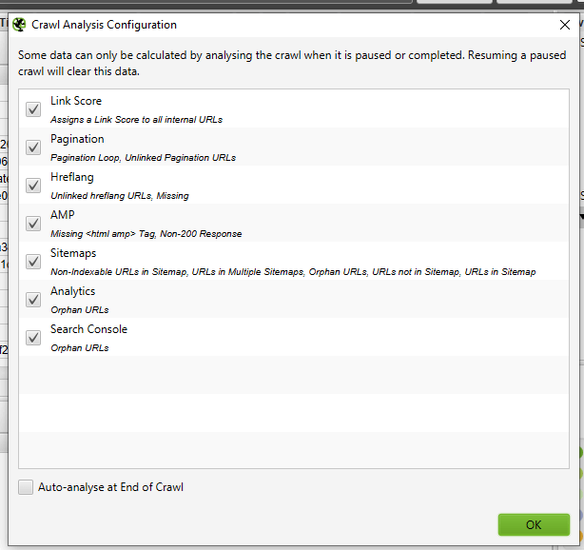

Большинство параметров сайта вычисляется пауком в ходе сбора статистики, однако некоторые данные (Link Score, некоторые фильтры и прочее) нуждаются в дополнительном анализе, чтобы попасть в финальный отчет. Данные, которые нуждаются в Crawl Analysis, помечены соответствующим образом в правом меню навигации.

Crawl Analysis запускается после основного парсинга. Перед запуском дополнительного анализа, можно настроить его (какие данные выводить в отчет).

- Link Score — присвоение оценок всем внутренним ссылкам сайта.

- Pagination — показывает петлевые пагинации, а также страницы, которые обнаружены только через атрибуты rel=”next”/”prev”.

- Hreflang — урлы hreflang без гиперссылки, битые ссылки.

- AMP — страницы без тегов “html amp”, теги не с 200 кодом ответа.

- Sitemaps — неиндексируемые страницы в карте сайта, урлы в нескольких картах сайта, потерянные страницы (например, есть в Google Analytics, есть в sitemap, не обнаружено при парсинге), страницы, которых нет в карте сайта, страницы в карте сайта.

- Analytics — потерянные страницы (есть в аналитике, нет в парсинге).

- Search Console — потерянные страницы (есть в вебмастере, нет в парсинге).

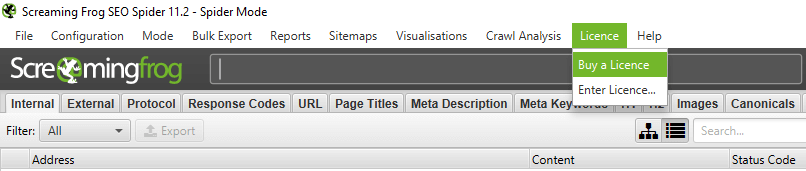

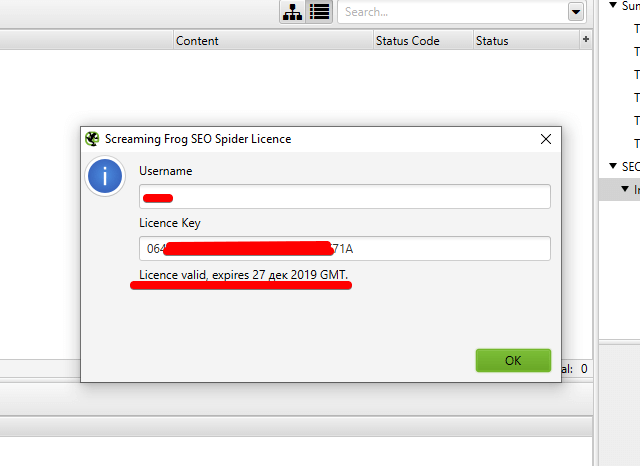

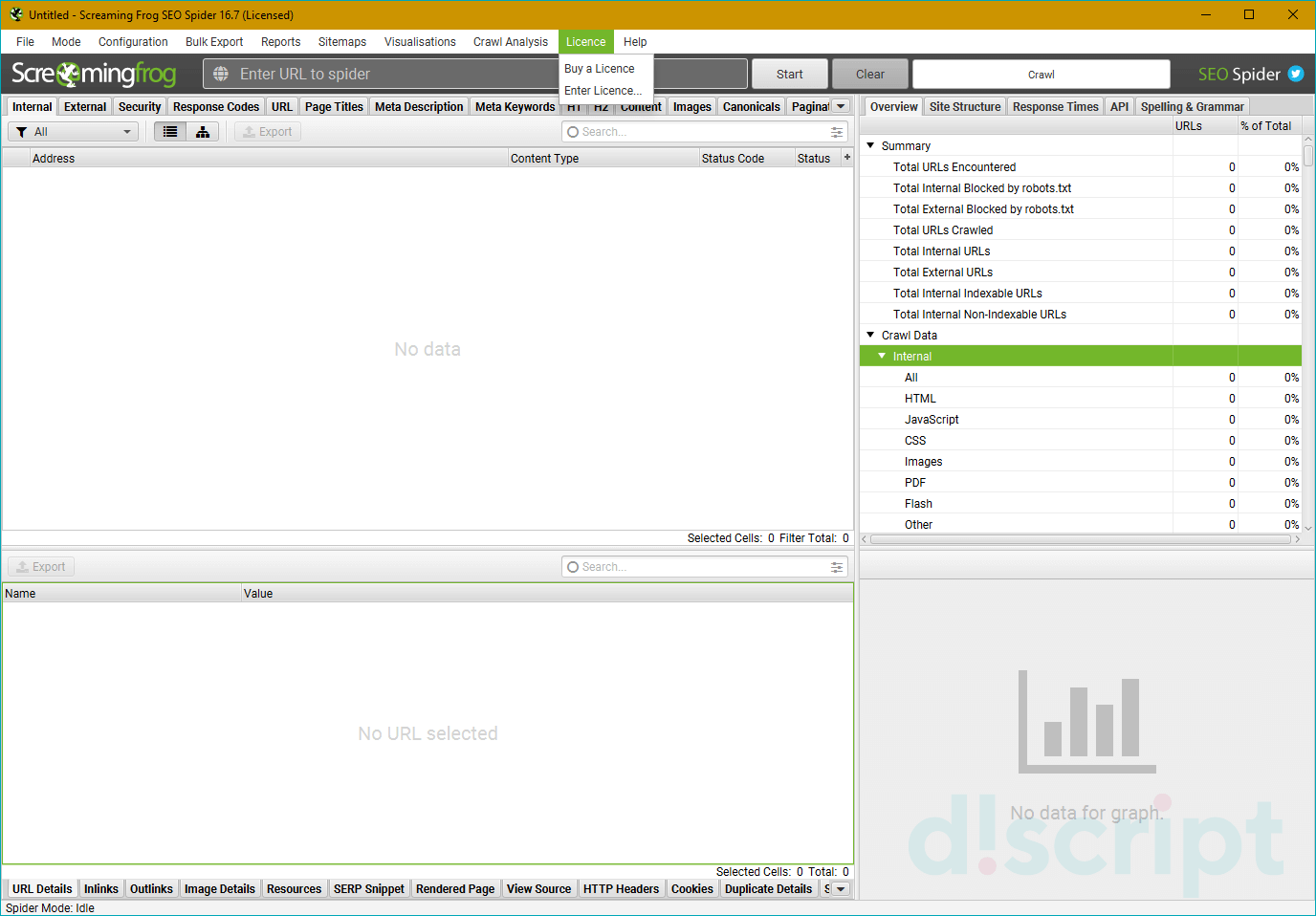

License

Исходя из названия, логично предположить, что этот пункт меню отвечает за разного рода манипуляции с активацией продукта…иии так оно и есть!

Buy a License — купить лицензию. При клике переход на соответствующую страницу официалов https://www.screamingfrog.co.uk/seo-spider/licence/. Стоимость ключа для одного ПК — 149 фунтов стерлинга. Есть пакеты для нескольких ПК, там, как обычно, идут скидки за опт.

Enter License — ввести логин и ключ лицензии, чтобы активировать полный функционал парсера.

Заметили, да? Лицензия покупается на год, не бессрочная

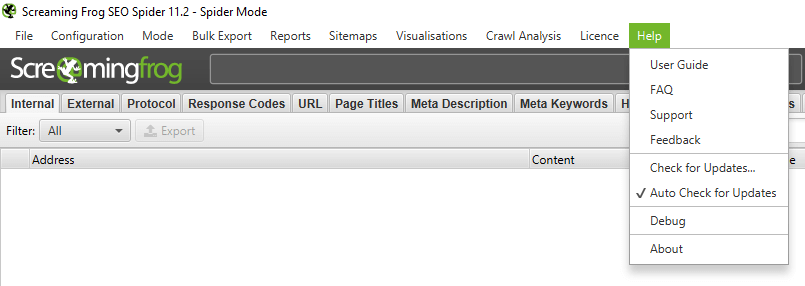

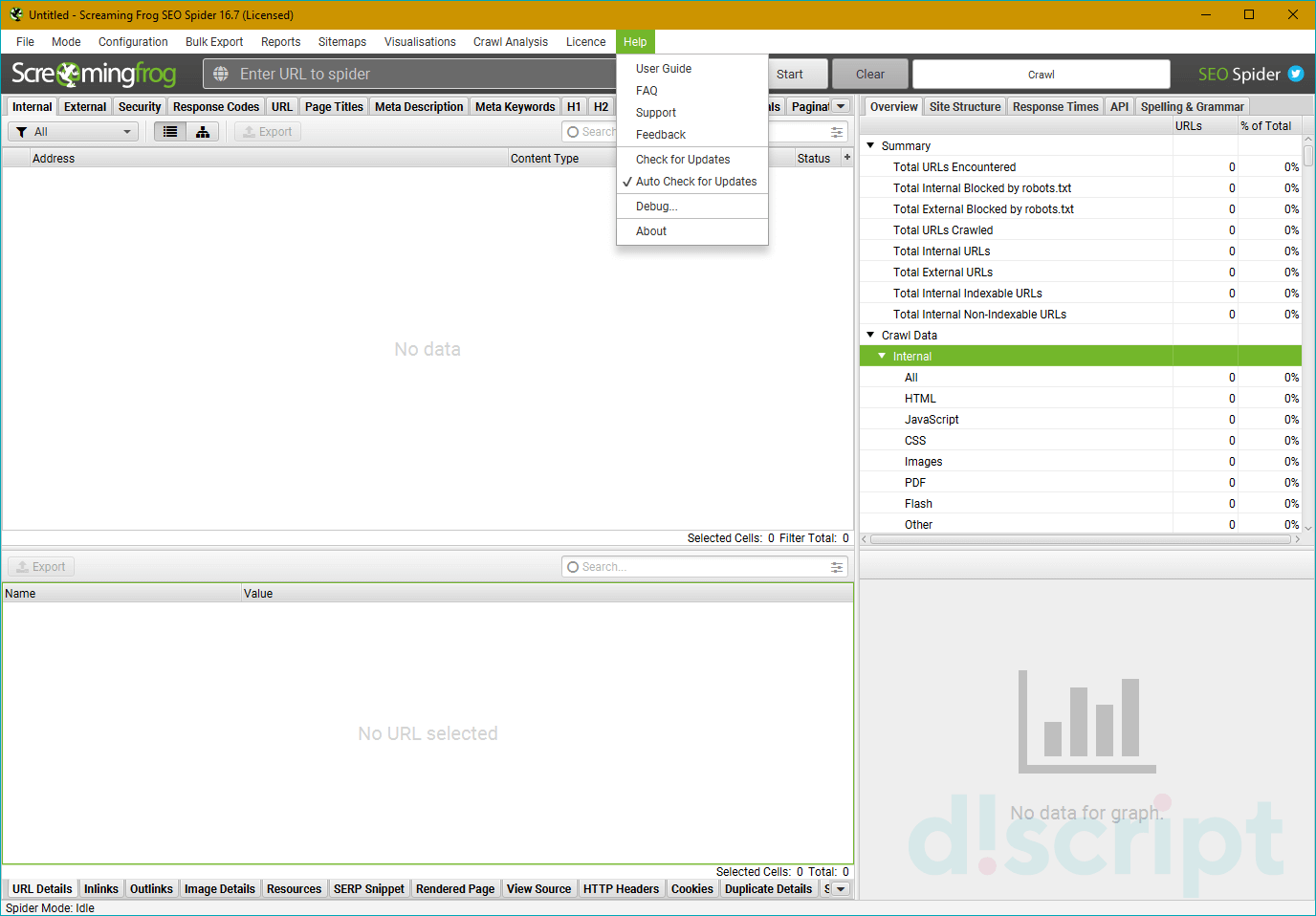

Help

Помощь юзеру — гайды, FAQ, связь с техподдержкой, в общем все, что связано с работой программы, ее багами и их решением.

- User Guide — мануал по работе с программой. Собственно, его я использовал, как один из источников, для написания этой статьи. При желании, можете ознакомиться, если я что-то непонятно рассказал или не донес. Еще раз оставлю ссылку https://www.screamingfrog.co.uk/seo-spider/user-guide/.

- FAQ — часто задаваемые вопросы по работе с SF и ответы на них https://www.screamingfrog.co.uk/seo-spider/faq/.

- Support — обратная связь с техподдержкой https://www.screamingfrog.co.uk/seo-spider/support/. Если программа ведет себя некрасиво (например, не принимает ключ лицензии), можно пожаловаться куда надо и все починят.

- Feedback — обратная связь. Та же самая страница, что и в Support. Т.е. можно не только жаловаться, но и вносить предложения по работе программы, предлагать партнерку, сказать банальное “спасибо” за такой крутой сервис (думаю ребятам будет приятно).

- Check for Updates и Auto Check for Updates — проверка на наличие обновлений программы. Screaming Frog нерегулярно, но довольно часто дорабатывается, поэтому есть смысл периодически проверять апдейты. Но лучше поставить галочку на Auto Check for Updates и программа сама будет автоматически предлагать обновиться при выходе нового апа.

- Debug — отчет о текущем состоянии программы. Нужно, если вы словили какой-то баг и хотите о нем сообщить разработчику. Там еще дополнительно есть настройки дебага, но я думаю, нет смысла заострять на этом внимание.

- About — собственно, краткая информация о самой программе (копирайт, сервисы, которые использовались при разработке).

Итог

Screaming Frog — очень гибкая в плане настройке утилита, с помощью которой можно вытянуть массу данных для анализа, нужно только (только… ха-ха) правильно настроить парсинг. Я надеюсь, мой мануал поможет вам в этом, хотя и не все я рассмотрел как надо, есть пробелы, но основные функции должны быть понятны.

Теперь от себя — текста много, скринов много, потому, если вы начинающий SEO-специалист, рекомендую осваивать SF поэтапно, не хватайтесь за все сразу, ибо есть шанс упустить важные нюансы.

Ну вот и все, ребята, я отчаливаю за новым материалом для нашего крутого блога. Подписывайтесь, чтобы не пропустить интересные публикации от меня и моих коллег. Всем удачи, всем пока!

Оригинал статьи взят с сайта MAXI.BY media

Attention! Много букв! Много скринов! Много смысла!

Доброго времени суток, друзья. Сегодня я хочу рассказать вам о настройке Screaming Frog (он же SF, он же краулер, он же паук, он же парсер — сразу определимся со всеми синонимами, ок?).

SF — очень полезная программа для анализа внутрянки сайтов. С помощью этой утилиты можно быстро выцепить технические косяки сайта, чтобы составить грамотное ТЗ на доработку. Но чтобы увидеть проблему, надо правильно настроить краулера, верно? Об этом мы сегодня с вами и поговорим.

- Примечание автора: сразу скажу — программа имеет много вкладок и настроек, которые по сути не нужны рядовому пользователю, потому я подробно опишу только наиболее важные моменты, а второстепенные пройдем вскользь… хотя кого я обманываю, когда это у меня были статьи меньше 30 к символов? *Зануда mode on*

- Примечание автора 2: при написании статьи я пользовался дополнительными материалами в виде официального мануала от разработчиков. Если что, почитать его можно тут https://www.screamingfrog.co.uk/seo-spider/user-guide/. Не пугайтесь английского, Google-переводчик в помощь — вполне себе сносная адаптация получается.

- Примечание автора 3: я люблю оставлять примечания…

- File

- Configuration

- Spider — настройки парсинга сайта

- Robots.txt — определяем каким правилам следовать при парсинге

- URL Rewriting — функция перезаписи URL

- CDNs — парсим поддомены

- Include/Exclude — сканирование/удаление определенных папок

- Speed — регулируем скорость парсинга сайта

- User-Agent — выбираем под кого маскируемся

- HTTP Header — настройка реагирования на разные http-заголовки

- Custom — дополнительные настройки поиска

- User Interface — обнуление настроек для колонок таблицы

- API Access — интеграция с разными сервисами

- Authentification — настройки аутентификации

- System — внутренние настройки самой программы

- Mode

- Bulk export

- Reports

- Sitemaps

- Visualisations

- Crawl Analysis

- License

- Help

Настройка Screaming Frog по шагам

Рассмотрим основное меню программы, для того чтобы понимать что где лежит и что за что отвечает (тавтология… Вова может в копирайт!).

Верхнее меню — управление парсингом, выгрузкой и многое другое

File

Из названия понятно, что это работа с файлами программы (загрузка проектов, конфиги, планирование задач — что-то вроде того).

- Open — открыть файл с уже проведенным парсингом.

- Open Recent — открыть последний парсинг (если вы его сохраняли отдельным файлом).

- Save — собственно, сохранить парсинг.

- Configuration — загрузка/сохранение специальных настроек парсинга вроде выведения дополнительных параметров проверки и т.д. (про то, как задавать эти настройки, я далее расскажу подробнее).

- Crawl Recent — повторно парсить один из последних сайтов, который уже проверялся в этой программе.

- Scheduling — отложенное планирование задач для программы… ни разу не пользовался этой опцией…стыдно.

- Exit — призвать к ответу Друзя… нет, ну серьезно,тут все очевидно.

Configuration

Один из самых интересных и важных пунктов меню, тут мы задаем настройки парсинга.

Ох, сейчас будет сложно — у многих пунктов есть подпункты, у этих подпунктов всплывающие окна с вкладками и кучей настроек…в общем крепитесь, ребята, будет много инфы.

Spider — собственно, настройки парсинга сайта

Вкладка Basic — выбираем что парсить

- Check Images — в отчет включаем анализ картинок.

- Check CSS — в отчет включаем анализ css-файлов (скрипты).

- Check JavaScript — в отчет включаем анализ JS-файлов (скрипты).

- Check SWF — в отчет включаем анализ Flash-анимации.

- Check External Link — в отчет включаем анализ ссылок с сайта на другие ресурсы.

- Check Links Outside of Start Folder — проверка ссылок вне стартовой папки. Т.е. отчет будет только по стартовой папке, но с учетом ссылок всего сайта.

- Follow internal “nofollow” — сканировать внутренние ссылки, закрытые в тег “nofollow”.

- Follow external “nofollow” — сканировать ссылки на другие сайты, закрытые в тег “nofollow”.

- Crawl All Subdomains — парсить все поддомены сайта, если ссылки на них встречаются на сканируемом домене.

- Crawl Outside of Start Folder — позволяет сканировать весь сайт, однако проверка начинается с указанной папки.

- Crawl Canonicals — выведение в отчете атрибута rel=”canonical” при сканировании страниц.

- Crawl Next/Prev — выведение в отчете атрибутов rel=”next”/”prev” при сканировании страниц пагинации.

- Extract hreflang/Crawl hreflang — при сканировании учитываются языковой атрибут hreflang и отображаются коды языка и региона страницы + формирование отчета по таким страницам.

- Extract AMP Links/Crawl AMP Links — извлечение в отчет ссылок с атрибутом AMP (определение версии контента на странице).

- Crawl Linked XML Sitemap — сканирование карты сайта. Тут краулер либо берет sitemap из robots.txt (Auto Discover XML Sitemap via robots.txt), либо берет карту по указанному пользователем пути (Crawl These Sitemaps).

Ну что, сложно? На самом деле просто нужна привычка и немного практики, чтобы освоить основные настройки SF и понять что нужно использовать в конкретных случаях, а от чего можно отказаться. Все, передохнули, теперь дальше… будет проще (нет).

Вкладка Limits — определяем лимиты парсинга

- Limit Crawl Total — задаем лимиты страниц для сканирования. Сколько всего страниц выгружаем для одного проекта.

- Limit Crawl Depth — задаем глубину парсинга. До какого уровня может дойти краулер при сканировании проекта.

- Limit Max Folder Depth — можно контролировать глубину парсинга вплоть до уровня вложенности папки.

- Limit Number of Query Strings — тут, если честно, сам не до конца разобрался, потому объясню так, как понял — мы ограничиваем лимит страниц с параметрами. Другими словами, если на одной статической странице есть несколько фильтров, то их комбинация может породить огромное количество динамических страниц. Вот чтобы такие “полезные” страницы не парсились (увеличивает время анализа в разы, а толковой информации по сути ноль), мы и выводим лимиты по Query Strings. Пример динамики — site.ru/?query1&query2&query3&queryN+1.

- Max Redirects to Follow — задаем максимальное количество редиректов, по которым паук может переходить с одного адреса.

- Max URL Length to Crawl — максимальная длина URL для обхода (указываем в символах, я так понимаю).

- Max Links per URL to Crawl — максимальное количество ссылок на URL для обхода (указываем в штуках).

- Max Page Size (KB) to Crawl — максимальный размер страницы для обхода (указываем в килобайтах).

Вкладка Rendering — настраиваем параметры рендеринга (только для JS)

На выбор три опции — “Text Only” (паук анализирует только текст страницы, без учета Аякса и JS), “Old AJAX Crawling Scheme” (проверяет по устаревшей схеме сканирования Аякса) и “JavaScript” (учитывает скрипты при рендеринге). Детальные настройки есть только у последнего, их и рассмотрим.

- Enable Rendered Page Screen Shots — SF делает скриншоты анализируемых страниц и сохраняет их в папке на ПК.

- AJAX Timeout (secs) — лимиты таймаута. Как долго SEO Spider должен разрешать выполнение JavaScript, прежде чем проверять загруженную страницу.

- Window Size — выбор размера окна (много их — смотрим скриншот).

- Sample — пример окна (зависит от выбранного Window Size).

- Чекбокс Rotate — повернуть окно в Sample.

Вкладка Advanced — дополнительные опции парсинга

- Allow Cookies — учитывать Cookies, как это делает поисковый бот.

- Pause on High Memory Used — тормозит сканирование сайта, если процесс забирает слишком много оперативной памяти.

- Always Follows Redirect — разрешаем краулеру идти по редиректам вплоть до финальной страницы с кодом 200, 4хх, 5хх (по факту все ответы сервера, кроме 3хх).

- Always Follows Canonicals — разрешаем краулеру учитывать все атрибуты “canonical” вплоть до финальной страницы. Полезно, если на страницах сайта бардак с настройкой этого атрибута (например, после нескольких переездов).

- Respect Noindex — страницы с “noindex” не отображаются в отчете SF.

- Respect Canonical — учет атрибута “canonical” при формировании итогового отчета. Полезно, если у сайта много динамических страниц с настроенным rel=”canonical” — позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Respect Next/Prev — учет атрибутов rel=”next”/”prev” при формировании итогового отчета. Полезно, если у сайта есть страницы пагинации с настроенными “next”/”prev”- позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Extract Images from img srscet Attribute — изображения извлекаются из атрибута srscet тега <img>. SRSCET — атрибут, который позволяет вам указывать разные типы изображений для разных размеров экрана/ориентации/типов отображения.

- Respect HSTS Policy — если чекбокс активен, SF будет выполнять все будущие запросы через HTTPS, даже если перейдет по ссылке на URL-адрес HTTP (в этом случае код ответа будет 307). Если же чекбокс неактивен, краулер покажет «истинный» код состояния за перенаправлением (например, постоянный редирект 301).

- Respect Self Referencing Meta Refresh — учитывать принудительную переадресацию на себя же (!) по метатегу Refresh.

- Response Timeout — время ожидания ответа страницы, перед тем как парсер перейдет к анализу следующего урла. Можно сделать больше (для медленных сайтов), можно меньше.

- 5хх Response Retries — количество попыток “достучаться” до страниц с 5хх ответом сервера.

- Store HTML — можно сохранить статический HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть его до того, как JavaScript “вступит в игру”.

- Store Rendered HTML — позволяет сохранить отображенный HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть DOM после обработки JavaScript.

- Extract JSON-LD — извлекаем микроразметку сайта JSON-LD. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract Microdata — извлекаем микроразметку сайта Microdata. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract RDFa — извлекаем микроразметку сайта RDFa. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

Вкладка Preferences — так называемые “предпочтения”

Здесь задаем желаемые параметры для некоторых сканируемых элементов (title, description, url, H1, H2, alt картинок, размер картинок). Соответственно, если сканируемые элементы сайта не будут соответствовать нашим предпочтениям, программа нам об этом сообщит в научно-популярной форме. Совершенно необязательные настройки — каждый прописывает для себя свой идеал… или вообще их не трогает, от греха подальше (как делаю я).

- Page Title Width — оптимальная ширина заголовка страницы. Указываем желаемые размеры от и до в пикселях и в символах.

- Meta Description Width — оптимальная ширина описания страницы. Аналогично, как и с тайтлом, указываем желаемые размеры.

- Other — сюда входит максимальная желаемая длина урл-адреса в символах (Max URL Length Chars), максимальная длина H1 в символах (Max H1 Length Chars), максимальная длина H2 в символах (Max H2 Length Chars), максимальная длина ALT картинок в символах (Max Image Length Chars) и максимальный вес картинок в КБ (Max Image Size Kilobytes).

Robots.txt — определяем каким правилам следовать при парсинге

Вкладка Settings — настраиваем парсинг относительно правил robots.txt

- Respect robots.txt — следуем всем правилам, прописанным в robots.txt. Т.е. учитываем в анализе те папки и файлы, которые открыты для робота.

- Ignore robots.txt — не учитываем robots.txt сайта при парсинге. В отчет попадают все папки и файлы, относящиеся к домену.

- Ignore robots.txt but report status — не учитываем robots.txt сайта при парсинге, однако в дополнительном меню выводится статус страницы (индексируемая или не индексируемая).

- Show internal/external URLs blocked by robots.txt — отмечаем в чекбоксах хотим ли мы видеть в итоговом отчете внутренние и внешние ссылки, закрытые от индексации в robots.txt. Данная опция работает только при условии выбора “Respect robots.txt”.

Вкладка Custom — ручное редактирование robots.txt в пределах текущего парсинга

Удобно, если вам нужно при парсинге сайта учитывать (или исключить) только определенные папки, либо же добавить правила для поддоменов. Кроме того, можно быстро сформировать и проверить свой рабочий robots, чтобы потом залить его на сайт.

Шаг 1. Прописать анализируемый домен в основной строке

Шаг 2. Кликнуть на Add, чтобы добавить robots.txt домена

Тут на самом деле все очень просто, поэтому я по верхам пробегусь по основным опциям (а в конце будет видео, где я бездумно прокликиваю все кнопки).

- Блок Subdomains — сюда, собственно, можно добавлять домены/поддомены, robots.txt которых мы хотим учитывать при парсинге сайта.

- Окно справа — для редактирования выгруженного robots.txt. Итоговый вариант будет считаться каноничным для парсера.

- Окошко снизу — проверка индексации url в зависимости от настроенного robots.txt. Справа выводится статус страницы (Allowed или Disallowed).

URL Rewriting — функция перезаписи URL «на лету»

Тут мы можем настроить перезапись урл-адресов домена прямо в ходе парсинга. Полезно, когда нужно заменить определенные регулярные выражения, которые засоряют итоговый отчет по парсингу.

Вкладка Remove Parameters

Вручную вводим параметры, которые нужно удалять из url при анализе сайта, либо исключить вообще все возможные параметры (чекбокс “Remove all”). Полезно, если у страниц сайта есть идентификаторы сеансов, отслеживание контекста (utm_source, utm_medium, utm_campaign) или другие фишки.

Вкладка Regex Replace

Изменяет все сканируемые урлы с использованием регулярных выражений. Применений данной настройки масса, я приведу только несколько самых распространенных примеров:

- Изменение всех ссылок с http на https (Регулярное выражение: http Заменить: https).

- Изменение всех ссылок на site.by на site.ru (Регулярное выражение: .by Заменить: .ru).

- Удаление всех параметров (Регулярное выражение: \?. * Заменить: ).

- Добавление параметров в URL (Регулярное выражение: $ Заменить: ?ПАРАМЕТР).

Вкладка Options

Вы рассчитывали увидеть здесь еще 100500 дополнительных опций для суперточной настройки URL Rewriting, я прав? Как бы странно это ни звучало, но здесь мы всего лишь определяем перезаписывать все прописные url-адреса в строчные или нет… вот как-то так, не спрашивайте, я сам не знаю почему для этой опции сделали целую отдельную вкладку.

Вкладка Test

Тут мы можем предварительно протестировать видоизменение url перед началом парсинга и, соответственно, подправить регулярные выражения, чтобы на выходе не получилось какой-нибудь ерунды.

CDNs — парсим поддомены, не отходя от кассы

Использование настройки CDNs позволяет включать в парсинг дополнительные домены/поддомены/папки, которые будут обходиться пауком и при этом считаться внутренними ссылками. Полезно, если нужно проанализировать массив сайтов, принадлежащих одному владельцу (например, крупный интернет-магазин с сетью сайтов под регионы). Также можно прописывать регулярные выражения на конкретные пути сканирования — т.е. парсить только определенные папки.

Во вкладке Test можно посмотреть как будут определяться урлы в зависимости от используемых параметров (Internal или External).

Include/Exclude — сканирование/удаление определенных папок

Можно регулярными выражениями задать пути, которые будут сканироваться внутри домена. Также можно запретить парсинг определенных папок. Единственный нюанс в настройках — при использовании Include будут парситься только УКАЗАННЫЕ папки, если же мы добавляем урлы в Exclude, сканироваться будут все папки, КРОМЕ УКАЗАННЫХ.

Выбираем папки для парсинга

Удаляем папки из парсинга

Примеры регулярных выражений для Exclude:

- http://site.by/obidnye-shutki-pro-seo.html (исключение конкретной страницы).

- http://site.by/obidnye-shutki-pro-seo/.* (исключение целой папки).

- http://site.by/.*/obidnye-shutki-pro-seo/.* (исключение всех страниц, после указанной).

- .*\?price.* (исключение страниц с определенным параметром).

- .*jpg$ (исключение файлов с определенным расширением).

- .*seo.* (исключение страниц с вхождением в url указанного слова).

- .*https.* (исключение страниц с https).

- http://site.by/.* (исключение всех страниц домена/поддомена).

Speed — регулируем скорость парсинга сайта

Можно выставить как количество потоков (по умолчанию 5), так и число одновременно сканируемых адресов. Влияет на скорость парсинга и вероятность бана бота, так что тут лучше не усердствовать.

User-Agent — выбираем под кого маскируемся

В списке user-agent можно выбрать от лица какого бота будет происходить парсинг сайта. Удобно, если в настройках сайта есть директивы, блокирующие того или иного бота (например, запрещен google-bot). Также полезно иногда прокраулить сайт гугл-ботом для смартфона, чтобы проверить косяки адаптива или мобильной версии.

Скажу сразу — это опция очень индивидуальна, лично я ее не пользую, потому что чаще всего незачем. В любом случае, настройка реагирования на http-заголовки позволяет определить, как паук будет их обрабатывать (если указаны нюансы в настройках). По крайней мере я так это понял.

Т.е. можно индивидуально настроить, например, какого формата контент обрабатывать, учитывать ли cookie и т.д. Нюансов там довольно много.

Custom — дополнительные настройки поиска по исходному коду

Custom Search

По сути обычный фильтр, с помощью которого можно вытягивать дополнительные данные, например, страницы, в которых вместо тега <strong> используется <bold> или еще лучше — страницы, которые НЕ содержат определенного контента (например, без кода счетчика метрики). Фактически в настройках можно задать все что угодно.

Custom Extraction

Это пользовательское извлечение любых данных из html (например, текстовое содержимое).

User Interface — обнуление настроек для колонок таблицы

Просто сбрасывает сортировку столбцов, ничего особенного, проходим дальше, граждане, не толпимся.

API Access — интеграция с разными сервисами

Для того чтобы получать больше данных по сайту, можно настроить интеграцию с разными сервисами статистики типа Google Analytics или Majestic, при условии того, что у вас есть аккаунт в этом сервисе.

При этом для каждого сервиса отдельные настройки выгрузки по типам данных.

На примере GA

Authentification — настройки аутентификации (если есть запрос от сайта)

Есть два вида аутентификации — Standart Based и Form Based. По умолчанию используется Standart Base — если при парсинге от сайта приходит запрос на аутентификацию, в программе появляется соответствующее окно.

Form Based — использование для аутентификации встроенного в SF браузера (полезно, когда для подтверждения аутентификации нужно, например, пройти капчу). В данном случае необходимо вручную вводить урл сайта и в открывшемся окне браузера вводить логин/пароль, кликать recaptcha и т.д.

System — внутренние настройки самой программы

Настройки работы самой программы — сколько оперативной памяти выделять на процесс, куда сохранять экспорт и т.д.

Давайте как обычно — подробнее о каждом пункте.

- Memory — выделяем лимиты оперативной памяти для парсинга. По дефолту стоит 2GB, но можно выделить больше (если ПК позволяет).

- Storage — выбор базы для хранения данных. Либо сохранение в ОЗУ (для этого у SF есть свой движок), либо в указанной папке на ПК пользователя.

- Proxy — подключение прокси-сервера для парсинга.

- Embedded Browser — использование встроенного в программу браузера (вкл/выкл).

Mode

- Spider (Режим паука) — классический парсинг сайта по внутренним ссылкам. Просто вводим нужный домен в адресную строку программы и запускаем работу.

- List — парсим только предварительно собранный список урл-адресов! Адреса можно выгрузить из файла (From a file), вбить вручную (Enter Manually), подтянуть их из карты сайта (Download Sitemap) и т.д. Если честно, этих трех способов получения списка урлов должно быть более чем достаточно.

- SERP Mode — в этом режиме нет сканирования, зато здесь можно загружать мета-данные сайта, редактировать их и предварительно понимать как они будут отображаться в браузере. Делать все это можно пакетно, что вполне себе удобно.

Bulk export

В этом пункте меню висят все опции SF, отвечающие за массовый экспорт данных из основного и дополнительного меню отчета…сейчас покажу на скриншоте.

В общем и целом с помощью bulk export можно вытянуть много разной полезной информации для последующей постановки ТЗ на доработки. Например, выгрузить в excel страницы, на которых найдены ссылки с 3хх ответом сервера + сами 3хх-ссылки, что позволяет сформировать задание для программиста или контент-менеджера (зависит от того, где зашиты 3хх-ссылки) на замену этих 3хх-ссылок на прямые с кодом 200. Теперь подробнее про то, что можно экспортировать при помощи Bulk Export.

- All Inlinks — получаем все входящие ссылки на каждый URI, с которым столкнулся краулер при сканировании сайта.

- All Outlinks — получаем все исходящие ссылки с каждого URI, с которым столкнулся краулер при сканировании сайта.

- All Anchor Text — выгрузка анкоров всех ссылок.

- All Images — выгрузка всех картинок (урл-адресами, естественно).

- Screenshots — экспорт снимков экрана.

- All Page Source — получаем статический HTML-код или обработанный HTML-код просканированных страниц (рендеринг HTML доступен только в режиме рендеринга JavaScript) .

- External Links — все внешние ссылки со всех просканированных страниц.

- Response Codes — все страницы в зависимости от выбранного кода ответа сервера (закрытые от индекса, с кодом 200, с кодом 3хх и т.д.).

- Directives — все страницы с директивами в зависимости от выбранной (Index Inlinks, Noindex Inlinks, Nofollow Inlinks и т.д.).

- Canonicals — страницы, содержащие канонические атрибуты, страницы без указания этих атрибутов, каноникализированные (*перекрестился*) страницы и т.д.

- AMP — страницы с AMP, ссылки с AMP (но код ответа не 200) и т.д.

- Structured Data — выгрузка страниц с микроразметкой.

- Images — выгрузка картинок без альт-текста, тяжелых картинок (в соответствии с указанным в настройках размером).

- Sitemaps — выгрузка всех страниц в карте сайта, неиндексируемых страниц в карте сайта и проч.

- Custom — выгрузка пользовательских фильтров.

Reports

Здесь содержится множество различных отчетов, которые также можно выгрузить.

- Crawl Overview — в этом отчете содержится сводная информация о сканировании, включая такие данные, как количество найденных URL-адресов, заблокированных robots.txt, число сканированных, тип контента, коды ответов и т. д.

- Redirect & Canonical Chains — отчет о перенаправлении и канонических цепочках. Здесь отображаются цепочки перенаправлений и канонических символов, показывается количество переходов по пути и идентифицируется источник, а также цикличность (если есть).

- Non-Indexable Canonicals — здесь можно получить выгрузку, в которой освещаются ошибки и проблемы с canonical. В частности, этот отчет покажет любые канонические файлы, которые не отдают корректного ответа сервера — заблокированы файлом robots.txt, с перенаправлением 3хх, ошибкой 4хх или 5хх (вообще все что угодно, кроме ответа «ОК» 200).

- Pagination — ошибки и проблемы с атрибутами rel=”next” и rel=”prev”, которые используются для обозначения содержимого, разбитого на пагинацию.

- Hreflang — проблемы с атрибутами hreflang (некорректный ответ сервера, страницы, на которые нет гиперссылок, разные коды языка на одной странице и т.д.).

- Insecure Content — показаны любые защищенные (HTTPS) URL-адреса, на которых есть небезопасные элементы, такие как внутренние ссылки HTTP, изображения, JS, CSS, SWF или внешние изображения в CDN, профили социальных сетей и т. д.

- SERP Summary — этот отчет позволяет быстро экспортировать URL-адреса, заголовки страниц и мета-описания с соответствующими длинами символов и шириной в пикселях.

- Orphan Pages — список потерянных страниц, собранных из Google Analytics API, Google Search Console (Search Analytics API) и XML Sitemap, которые не были сопоставлены с URL-адресами, обнаруженными во время парсинга.

- Structured Data — отчет содержит данные об ошибках валидации микроразметки страниц.

Sitemaps

С помощью этого пункта можно сгенерировать XML-карту сайта (страницы и картинки).

Все просто — выбираем что будем генерировать. В появившемся окне при необходимости выбираем нужные параметры и создаем карту сайта, которую потом заливаем в корневой каталог сайта.

Рассмотрим подробнее параметры, которые нам предлагают выбрать при генерации карты сайта.

Вкладка Pages — выбираем какие типы страниц включить в карту сайта.

- Noindex Pages — страницы, закрытые от индексации.

- Canonicalised — каноникализированные (опять это страшное слово!) страницы . Другими словами, динамика, у которой есть rel=”canonical”.

- Paginated URLs — страница пагинации.

- PDFs — PDF-документы.

- No response — страницы с кодом ответа сервера 0 (не отвечает).

- Blocked by robots.txt — страницы закрытые от индекса в robots.txt.

- 2xx — страницы с кодом 2хх (они будут в карте в любом случае).

- 3хх — страницы с кодом ответа 3хх (редиректы).

- 4хх — страницы с кодом ответа 4хх (битые ссылки на несуществующие страницы).

- 5хх — страницы с кодом ответа 5хх (проблема сервера при загрузке).

Вкладка Last Modified — выставляем дату последнего обновления карты.

- nclude <lastmod> tag — использовать в sitemap тег <lastmod> (дата последнего обновления карты).

- Use server report — использовать ответ сервера при создании карты, либо проставить дату вручную.

Вкладка Priority — выставляем приоритет ссылки в зависимости от глубины залегания страницы.

- Include <priority> tag — добавляет в карту сайта тег <priority>, показывающий приоритет страницы.

- Crawl Depth 0-5+ — в зависимости от глубины залегания страницы, можно проставить ее приоритет сканирования для поискового робота.

Вкладка Change Frequency — выставляем вероятную частоту обновления страниц.

- Include <changefreq> tag — использовать тег <changefreq> в карте сайта. Показывает частоту обновления страницы.

- Calculate from Last Modified header — рассчитать тег по последнему измененному заголовку.

- Use crawl depth settings — проставить тег в зависимости от глубины страницы.

Вкладка Images — добавляем картинки в карту сайта.

- Include Images — выводить в общей карте сайта картинки.

- Include Noindex Images — добавить картинки, закрытые от индекса.

- Include only relevant Images with up to … inlinks — добавить только картинки с заданным числом входящих ссылок.

- Regex list of CDNs hosting images to be included — честно, так и не понял что это такое… возможно настройка выгрузки в карту сайта картинок из хостинга (т.е. можно вбить списком несколько хостов и оттуда подтянуть картинки), но это всего лишь мои предположения.

Вкладка Hreflang — использовать в sitemap атрибут <hreflang> (или не использовать).

Visualisations

Это выбор интерактивной визуализации структуры сайта в программе. Можно получить отображение дерева сканирования и дерева каталогов. Основная фишка в том, что открываются эти карты и диаграммы во встроенном браузере программы, что позволяет эффективнее с ними работать (настраивать выведение, масштабировать, перескакивать к нужным урлам через поиск и т.д.).

Crawl Tree Graph — визуализация сканирования. По факту после завершения краулинга показывает текущую структуру сайта на основании анализа.

Directory Tree Graph — показывает ВСЕ каталоги после сканирования. Т.е. отличие от Crawl Tree Graph в том, что в этом отчете показываются, например, папки, закрытые от индекса.

Назначение Crawl Tree Graph и Directory Tree Graph в основном заключается в упрощении анализа структуры текущего сайта, можно глазами пробежаться по всем папкам, зацепиться за косяки (т.к. они выделены цветом). При наведении на папку, показывается ее данные (url, title, h1, h2 и т.д.).

Force Directed Crawl-Diagram — по сути то же самое, что и Crawl Tree Graph, только оформленное по-другому + показывает сканирование сайта относительно главной страницы (ну или стартовой). Кому-то покажется нагляднее, хотя по мне, выглядит гораздо сложнее для восприятия.

Force Directed Tree-Diagram — аналогично, другой тип визуализации дерева каталогов сайта.

Inlink Anchor Text Word Cloud — визуализация анкоров (ссылочного текста) внутренней ссылки. Анализирует каждую страницу по-отдельности. Помогает понять какими анкорами обозначена страница, как их много, насколько разнообразны и т.д.

Р- Разнообразие

Body Text Word Cloud — визуализация плотности отдельных слов на странице. По сути выглядит так же, как и Inlink Anchor Text Word Cloud, так что отдельный скрин делать смысла особого нет — обычное облако слов, по размеру можно определить какое слово встречается чаще, по общему числу посмотреть разнообразие слов на странице и т.д.

Каждая визуализация имеет массу настроек вывода данных, маркировки — про них я писать не буду, если станет интересно, сами поиграетесь, ок? Там ничего сложного.

Crawl Analysis

Большинство параметров сайта вычисляется пауком в ходе сбора статистики, однако некоторые данные (Link Score, некоторые фильтры и прочее) нуждаются в дополнительном анализе, чтобы попасть в финальный отчет. Данные, которые нуждаются в Crawl Analysis, помечены соответствующим образом в правом меню навигации.

Crawl Analysis запускается после основного парсинга. Перед запуском дополнительного анализа, можно настроить его (какие данные выводить в отчет).

- Link Score — присвоение оценок всем внутренним ссылкам сайта.

- Pagination — показывает петлевые пагинации, а также страницы, которые обнаружены только через атрибуты rel=”next”/”prev”.

- Hreflang — урлы hreflang без гиперссылки, битые ссылки.

- AMP — страницы без тегов “html amp”, теги не с 200 кодом ответа.

- Sitemaps — неиндексируемые страницы в карте сайта, урлы в нескольких картах сайта, потерянные страницы (например, есть в Google Analytics, есть в sitemap, не обнаружено при парсинге), страницы, которых нет в карте сайта, страницы в карте сайта.

- Analytics — потерянные страницы (есть в аналитике, нет в парсинге).

- Search Console — потерянные страницы (есть в вебмастере, нет в парсинге).

License

Исходя из названия, логично предположить, что этот пункт меню отвечает за разного рода манипуляции с активацией продукта…иии так оно и есть!

Buy a License — купить лицензию. При клике переход на соответствующую страницу официалов https://www.screamingfrog.co.uk/seo-spider/licence/. Стоимость ключа для одного ПК — 149 фунтов стерлинга. Есть пакеты для нескольких ПК, там, как обычно, идут скидки за опт.

Enter License — ввести логин и ключ лицензии, чтобы активировать полный функционал парсера.

Заметили, да? Лицензия покупается на год, не бессрочная

Help

Помощь юзеру — гайды, FAQ, связь с техподдержкой, в общем все, что связано с работой программы, ее багами и их решением.

- User Guide — мануал по работе с программой. Собственно, его я использовал, как один из источников, для написания этой статьи. При желании, можете ознакомиться, если я что-то непонятно рассказал или не донес. Еще раз оставлю ссылку https://www.screamingfrog.co.uk/seo-spider/user-guide/.

- FAQ — часто задаваемые вопросы по работе с SF и ответы на них https://www.screamingfrog.co.uk/seo-spider/faq/.

- Support — обратная связь с техподдержкой https://www.screamingfrog.co.uk/seo-spider/support/. Если программа ведет себя некрасиво (например, не принимает ключ лицензии), можно пожаловаться куда надо и все починят.

- Feedback — обратная связь. Та же самая страница, что и в Support. Т.е. можно не только жаловаться, но и вносить предложения по работе программы, предлагать партнерку, сказать банальное “спасибо” за такой крутой сервис (думаю ребятам будет приятно).

- Check for Updates и Auto Check for Updates — проверка на наличие обновлений программы. Screaming Frog нерегулярно, но довольно часто дорабатывается, поэтому есть смысл периодически проверять апдейты. Но лучше поставить галочку на Auto Check for Updates и программа сама будет автоматически предлагать обновиться при выходе нового апа.

- Debug — отчет о текущем состоянии программы. Нужно, если вы словили какой-то баг и хотите о нем сообщить разработчику. Там еще дополнительно есть настройки дебага, но я думаю, нет смысла заострять на этом внимание.

- About — собственно, краткая информация о самой программе (копирайт, сервисы, которые использовались при разработке).

Итог

Screaming Frog — очень гибкая в плане настройке утилита, с помощью которой можно вытянуть массу данных для анализа, нужно только (только… ха-ха) правильно настроить парсинг. Я надеюсь, мой мануал поможет вам в этом, хотя и не все я рассмотрел как надо, есть пробелы, но основные функции должны быть понятны.

Теперь от себя — текста много, скринов много, потому, если вы начинающий SEO-специалист, рекомендую осваивать SF поэтапно, не хватайтесь за все сразу, ибо есть шанс упустить важные нюансы.

Ну вот и все, ребята, я отчаливаю за новым материалом для нашего крутого блога. Подписывайтесь, чтобы не пропустить интересные публикации от меня и моих коллег. Всем удачи, всем пока!

Владимир Еленский

Практикующий SEO-специалист MAXI.BY media. Опыт работы более 5-ти лет. Хороший человек и просто красавчик.

Инструкция по настройке Лягушки (Screaming Frog) для сканирования сайтов. Активируем и настраиваем программу для работы в ручном и из пред файла готовой конфигурации в пару кликов.

Делюсь одной из частей регламента для сотрудников, которая посвященна работе с программой Screamig Frog.

Всем привет. Меня зовут Толстенко Александр. Я частный специалист по продвижению сайтов в Яндекс/Google.

Работаю в сфере создания и продвижения сайтов с 2009 года (уже более 13 лет).

Кейсы продвижения и другие статьи, подтверждающие экспертизу, можно посмотреть на сайте marketing-digital.ru или в профиле на vc.ru.

Провожу в месяц 10 бесплатных консультации длительностью 10-15 минут. Если актуально, бронируйте место, контакты в конце.

Настраиваем параметры программы Screaming Frog SEO Spider

Запускам программу и сразу вводим ключь активации

Важно! Программа должна быть активированная, чтобы просканировать весь сайт, а не только первые 500 страниц.

Далее, переходим к одному из методов настройке самой программы.

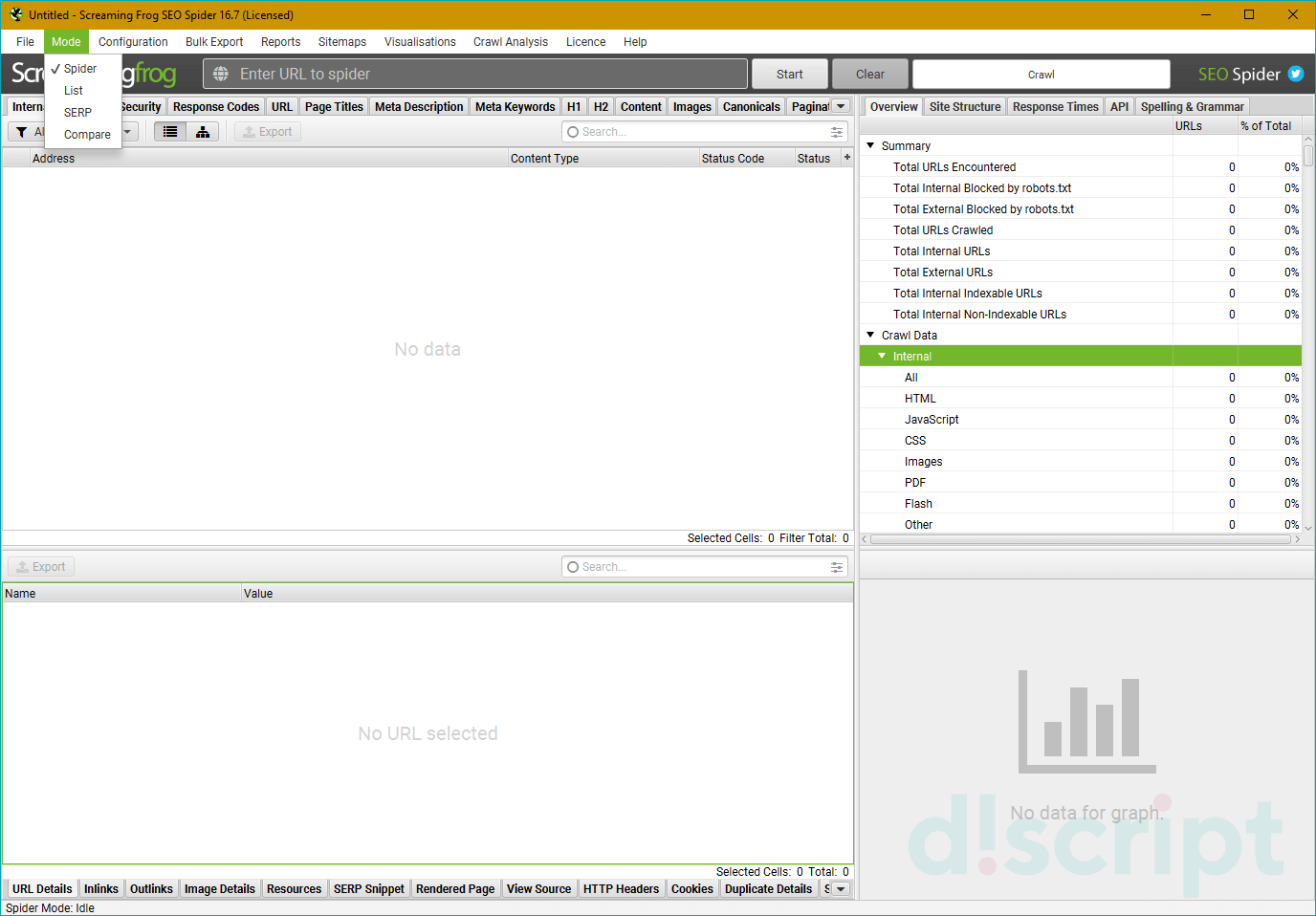

1. Загрузка настроек из готового файла конфигурации

Чтобы не разбираться в деталях настройки программы, загружаем скачанную конфигурацию на ПК и импортимуем настройки, которые подойдут в 90% случаев для сканирования практически всех сайтов.

- Готовая конфигурация для скачивания на ПК

Инструкция по импорту

1.1. Открываем меню: File → Configuration → load

1.2. Импортируем скаченный файл выше

1.3. Сохраняем загруженные настройки по умолчанию (будут применены при каждем открытии программы)

1.4. Проверяем, где будут храниться данные сканирования в ОЗУ или на жестком (System → Storage Mode) (могло снести при импорте)

1.5. Проверить сколько у вас установилось оперативной памяти для сканирования (могло снести при импорте)

Разработчики заявляют, что для хранения базы данных 4 ГБ ОЗУ позволят вам сканировать 2-3 миллиона URL-адресов, 8 ГБ ОЗУ позволят сканировать до 5 миллионов URL-адресов и 16 ГБ для 10 миллионов. Но, все это — приблизительные значения, так как зависит от типа сайта.

Рекомендуемое значение программой, будет указано в скобках (пример на скрние ниже в скобках: 14GB maximum allowed). Задать самостоятельно можно будет в окошке (у себя указал 10 GB)

Я отдаю ~60% от общего объема, чтобы не зависал компьютер. Пример на скрине. После указанных значений, нажимаем ОК.

1.3. Сохраняем загруженные настройки по умолчанию (будут применены при каждем открытии программы)

1.5. Перезагружаем программу, запускаем парсинг нужного сайта.

💡 Проверка задачи (самопроверка)

- Скачали файл конфигурации программы и импортировали его

- Проверили на всякий случай п. 1.4 и 1.5., если импорт снес, установлии свои значения

- Сохранили импортированные настройки, чтобы каждый раз не настраивать

- Перезагрузили программу, запустили парсинг нужного сайта

2) Ручная настройка (если нужно настроить под себя)

2.1. Запускам программу и открываем настройки: Configuration

2.2. Выбираем где хранить данные в ОЗУ или на жестком (System → Storage Mode)

2.3. Выбираем место, где будут храниться данные сканирования

Выбрать:

1) Database Store

2) Указать путь, где будут на жестком диске храниться данные парсинга (при желании)

3) Нажать кнопку: Ок, для сохранения изменений

2.4. Увеличиваем оперативную память для сканирования, чтобы не тупила программа

В зависимости от объема оперативной памяти на вашем компьтере (у меня 16 GB), вы можете задать значение самостоятельно.Чем больше объем, тем меньше будет тупить программа.Рекомендуемое значение программой, будет указано в скобках (пример на скрние ниже в скобках: 14GB maximum allowed).Задать самостоятельно можно будет в окошке (у себя указал 10 GB)

Я отдаю ~60% от общего объема, чтобы не зависал компьютер. Пример как у меня на скрине.После указанных значений, нажимаем ОК.

2.5. Сохраняем сделанные настройки конфигураци, чтобы открывались по умолчанию

2.6. Перезагружаем программу, она готова к работе

Важно! Если у вас очень большой проект (больше полу миллиона страниц), можно отключить ненужные параметры для сканирования. Пример настроек на скринах ниже. Поигравшись с настройками самостояльно, можно просканировать весь сайт.

💡 Проверка задачи (самопроверка)

- Программа настроена для сканирования сайтов

- Сохранили настройки, чтобы каждый раз не настраивать программу

- Перезагрузили программу, запустили парсинг нужного сайта

✌ Нужна консультация?

👉 Пишите в личные сообщения сюда:

Основные настройки сканирования сайта

Для большинства специалистов общий аудит сайта – непростая задача, однако с таким инструментом, как Screaming Frog SEO Spider (СЕО Паук), она может стать значительно более простой для профессионалов и даже для новичков. Удобный интерфейс Screaming Frog позволяет работать легко и быстро: с его помощью можно проверить позиции сайта, просканировать все страницы, найти внутренние ссылки и проблемы с контентом. Однако многообразие вариантов конфигурации, сложность в настройке и функциональности может усложнить знакомство с программой.

Инструкция ниже призвана продемонстрировать способы использования Screaming Frog как для аудита сайтов, так и других задач необходимых для продвижения сайта.

Важно! Скачивать лучше последнюю версию программы, регулярно обновляя ее. Данный гайд рассчитан на версию 16.7. Если у вас более старая версия или, наоборот, новая, вы можете столкнуться с неточностями в описании или другим видом интерфейса программы.

Настройки парсера

Перечень базовых настроек перед стартом работ

Memory

Здесь указываем предел оперативной памяти для парсинга. Опираемся на параметры своего ПК: учтите, что при запуске краулера этот объем RAM будет полностью зарезервирован и доступен только ему. Слишком маленький объем буфера может привести к зависанию паука при сканировании очень больших сайтов.

Storage

В данном разделе указывается, куда будут сохраняться отчеты – в папку «Программы» либо по указанному пути (по умолчанию в /User).

Proxy

Указывается прокси, с помощью которых будет происходить парсинг (используется, если выбран чекбокс).

Embedded Browser

Если чекбокс активен, парсер использует встроенный в программу браузер (на базе Chromium) для сканирования.

Режимы сканирования — Mode

Выбираем режимы сканирования сайта.

*Кстати, вы можете в любой момент приостановить сканирование, сохранить проект и закрыть программу, а при следующем запуске продолжить с того же места.

Spider – классический парсинг сайта по внутренним ссылкам, домен вводится в адресную строку.

List – парсим только предварительно собранный список URL-адресов. Указать последние можно разными способами:

- From a File – выгружаем URL-адреса из файла.

- Paste – выгружаем URL-адреса из буфера обмена.

- Enter Manually – вводим вручную в соответствующее поле.

- Download Sitemap – выгружаем их из карты сайта.

SERP Mode – режим не для сканирования: в нем можно загружать метаданные сайта, редактировать и тестировать.

Скорость парсинга

Еще одна основная настройка SEO Frog. При запуске парсинга внизу указывается средняя скорость и текущая. Если сайт не выдерживает большой нагрузки, то лучше в настройках задать другое значение.

Необходимо зайти в Configuration ➜ Speed и выставить более щадящие параметры.

Можно уменьшить кол-во потоков, а также максимальное количество обрабатываемых адресов в секунду.

Задаем параметры скорости анализа

Сканирование всего сайта

По умолчанию Screaming Frog сканирует лишь поддомен (или основной домен), на который вы заходите. Любой дополнительный поддомен, с которым сталкивается Spider, рассматривается как внешняя ссылка. Чтобы сканировать дополнительные поддомены, необходимо внести корректировки в меню конфигурации. Выбрав опцию «Crawl All Subdomains», вы можете быть уверены в том, что “паук” проанализирует любые ссылки, которые попадаются на поддоменах вашего сайта.

Заходим в настройки паука:

Переход к настройкам паука

Выставляем параметры:

Разрешение на анализ поддоменов

Чтобы ускорить сканирование, уберите чекбоксы на картинки, CSS, JavaScript, SWF или внешние ссылки.

Выключаем анализ медиафайлов

Парсинг только одного раздела

Если вы хотите ограничить сканирование конкретной папкой, просто введите URL.

Вставляем адрес сайта или раздела и нажимает “старт”

При этом убедитесь, что в настройках Configuration ➜ Spider ➜ Crawl убрана галочка с Crawl Outside of Start Folder

Запрещаем переход за рамки указанной папки

Если вы хотите начать сканирование с конкретной папки, а затем перейти к анализу оставшейся части поддомена, то перед тем, как начать работу с необходимым URL, перейдите сначала в раздел Spider под названием «Configuration» и выберите в нем опцию «Crawl Outside Of Start Folder».

Разрешаем переход за рамки указанной папки

Как сканировать список поддоменов или каталогов

Чтобы взять в работу или, напротив, исключить конкретный список поддоменов или подкаталогов, вы можете использовать RegEx, чтобы задать правила включения (Include settings — сканируем только заданные папки) или исключения (Exclude settings — сканируем все, кроме указанных папок) определенных элементов в меню «Configuration».

Добавляем не нужный раздел в список исключений

Как сканировать сайт, размещенный на старом сервере

В некоторых случаях старые серверы могут оказаться неспособны обрабатывать заданное количество URL-запросов в секунду. Чтобы изменить скорость сканирования, в меню «Configuration» откройте раздел «Speed» и во всплывающем окне выберите максимальное число потоков, которые должны быть задействованы одновременно. В этом меню также можно выбрать максимальное количество URL-адресов, запрашиваемых в секунду.

Если в результатах сканирования вы обнаружите большое количество ошибок сервера, перейдите во вкладку «Advanced» в меню конфигурации Паука и увеличите значение времени ожидания ответа (Response Timeout) и число новых попыток запросов (5xx Response Retries).

Настройка авторизации

Паук Screaming Frog заходит на страницу, запрашивающую идентификацию, а затем всплывает окно, в котором требуется ввести логин и пароль.

Переход на страницу авторизации

Для того, чтобы впредь обходиться без данной процедуры, в меню конфигурации заходим в раздел Configuration ➜ Authentication и снимаем флажок.

Отключение авторизации

Парсинг списка URL