:

OR

Lenovo has best practices in response to the Intel® Xeon® uncorrectable memory error handling on Gen 1 and Gen 2 or “H” SKUs of Gen 3 Xeon® Scalable processors. Learn More

> Системы хранения данных

> Storwize

> V3700 (Storwize)

Инструкция

V3700 (Storwize)

-

Главная Продукт -

Драйверы и Программное обеспечение -

Диагностика -

Инструкция -

Руководства и инструкции -

Гарантия и Обслуживание -

Статус ремонта -

Детали -

Свяжитесь с нами

:

OR

Lenovo has best practices in response to the Intel® Xeon® uncorrectable memory error handling on Gen 1 and Gen 2 or “H” SKUs of Gen 3 Xeon® Scalable processors. Learn More

Содержание

- 1 Начальная конфигурация

- 1.1 V3500 и V3700 Имя пользователя и пароль по умолчанию

- 2 Процесс настройки хранилища

16 июля Общее

В этом руководстве я рассмотрю все этапы настройки и установки IBM Storewize V3500 и V3700, в том числе начальную конфигурацию управления, вплоть до настройки массивов и т. Д.

Начальная конфигурация

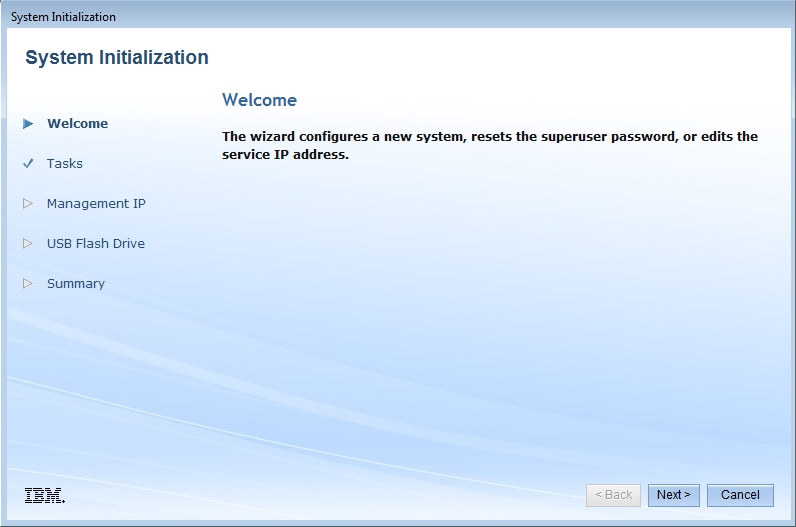

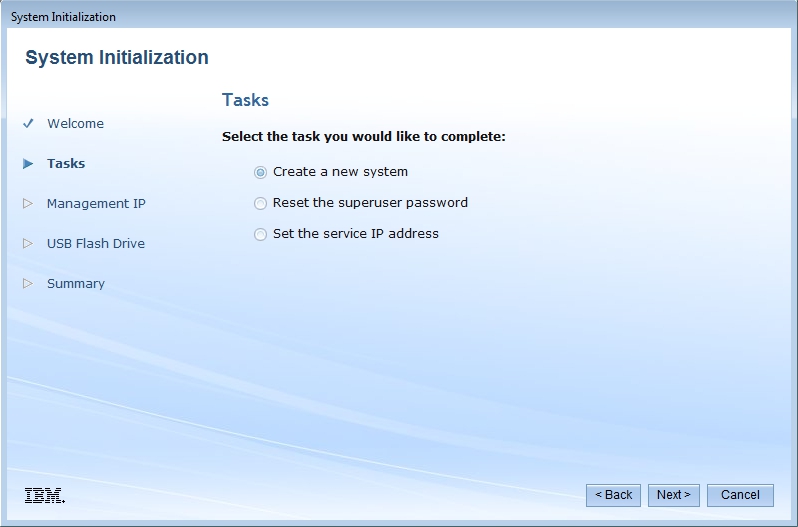

Первоначальная настройка V3500 / V3700 выполняется из системы Windows через USB, найдите USB-накопитель в упаковке и вставьте его в компьютер, затем запустите файл init.bat.

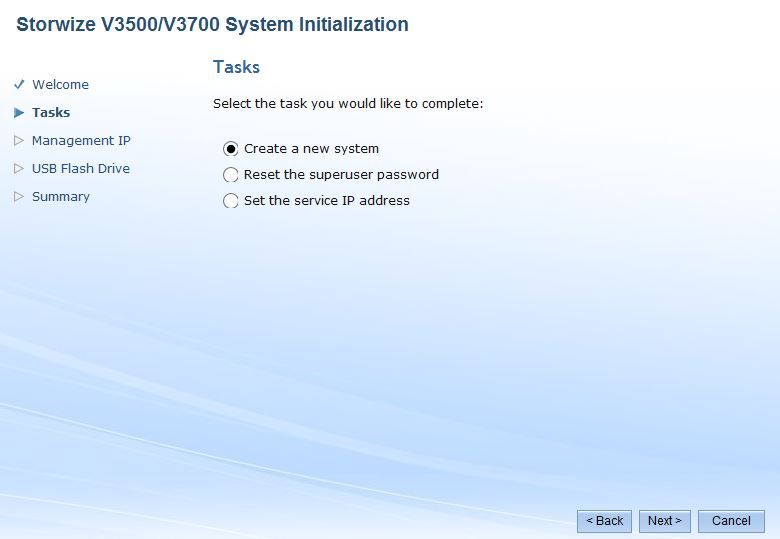

После запуска вы увидите экран приветствия, нажмите «Далее» и выберите «Создать новую систему».

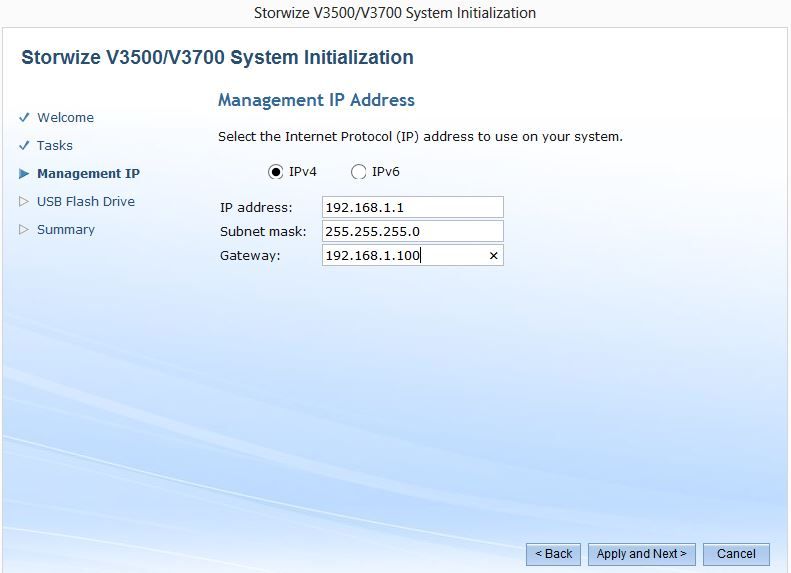

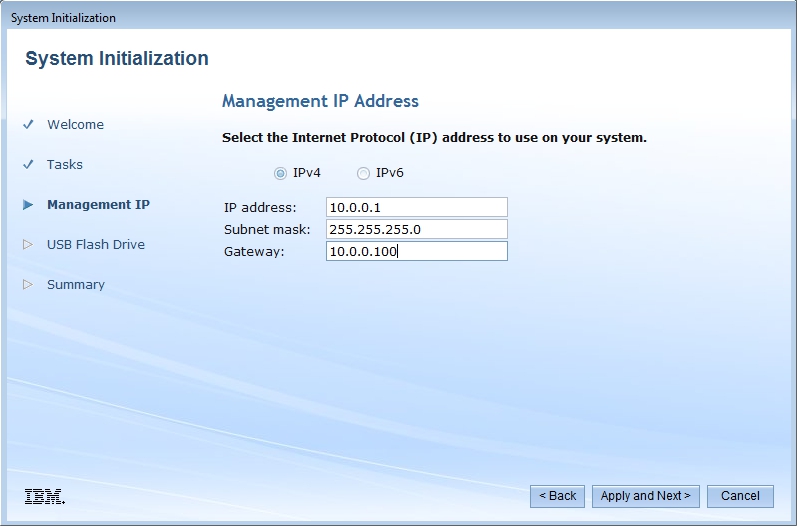

Первым шагом является назначение IP-адреса управления в вашей сети SAN, чтобы вы могли подключаться к веб-интерфейсу с клиентов в вашей сети для изменения параметров конфигурации. Увидеть ниже.

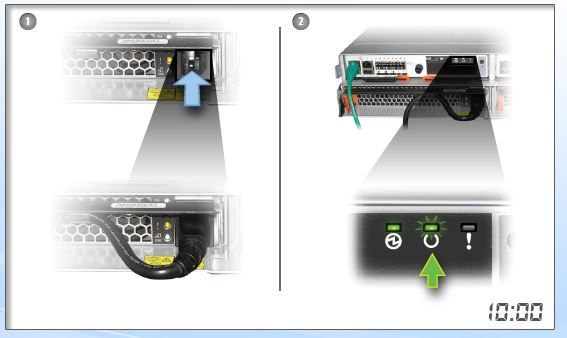

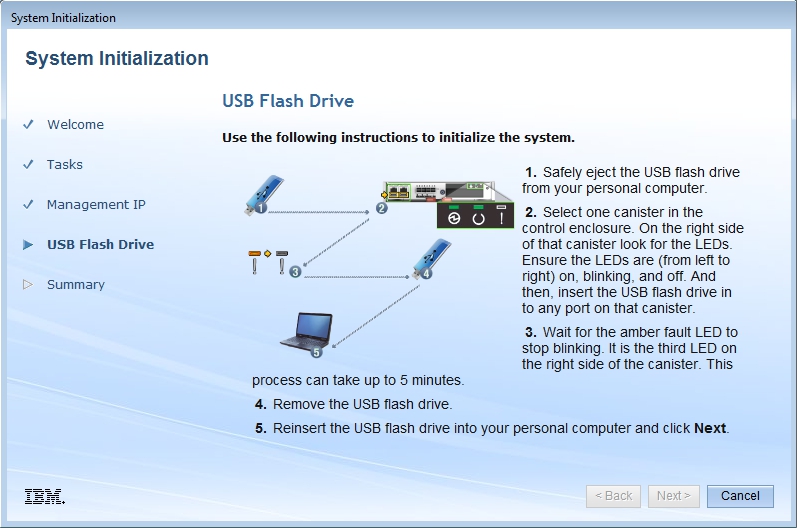

Нажмите «Применить» и затем, это сохранит конфигурацию на USB-накопитель Затем включите питание SAN, убедившись, что оба источника питания включены, дождитесь, пока индикатор состояния не начнет мигать, прежде чем продолжить.

Когда они мигают, извлеките USB-перо и вставьте его в левый USB-порт SAN, подождите еще 3-5 минут, пока светодиод неисправности не начнет мигать, затем перестанет мигать.

Это установит IP-адрес управления на контроллер, к которому вы подключаете USB-перо. Как только индикатор загорится, вы можете вынуть ручку и вставить обратно в компьютер, после чего вы увидите сводку успеха и будете перенаправлены на страницу входа.

V3500 и V3700 Имя пользователя и пароль по умолчанию

Это на большом листе бумаги А1 из коробки, но если вы забыли подробности.

Суперпользователь: passw0rd

Конфигурация SAN

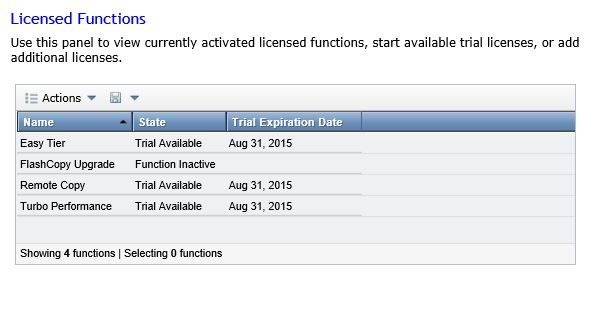

Есть много маленьких задач для базовой конфигурации, но я все равно их не решу. Первая задача — сменить пароль управления, мастер настройки попросит вас сделать это в первую очередь, сделайте это. Затем на следующем экране вас попросят предоставить лицензии, если вы приобрели какие-либо дополнительные функции.

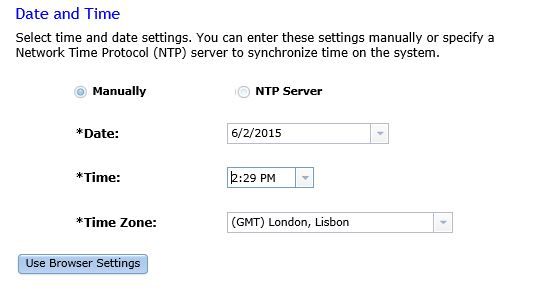

Затем установите правильное время в сети SAN.

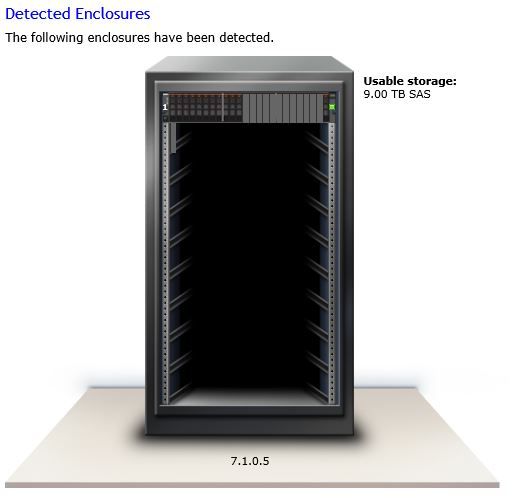

Затем вы получите хорошее графическое представление хранилища, которое было обнаружено в вашей SAN.

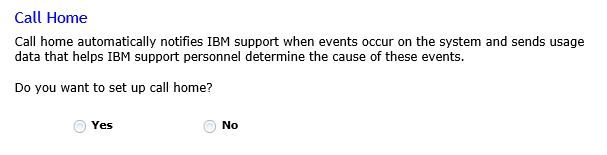

Если вы хотите использовать функцию вызова домой, которую IBM выключила, а затем настроить на следующем экране, я не буду.

Затем вы получаете возможность автоматически настраивать хранилище, в этом примере я не буду, поскольку я предпочел бы пойти, как это настроено ниже. По умолчанию он выберет наиболее подходящую конфигурацию диска и создаст один том.

Тогда вы увидите резюме, просто примите. Это SAN, настроенная для базового использования, теперь нам нужно настроить пулы и массивы хранения.

Процесс настройки хранилища

Это довольно простой графический интерфейс, поэтому я пройдусь по основным шагам в том порядке, в котором они нуждаются.

- Создайте пул хранения.

- Создать тома и выделить для пула.

- Если SAS добавляет тома к утвержденным хостам соответственно (ваши хосты должны быть подключены).

- Если ISCSI — настроить IP для инициаторов ISCSI.

- При необходимости настройте CHAP для аутентификации тома

Имейте в виду, что после создания томов они НЕ доступны мгновенно, в зависимости от их размера определяется, как долго они будут инициализированы. 9TB в моем примере заняло 4 часа.

Моя попытка знакомства с компанией Lenovo началась ещё в 2014 году, тогда мне очень хотелось взять какой-нибудь сервер из линейки компании для обзора. Лично мне эти серверы были крайне интересны ввиду того, что в нашей стране они (по крайней мере пока) встречаются крайне редко. Но тогда не сраслось. И так, осенью этого года мне предложили для обзора СХД Lenovo V3700 V2, но и тут всё вышло не так быстро, как мне бы того хотелось и в итоге массив ехал до меня около 2 месяцев. Конечно по сравнению с более известными и популярными интернет и печатными изданиями я нахожусь в более низком приоритете у вендора, так что массив приехал ко мне последнему, когда все уже кто хотел его потестировали и написали свои обзоры.

Большой обзор написал thg.ru, а очень приятный видео-обзор снял IXBT.com.

Передо мной встал вопрос — а что же буду писать я? Делать миллионный тест массива — не интересно, да и моя домашняя инфраструктура не готова к таким нагрузкам, т.к. моя тестовая песочница живёт всего-лишь на 4Gb SAN. По этому было принято решение больше рассказать о том, что это за массив, с чего всё начиналось и что он умеет.

Думаю я не открою большого серкрета, ведь многие это знают и так, компания Lenovo приобрела данную линейку массивов у компании IBM, как это произошло чуть ранее с серверным направлением. И это ни что иное, как обновлённый массив IBM Storwize V3700. Младшая модель этой линейки. У меня на тесте побывала её «прокачанная» версия XP. Массивы IBM Storwize трансформировались в линейку Lenovo Storage. Так что полное название массива — Lenovo Storage V3700 V2 XP. XP говорит о том, что это версия с более мощным контроллером, который позволяет расширять кэш до 16Gb.

Родоначальником этой линейки стал массив V7000 ещё в 2010-м году, так что эта платформа успела уже переболеть всеми детскими болезни, присущими новым продуктам.

Технические характеристики V3700 V2 XP

Форм-фактор СХД и полок расширения: 2U, 24 диска SFF (2,5″) или 12 дисков LFF (3,5″)

Максимальное количество дисков: 240 SFF или 120 LFF (9 полок расширения, не совместим с полками расширения первого поколения)

Максимальный объём дискового пространства: 960 ТБ

Интерфейс подключения дисков и полок расширения: SAS 3.0

Число контроллеров: 2

Режим работы контроллеров: ALUA

Отказоустойчивость:

- Защита содержимого кэш-памяти при аварийном отключении питания (аккумулятор)

- Зеркалирование содержимого кэш-памяти между контроллерами

Поддержка RAID: 0, 1, 5, 6, 10; распределённый RAID (DRAID) 5 и 6

Объём памяти (на каждый контроллер): 8 ГБ, поддерживает расширение до 16 ГБ

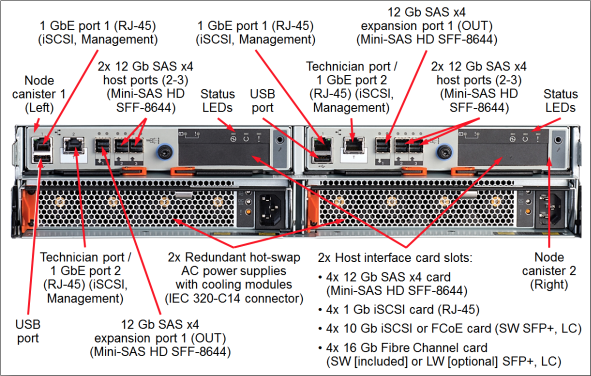

Стандартные порты для подключения хостов (на каждый контроллер):

- 2x 1 Гбит iSCSI (RJ-45)

- 2x SAS 3.0 (SFF-8644, mini-SAS HD x4)

Опциональные порты для подключения хостов (на каждый контроллер, в зависимости от установленной интерфейсной платы):

- 4x SAS 3.0 (SFF-8644, mini-SAS HD x4)

- 4x 1 Гбит iSCSI (RJ-45)

- 4x 10 Гбит iSCSI или FCoE (SFP+, SW)

- 4x 16 Гбит FC (SFP+, SW или LW)

Стандартный функционал:

- виртуализация собственного дискового пространства (дисковые пулы)

- тонкое выделение ресурсов (Thin Provisioning)

- односторонняя миграция данных

- снапшоты (FlashCopy, до 64-х)

Опциональный функционал:

- удалённая репликация (Remote Mirroring)

- многоуровневое хранение данных (Easy Tier)

- увеличение максимального количества снапшотов (FlashCopy, расширение до 2048)

И так, перейдём к осмотру самого массива и из чего он состоит.

Мозгом и сердцем СХД является её контроллер. Он содержит процессор, который занимается обработкой всех вычислений, память, батарея, порты и тд. Как видно в нашем случае — память расширена до 16Gb и состоит из двух модулей по 8Gb.

FC порты в виде PCI-E HBA, но эта карта может быть заменена на iSCSI 1/10Gb или SAS. К сожалению не знаю — поддерживается ли самостоятельная замена HBA или это лишь облегчает конфигурирование массива перед покупкой. Под контроллерами находятся два Блока питания, мощностью 800W.

Не буду описывать все порты, у Lenovo в документации это прекрасно проиллюстрировано.

После того, как мы разобрали, что и для чего у нас в этом массиве есть, можно переходить к программной его части.

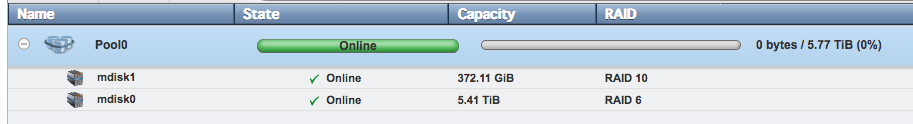

Собственно после настройки ip ардесов менеджмента и подключения массива к сети (О чём есть отличная инструкция в комплекте с массивом и сложностей на данном этапе возникнуть ни у кого не должно. Не сложнее чем подключить какой-нибудь домашний NAS) мы переходим к основному «слою», это mdisk`и (managed disk). Если объяснять по простому, то mdisk — это RAID группа, которые в дальнейшем объединяются в пулы и уже на них выделяются луны, которые презентуются хостам. Хостам не видны ни сами mdisk`и, ни пулы. mdisk`и могут быть организованы как из внутренних дисков массивов, так и из виртуализованных систем.

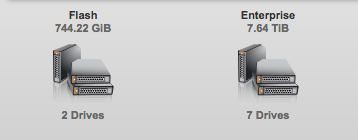

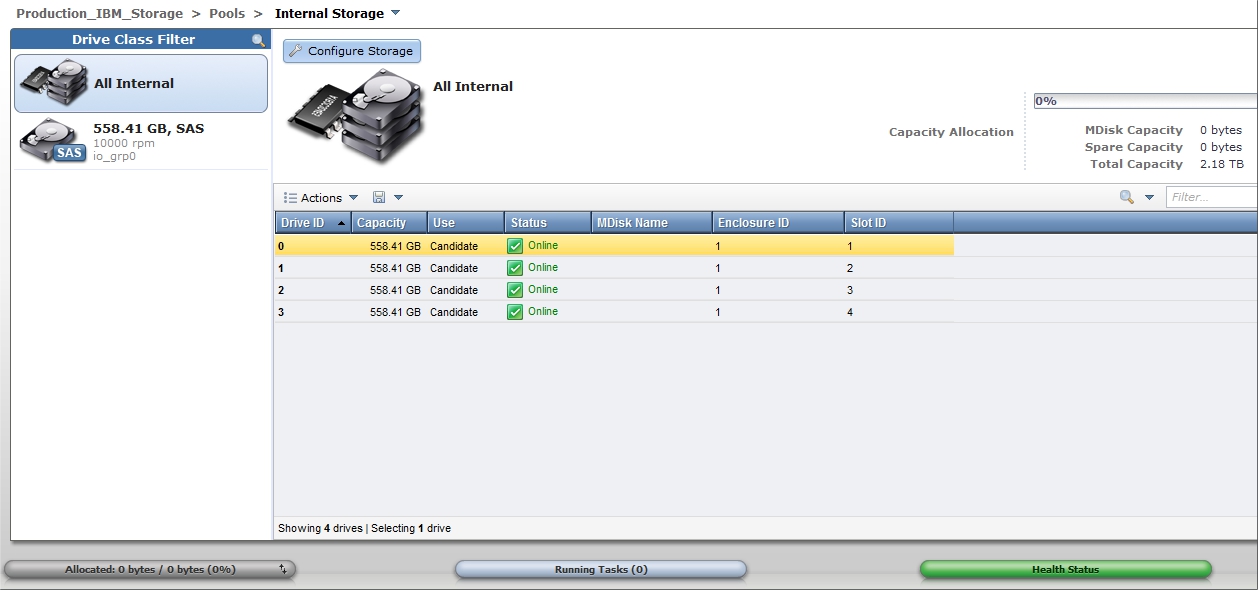

И так, у нас есть диски

Мы добавляем оба типа диска в пул. При такой конфигурации SSD + HDD, в рамках этого пула у нас будет работать тиринг. Для работы тиринга так же необходима и лицензия Easy Tier. Он работает следующим образом:

- Встроенный механизм I/O Monitor следит за нагрузкой на на диск и при появлении «горячих» областей ввиду большого кол-ва обращений к этим данным, записывает статистику.

- Data Placement Advisor основываясь на 24-часовой статистики, распознаёт уровень нагрузки и передаёт данные о ней Data Migration Planner.

- Data Migration Planner анализирует полученные данные и имеющиеся физические ресурсов хранения и передаёт информацию Data Migrator.

- Data Migrator подтверждает и планирует перенос того или иного блока данных на более высокий или низкий уровень хранения, после чего выполняет миграцию данных.

- Работа Easy Tier проходит в фоновом режиме, и мы не имеем возможности следить за её работой на самом массиве.

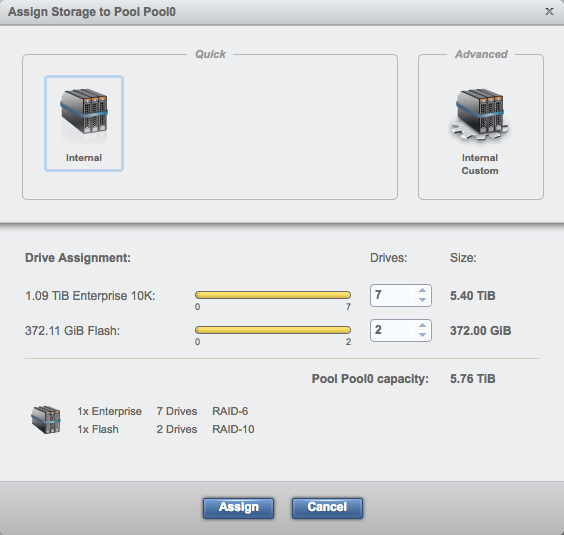

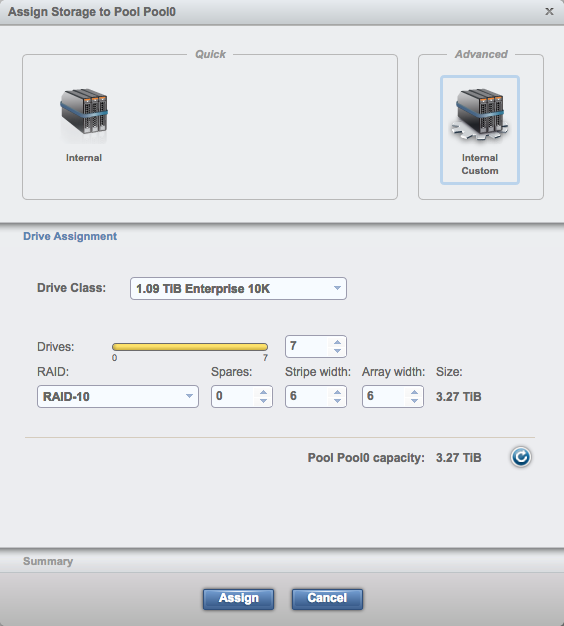

Мы можем собрать диски в пул как в автоматическом режиме, основываясь на рекомендациях массива

Так и сделать это полностью самостоятельно

Помимо классических RAID-1,5,6,10 поддерживаются так же Distributed RAID-5,6.

В итоге мы получаем пул, состояний из двух mdisk`ов, на котором в дальнейшем мы можем выделять ресурсы для наших нужд.

Чем мне всегда нравилась линейка Storwize, и собственно то, что не претерпело изменений у Lenovo — это простота данного массива. Если вы обладаете базовыми навыками и пониманием SAN и RAID — вы сможете сконфигурировать этот массив без особых сложностей. Бюджетные массивы других вендоров не дадут вам столь понятный и простой интерфейс. Но при этом не стоит забывать про CLI, который даёт массу возможностей как по настройке, так и мониторингу состояния.

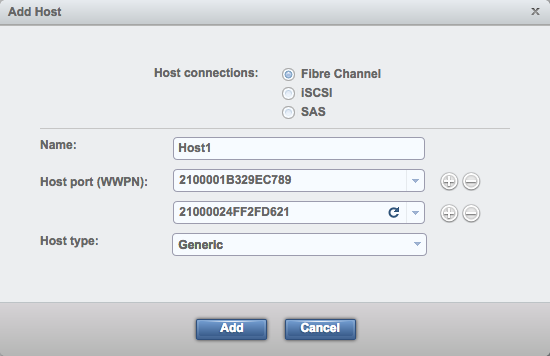

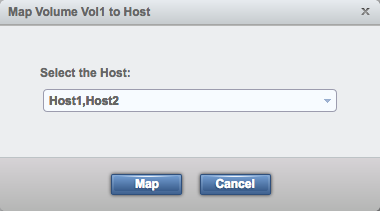

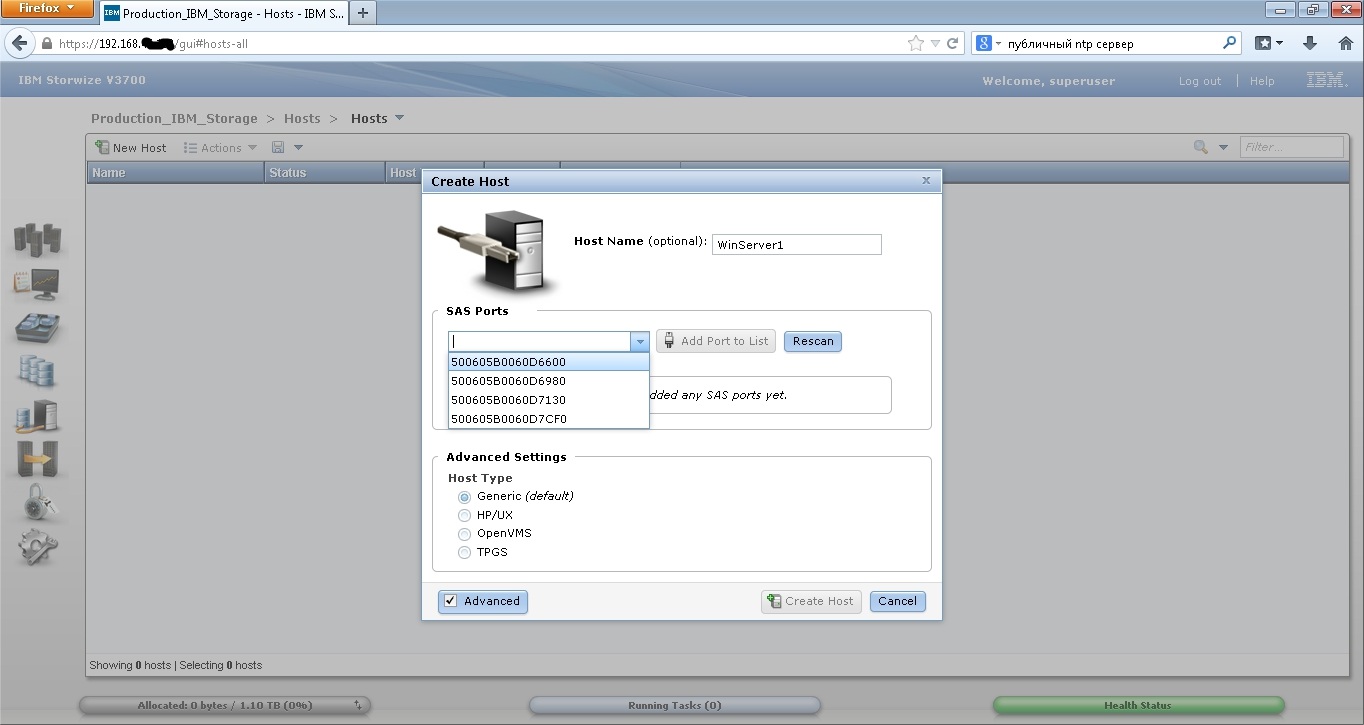

Но вернёмся к настройке. Теперь нам необходимо добавить наши серверы на массив, что бы им можно было презентовать созданные луны (предварительно нужно не забыть создать зонинг на san коммутаторах, в случае если у вас хосты подключаются не на прямую к СХД, об этом можно будет прочитать в 5-й части «Зонинг» моего цикла статей по Brocade SAN, которая скоро будет опубликована). Эта процедура так же очень проста, мы выбираем добавление хоста, выбираем wwn сервера (он их видит автоматически, хотя порой бывает что требуется перезагрузка хоста или переинициализация HBA сервера), указываем его имя и всё готово.

Так как у меня модификация массива XP — он поддерживает любой из типов подключения: FC, SAS, iSCSI. Я не буду затрагивать сильно тему того — что же лучше, FC или iSCSI. Конечно на данный момент времени iSCSI мало проигрывает по скорости, и при этом ещё даёт очень неплохую фору по стоимости оборудования.

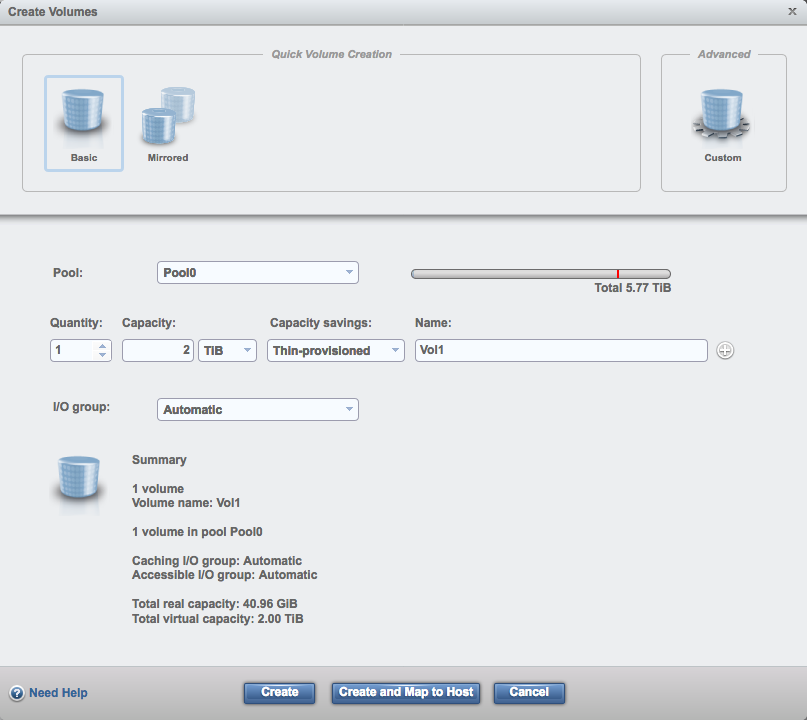

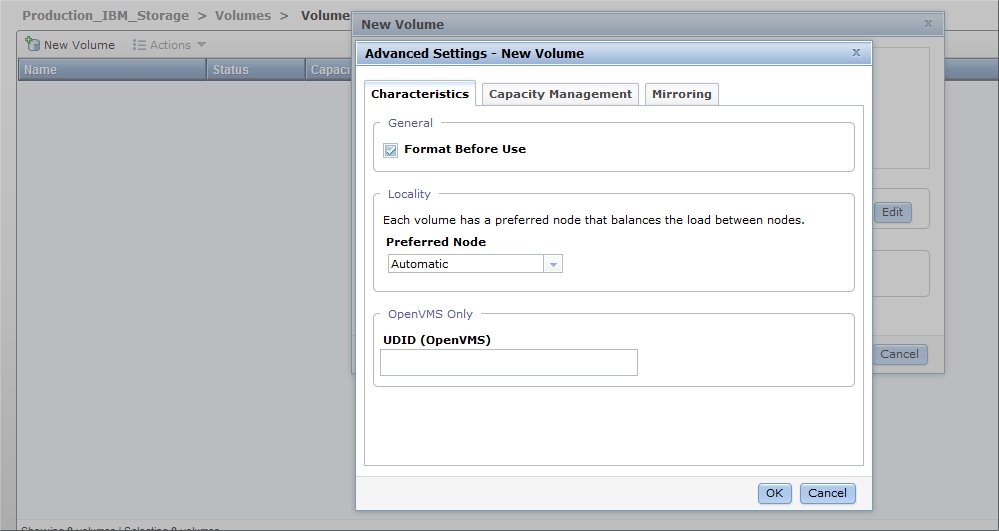

С созданием и презентацией лунов так же всё просто. Выбираем создание луна, выбираем обычный или зеркальный (но на мой взгляд — зеркальный при одном пуле дисков имеет не очень много логики), указываем количество, объём, толстый лун или тонкий, название, к какой i/o группе он относится.

После чего остаётся запустить процесс создания и отдать лун нашим серверам.

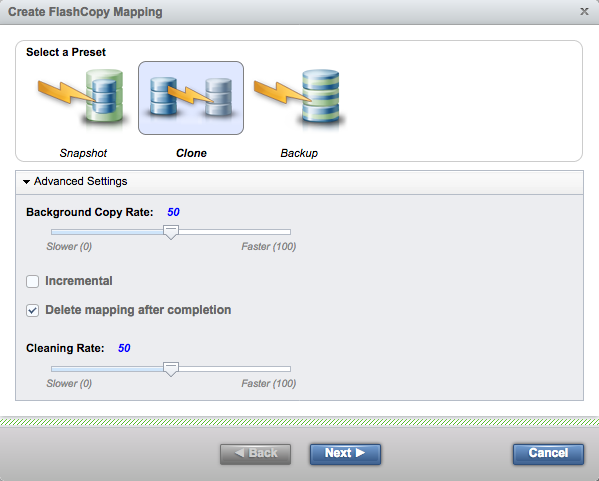

Всё это достаточно просто создаётся и настраивается, как я уже говорил, достаточно лишь понимать основы SAN. Теперь, когда у нас есть лун и мы отдали его нашим хостам, там возможно у нас уже есть какие то данные, с которыми мы можем работать на стороне массива, т.е. пришло врем рассмотреть поближе технологию FlashCopy. Эта фирменная технология позволяет вам создавать и управлять копиями ваших томов. По факту: Snapshot, Backup и Clone это просто несколько пресетов для работы системы FlashCopy.

- Snapshot — по сути это традиционный снапшот, то есть создается связь старого и нового тома, и все изменения пишутся уже на новый том.

- Clone — делает всё то же самое, что и Snapshot, но параллельно этому процессу идёт копирование «старых» данных со старого тома на новый. В итоге мы получаем полную копию тома на момент запуска клонирования + изменённые данные. При этом, после создания копии — связь между томами обрабывается и мы можем, к примеру, удалить старый том.

- Backup — и снова он делает всё то же самое что и предыдущий «пресет» Clone, но после окончания синхронизации связь не рвется, и целевой том всегда можно обновить изменёнными данными исходного тома.

Если открыть окно Create FlashCopy Mapping, то можно визуально увидеть что из себя представляют эти пресеты, для лучшего понимания.

Что касается мониторинга производительности, как и в большинстве СХД — только в реальном времени. Но мониторить вы можете лишь небольшое кол-во параметров. Это утилизация процессоров контроллеров, нагрузку на интерфейс, на луны и на mdisk`и. При чём в случае лунов и mdisk`ов — система показывает лишь их сумму. Вы не имеет возможности мониторить только отдельные части.

Но компания IBM предлагает для мониторинга массивов Storwize, а теперь и массивов Lenovo Storage V использовать IBM Tivoli Storage Productivity Center. Возможно для одного массива это будет слишком излишне, по этому за историю работы данной линейки массивов появилось большое кол-во сторонних приложений и систем для их мониторинга, к примеру, проект STOR2RRD.

Ну а что бы подробнее ознакомиться с возможностями Tivoli Storage Productivity Center, очень рекомендую вот этот вебинар.

В целом можно сказать что Lenovo Storage V3700 V2 XP, это достойное продолжение линейки Storwize. При чём именно расширенная — XP версия даёт большую производительность и гибкость конфигурации. Наверное для полного идеала, в качестве стартового массива ему не хватает файлового доступа, в дополнение к блочному. Если вы сталкивались с покупкой серверного оборудования, то скорее всего в курсе что на такие вещи как СХД — нет фиксированной цены. Есть list price, от которого вы получаете скидку, персональную для вашей компании, ввиду этого — говорить о стоимости массива просто не представляется возможным, т.к. скидка может варьироваться от 5 до 80%. Соответственно сложно сказать — оправдывает ли данный массив свою цену, или решения от конкурентов могу быть более выгодными. Тем более, что одним из основных показателей СХД — является именно производительность, которую сегодня мы не замеряли. В любом случае я рекомендую присмотреться к Lenovo V3700 V2 XP, это достойное продолжение линейки Storwize. Так же очень надеюсь, что данный материал поможет новичкам разобраться в нём.

включаем хранилище в розетку.

ждем когда в 1й канистре загорит оранжевый глаз, около 10минут.

вставляем флешку в комп.

запускаем InitTool.bat

далее жмем далее..

на нужном шаге вынимаем флешку

пихаем флешку в эту канистру.. оранжевый глаз поморгает в течении 1 минуты, перестает выдергиваем флешку и пихаем в комп.

предложит залезть браузером

https://192.168.хх.хх/service/

так значит работает.

——————————————— если нужно сбросить пароль

запускаем InitTool.bat меняем пароль.

вынимаем флешку,пихаем флешку в эту канистру.. оранжевый глаз поморгает в течении 30сек, перестает выдергиваем флешку и пихаем в комп.

получаем пароль по умолчанию -> passw0rd

——————————————— подготовка

https://192.168.хх.хх/service/

обновляем прошивку для каждой канистры — заново установить машинный код.

входим в управлене системой -даем ип.

ждем перезапуска

просит поменять пароль — меняем

далее жмем далее.. выбирая по пути что надо

в итоге сделает 3 рейда 5 уровня. но оно нам не надо.

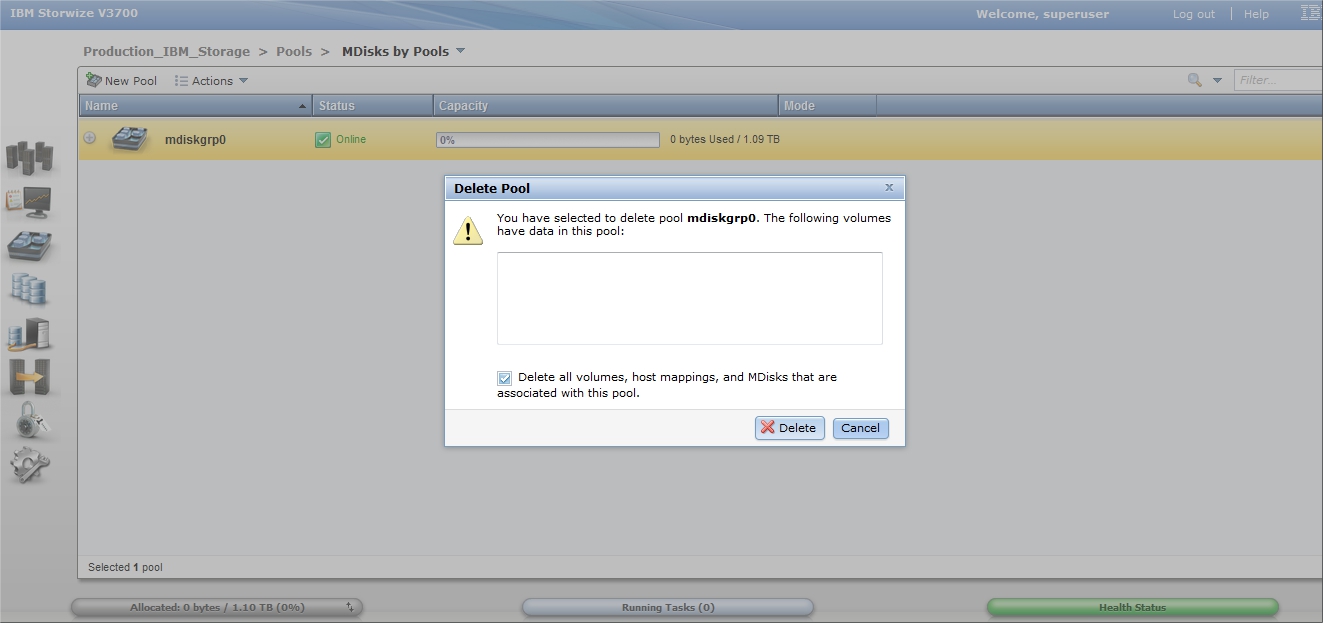

удаляем их

пулы-MDisk по пулам — удаляем там рейды

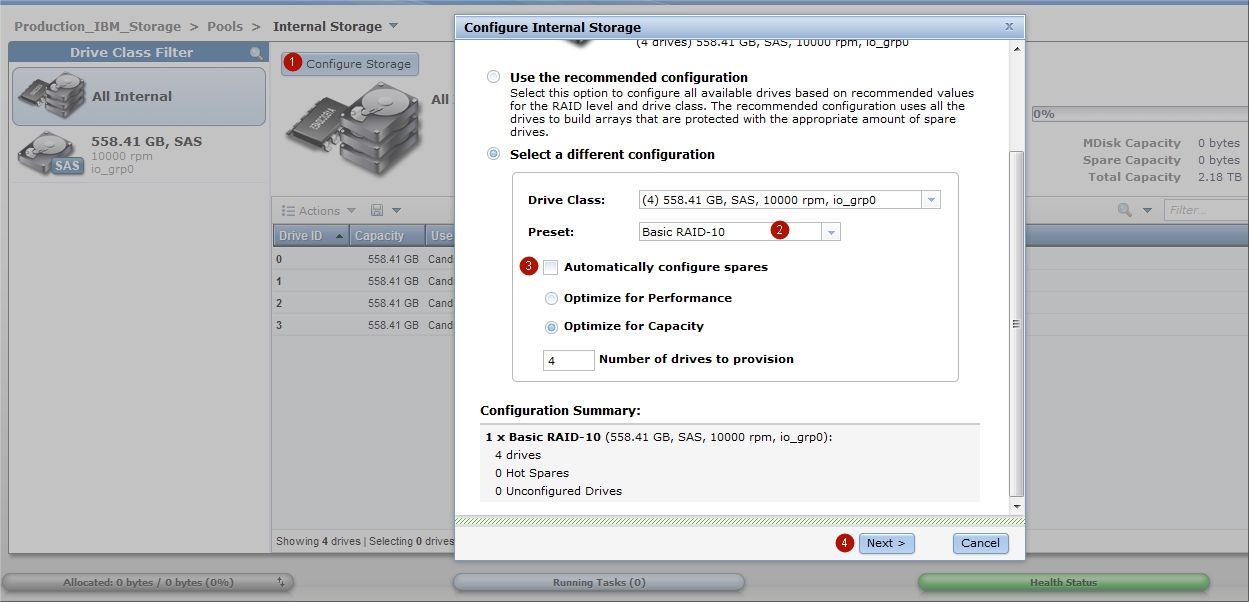

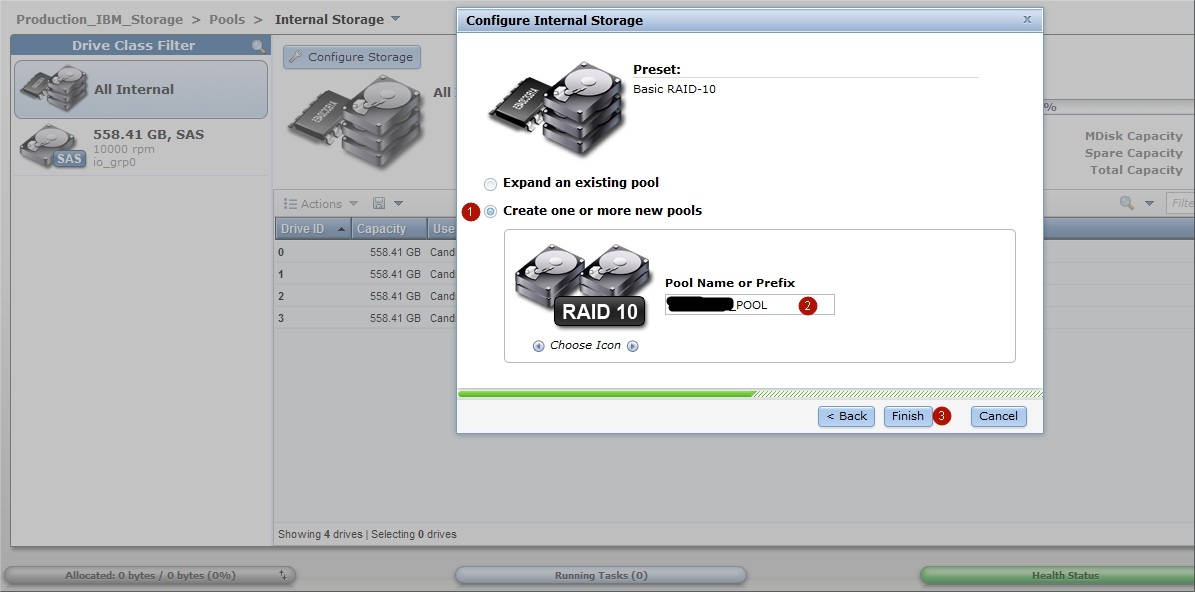

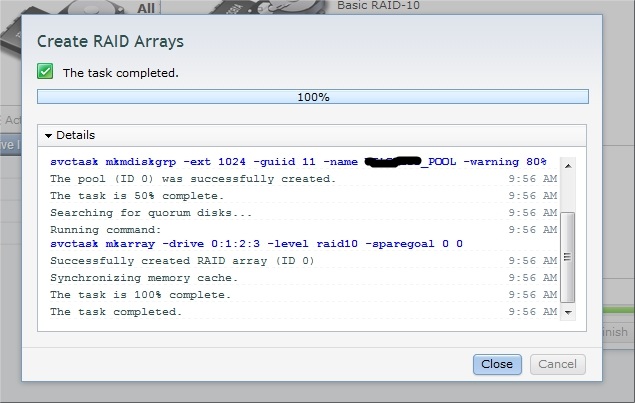

——————————————— построение RAID10

пулы-внутренняя память — настроить память делаем рейд, создаем пул.

внимательно смотрим на задачи и ждем пока сварится рейд.

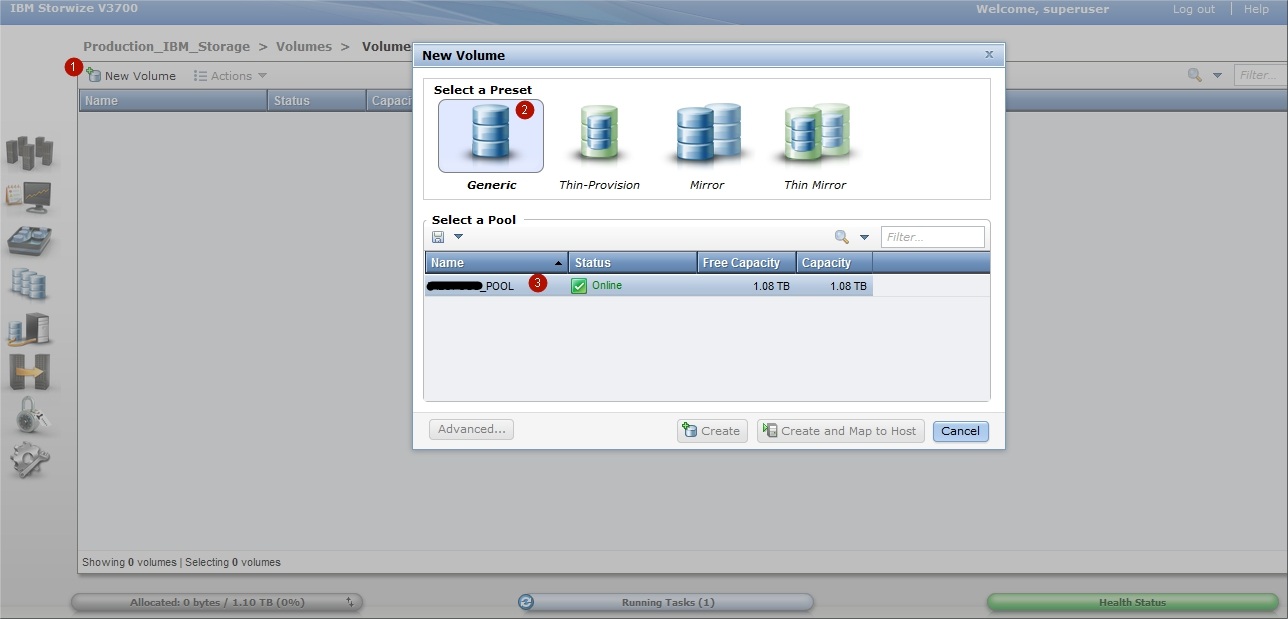

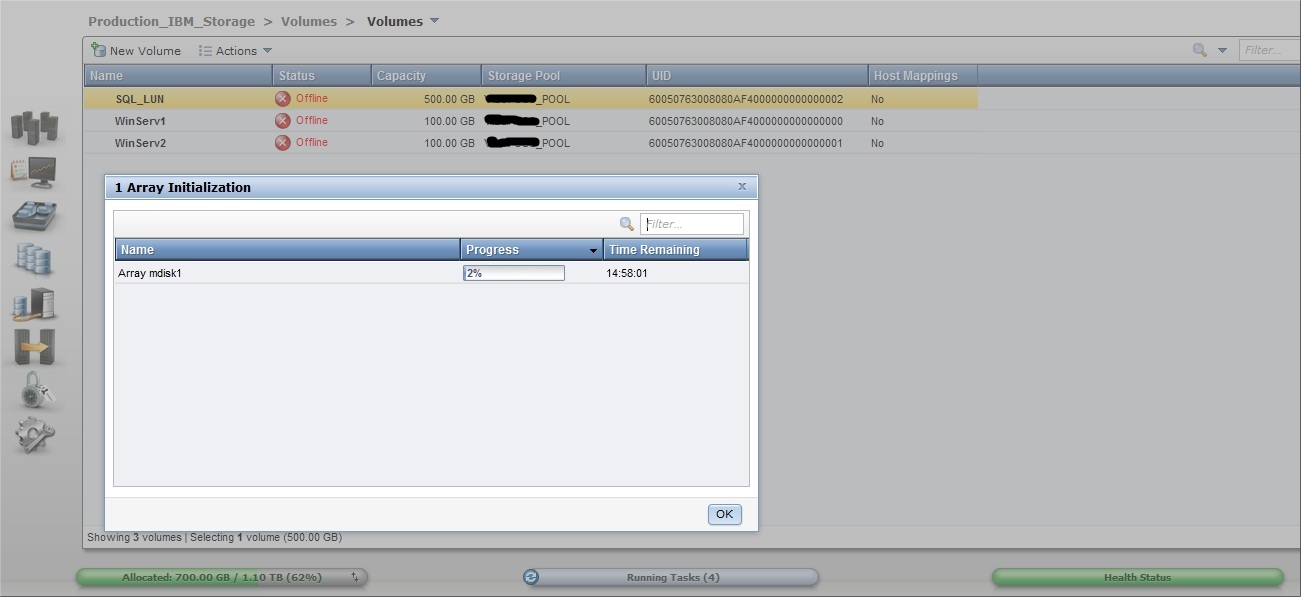

создаем том.

———————————————

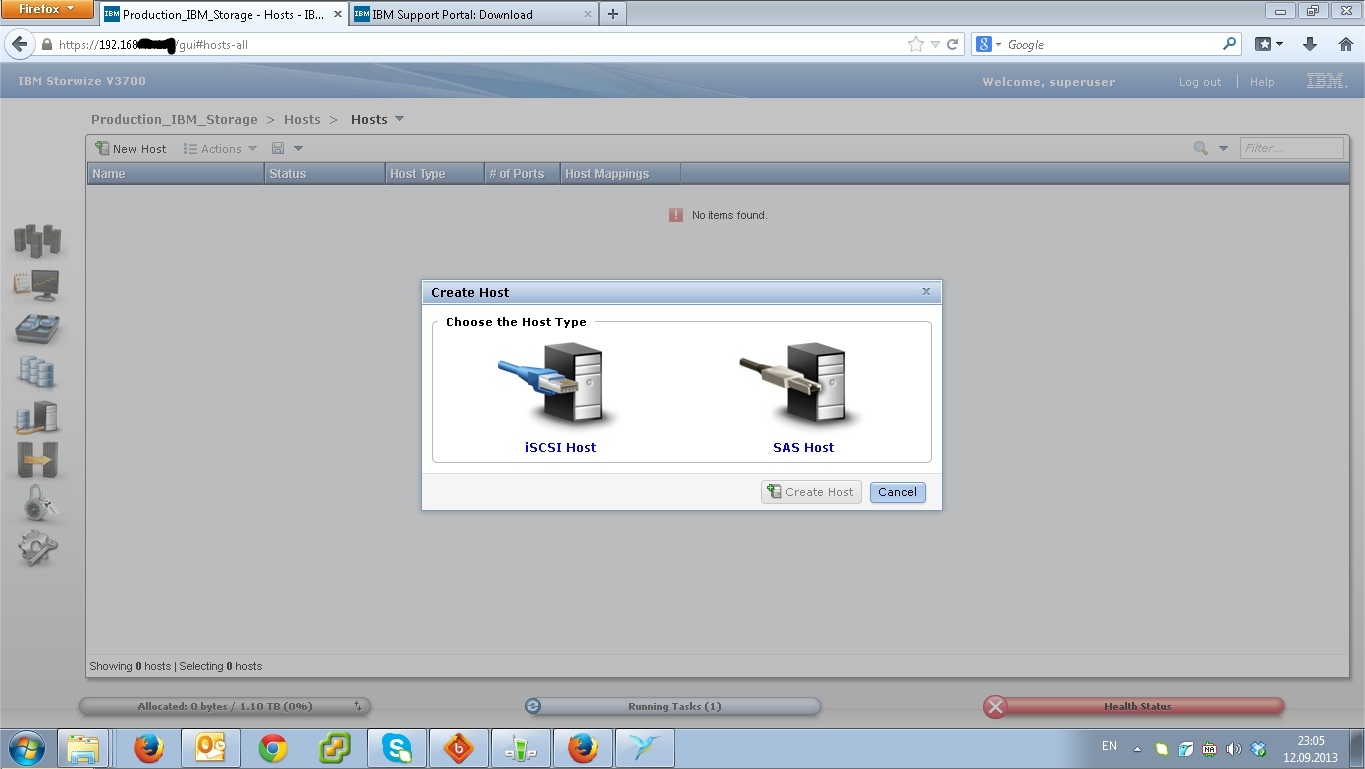

делаем хост Fibre Channel.

выбираем 4 порта — Порты Fibre Channel

в действиях делаем изменить связи хоста.

——————- по умолчанию

1я канистра 192.168.70.121

2я канистра 192.168.70.122

Хочется показать, насколько просто можно настроить систему хранения данных от IBM. Отдельное спасибо за предоставленные скриншоты нужно сказать Дмитрию К. из Оренбурга, который не поленился и запечатлел процесс инсталляции.

Самая элементарная схема:

- СХД IBM Storwize v3700 в базовой комплектации с возможностью подключения серверов по iSCSI и SAS. Установлены 4 диска по 600Gb

- два сервера IBM 3650 m4, без локальных дисков, с двумя однопортовыми SAS HBA картами

- подключение крест на крест, отказоустойчивое — каждый HBA адаптер сервера соединен со своим контроллером системы хранения

Задача стоит следующая:

- Подключиться к СХД для управления

- Обновить прошивку, чтобы появилась поддержка SAS подключений

- Создать из дисков array, уровень RAID 10

- Так как у нас серверы без жестких дисков, создаем для каждого сервера отдельный LUN для установки операционной системы Windows server 2012

- Создаем один общий LUN, который будет доступен обоим серверам. Использоваться он будет для создания MS SQL 2012 кластера, точнее для хранения баз данных

- Задача не предполагает использование виртуализации

Приступаем к настройке

1

В состав поставки системы хранения есть специальная флешка, она используется для первоначального конфигурирования, а именно установка пароля администратора, сервисного IP адреса для подключения к веб интерфейсу. С флешки на компьютере запускаем утилиту InitTool.bat

2

Так как мы только что достали СХД из коробки, выбираем пункт Create a new system

3

Задаем IP адрес, по которому будем подключаться к системе хранения.

4

Процесс инициализации системы:

- Делаем безопасное извлечение устройства из компьютера, достаем флешку.

- Смотрим на один из контроллеров системы хранения. Нам нужно будет вставить флешку в один из разъемов по сетевыми интерфейсами управления. Но перед этим нужно убедиться, что с правой верхней стороны контроллера три световых индикатора подают верные семафорные сигналы, левый горит, средний мигает, правый выключен.

- После того, как флешка будет помещена в USB порт (любой). Начинает мигать правый значок (восклицательный). Необходимо дождаться пока он перестанет потухнет, после этого можно извлечь флешку и вернуть ее обратно в компьютер, чтобы закончить шаги мастера.

5

По умолчанию логин пароль для входа superuser — passw0rd (через ноль)

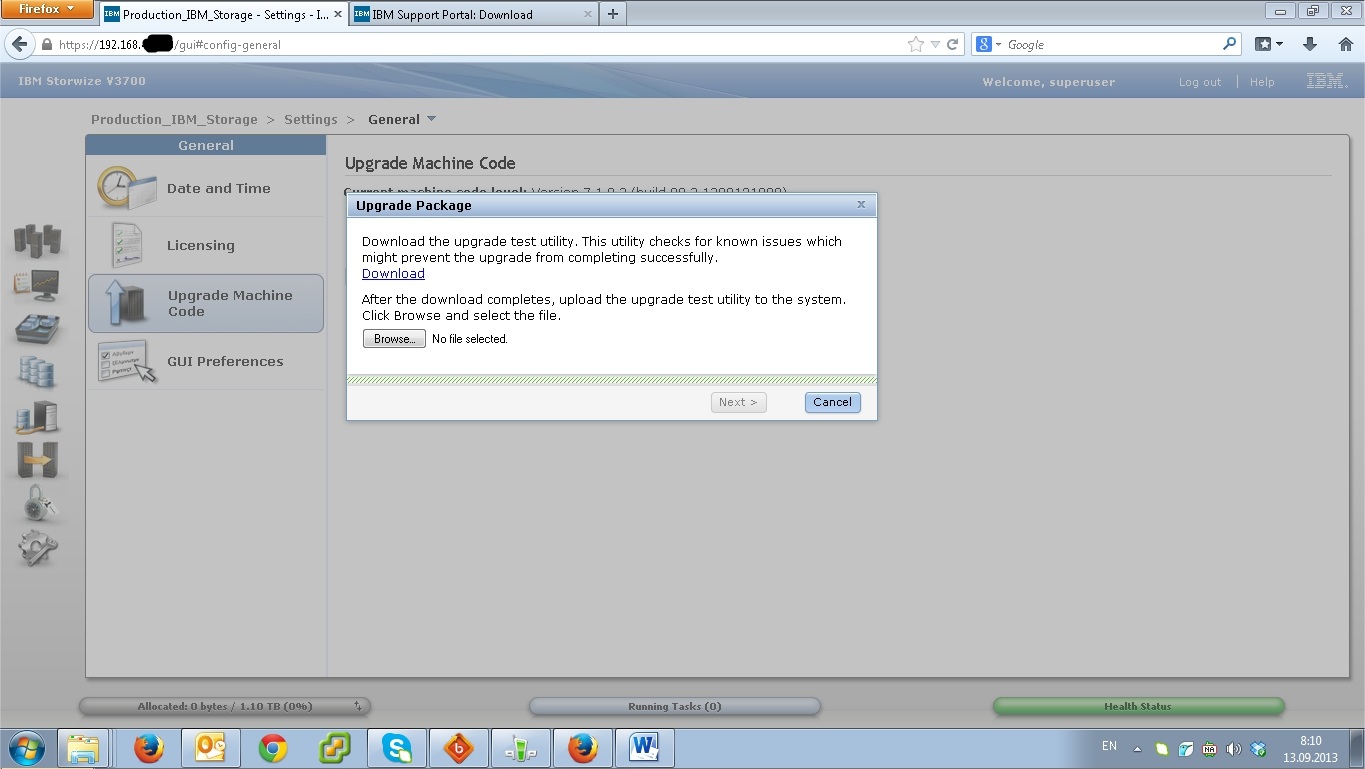

Теперь самое время обновить прошивку, для этого переходим в меню Settings -> General -> Upgrade Machine Code

Прошивка заранее скачана с официального сайта ibm.com. В нашем случае это Version 7.1.0.3 (build 80.3.1308121000). В ее составе есть Upgrade test utility, сначала загружаем на СХД ее, а затем саму прошивку.

6

Если бы дисков было больше, может быть имело бы смысл оставить подобную автоматическую настройку. В нашем случае лучше переразбить диски по-другому.

7

Удаляем автоматически созданный Pool

8

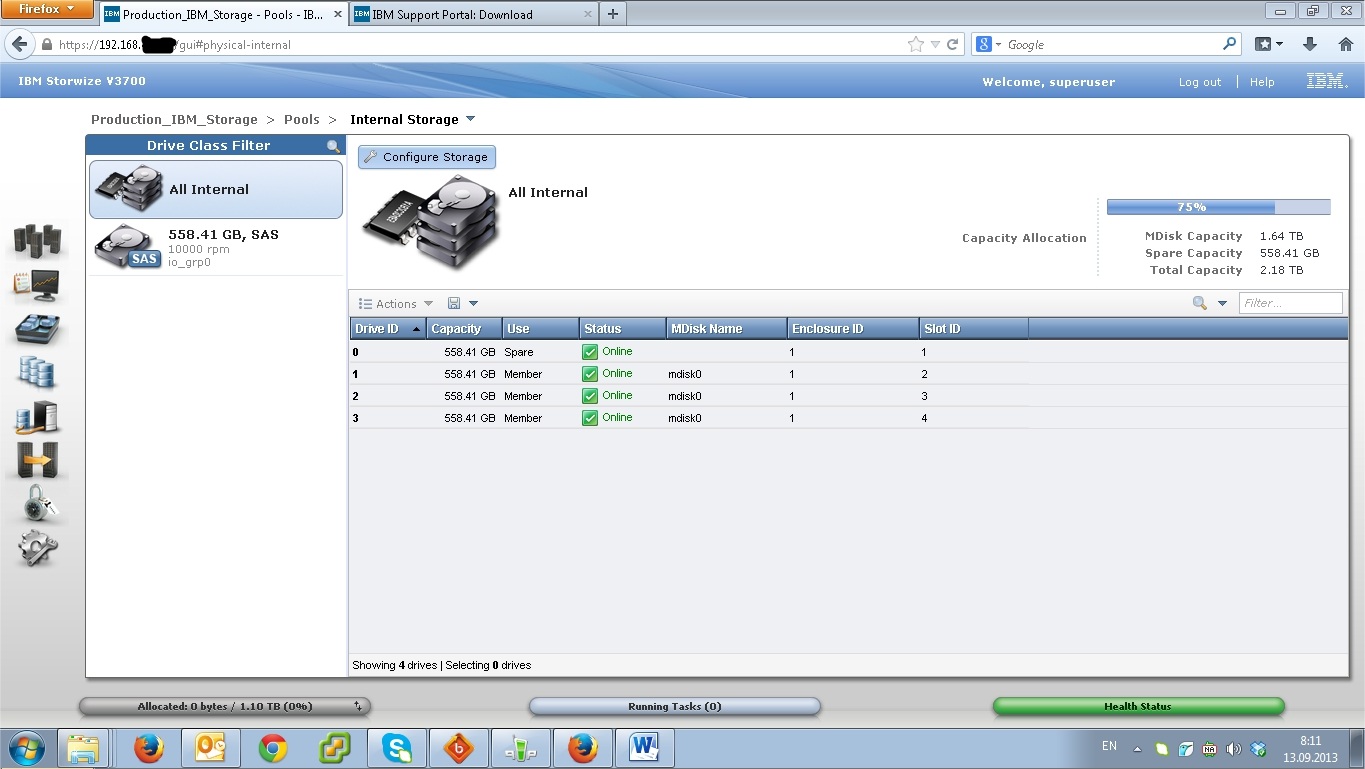

Получаем 4 свободных диска, из которых предстоит создать RAID 10

9

Нажимаем Configure Storage, затем выбираем какой именно RAID мы хотим создать и сколько дисков будет задействовано под него.

10

Чтобы не запутаться в терминах. Из свободных дисков мы создаем RAID или array, получившееся свободное пространство это Pool. Затем сам пространство пула будем нарезать на кусочки, так называемые LUN-ы или Volume и вот их уже можно будет презентовать серверам (хостам).

11

12

13

На скриншоте не видно, но мы задаем размер LUN-а

14

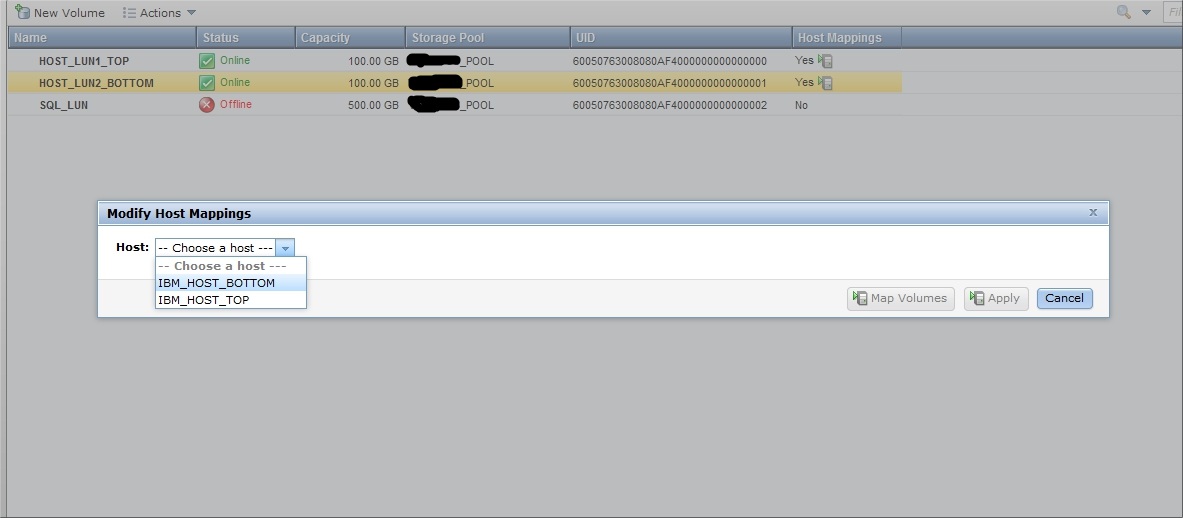

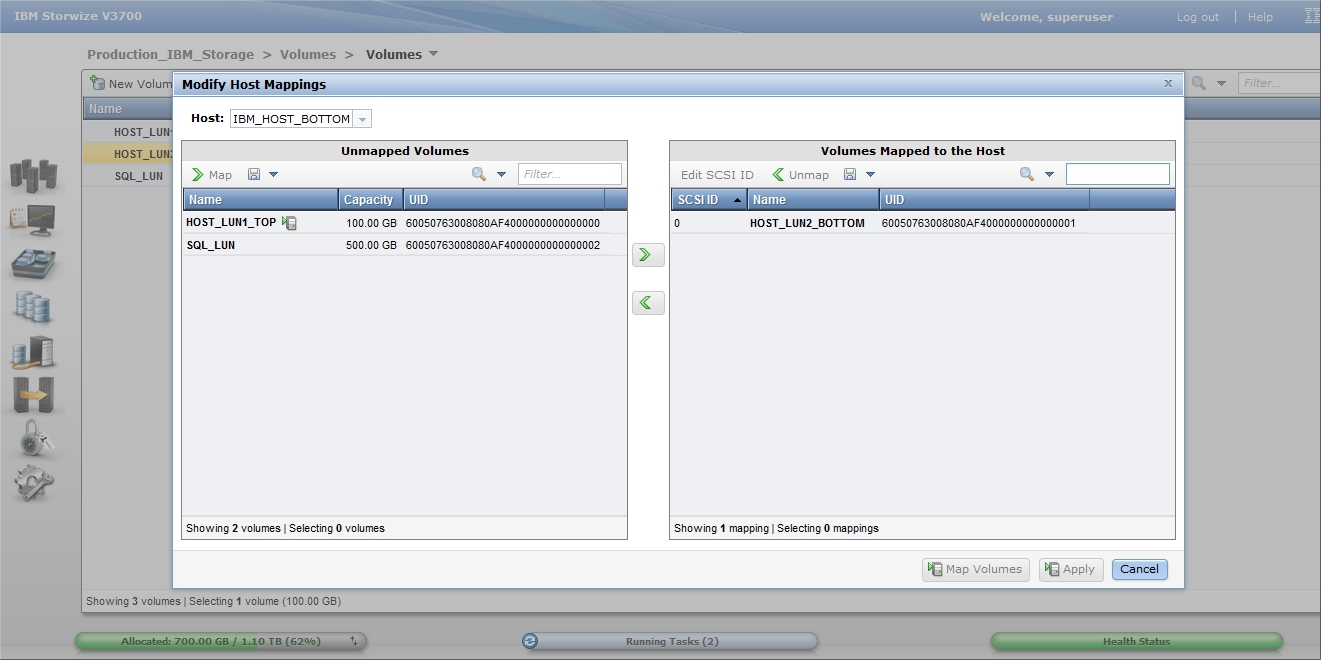

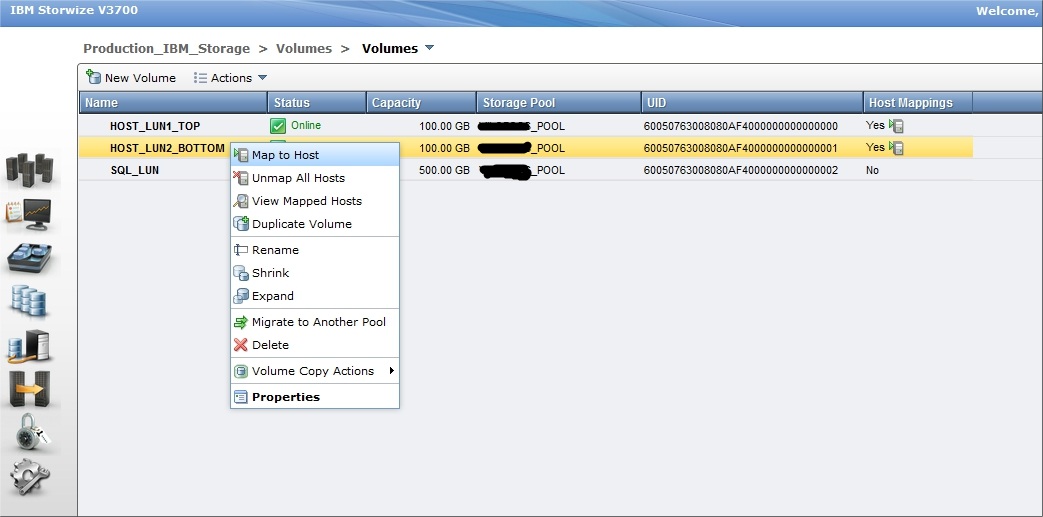

Как и было задумано, два по 100Gb под операционные системы серверов. И один общий размером 500Gb для создания кластера MS SQL 2012

15

У нас два сервера, которые подключены к Storwize v3700 по SAS

16

Таким образом добавляем оба сервера, у каждого два идентификатора.

17

На скриншоте HOST_LUN_TOP предназначен только для первого сервера, т.к. на него будет установлена его операционная система. И второму серверу этот LUN видеть нельзя.

В отличии от SQL_LUN, который должен быть доступен обоим серверам, ведь на нем будут располагаться базы данных MS SQL кластера.

18

В любой момент можно посмотреть и изменить права доступа на LUN (Host Mapping)

19

На этом настройку СХД можно считать законченной.

Можно на сервере начинать установку Windows server 2012 и при выборе жесткого диска будут доступны два LUN-а с системы хранения, один размером 100Гб, второй 500Гб. Это будет означать, что настройка прошла успешно.

Совсем

недавно IBM выпустила

обновление программного обеспечения для storwize V3700, за номером 7.1.Х.Х добавляющее

поддержку подключения SAS хостов и возможность сконфигурировать порты FC для

определенных типов трафика, а так же вносящее большое количество исправлений,

полный список которых вы можете просмотреть в документе V7.1.0.2 Release Note.

http://delivery04.dhe.ibm.com/sar/CMA/SDA/03vwo/0/V3700_7102_release_note.txt

Прошивка:

http://www-933.ibm.com/support/fixcentral/swg/selectFixes?product=ibm/Storage_Disk/IBM+Storwize+V3700&release=All&platform=All&function=all

Нам конечно

же захотелось опробовать возможность подключения по SAS, заодно измерив производительность в

среде виртуализации на базе VMware vSphere, и Windows Server 2012 установленной непосредственно

на HDD сервера, а так же проверить насколько

улучшит ситуацию использование максимально возможных 8Gb (в базе 4Gb ) кэша на тестируемой нами CXД. Предварительно обновив прошивку на

V3700 до версии 7.1.0.2

и организовав RAID10 из восьми дисков ( 600GB 2.5In 10K rpm 6Gb SAS).

В

качестве подключаемых по SAS хостов были использованы два сервера IBM Express

x3650 M4, 2x Xeon E5-2603 1.8GHz, 16Gb ОЗУ, 2х IBM 6Gb SAS HBA.

После

подключения кабелем (мы использовали Adaptec ACK-E-HDmSAS-mSAS-2M) и установки

соединения, в графическом интерфейсе СХД создаем SAS хост, к которому и добавляем тестируемый

LUN.

На первый

сервер была установлена операционная система Windows 2012R2 Datacenter, для теста мы опробовали службу MPIO самой системы и предлагаемый SDDDSM

пакет от IBM, особой разницы в производительности замечено не было, разве что при

использовании стандартной службы MPIO windows есть возможность поиграться с

политиками MPIO.

А на второй

сервер гипервизор VMware ESXi 5.1, с виртуальной машиной идентичной первому

серверу.

Измерения

производились на 100Gb логическом

диске с файловой системой NTFS и стандартным размером кластера, программами Iometer 2006.07.27 (тест100% Random-8k-70%Read, 30% Write, Outstanding I/OS= 64) и утилитой CrystalDiskMark 3.0.1 X64.

По

результатам iometer можно

видеть совсем незначительное преимущество за тестом проведенным в среде

виртуализации VMware vSphere перед тестом в Windows и двукратное увеличение производительности c 8 Gb кэша на СХД.

CrystalDiskMark в

тестах на скорость передачи данных в линейном чтении и записи определил в

лидеры виртуальный стенд, а вот в более тяжелых задачах с произвольными

операциями чтения — записи, и большей глубиной очереди, явный победитель

физическая машина с логическим диском на СХД имеющим 8Gb кэша.

Та же ситуация

и в тестах на количество операций ввода – вывода в секунду, в более сложных

задачах 8Gb кэша

на СХД значительно увеличивают производительность диска.

А для

сравнения и ознакомления приведем несколько результатов теста логического диска

презентуемого Windows 2012 по ISCSI, тест RealLife немного отличается от предыдущих

процентным соотношением последовательных и произвольных операций чтения –

записи.

Как мы видим

здесь так же происходит двукратное увеличение измеряемых IOPS при расширении до 8Gb кэша на Storwize V3700.

Ну а

скорость передачи данных традиционно не высока по ISCSI, что обусловлено самим протоколом,

способом тестирования и шириной канала.

В завершении хотелось лишь отметить что подключение по

SAS реализовано

просто и стабильно, настройка ни каких затруднений не вызывает, а IBM Storwize V3700 теперь может похвастаться поддержкой очень

востребованного протокола передачи данных.